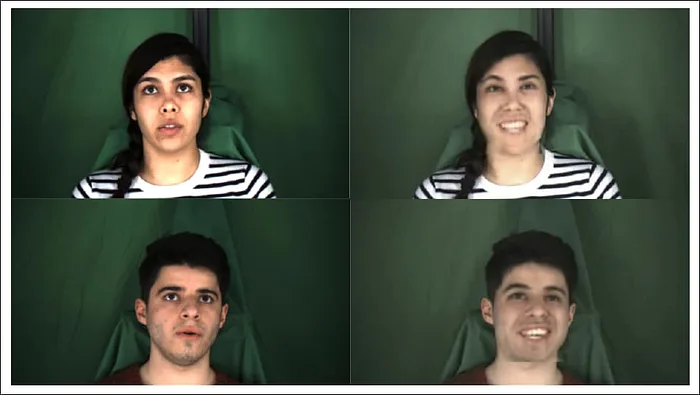

Wav2Lip-Emotion mantiene la sincronizzazione delle labbra del dialogo audio video originale mentre trasforma le espressioni associate

L’alba delle emozioni deepfaked

I ricercatori hanno sviluppato una nuova tecnica di apprendimento automatico per imporre arbitrariamente nuove emozioni sui volti nei video, adattando le tecnologie esistenti emerse di recente come soluzioni per abbinare i movimenti delle labbra al doppiaggio in lingua straniera.

La ricerca è una collaborazione alla pari tra la Northeastern University di Boston e il Media Lab del MIT e si intitola Invertable Frowns: Video-to-Video Facial Emotion Translation . Sebbene i ricercatori ammettano che la qualità iniziale dei risultati debba essere sviluppata attraverso ulteriori ricerche, affermano che la tecnica, chiamata Wav2Lip-Emotion, è la prima del suo genere ad affrontare direttamente la modifica dell’espressione a video completo attraverso tecniche di rete neurale.

Il codice di base è stato rilasciato su GitHub, anche se i checkpoint del modello verranno aggiunti in seguito al repository open source, promettono gli autori.

Video singolo come dati di origine

In teoria, tali manipolazioni sono ottenibili ora attraverso un corposo training sui tradizionali repository di deepfake come DeepFaceLab o FaceSwap . Tuttavia, il flusso di lavoro standard implicherebbe l’uso di un’identità alternativa all’identità “bersaglio”, come un attore che impersona il bersaglio, le cui espressioni sarebbero trasferite a un altro individuo, insieme al resto della performance. Inoltre, di solito sarebbero necessarie tecniche di clonazione della voce deepfake per completare l’illusione.

Inoltre, cambiare effettivamente l’espressione di target1>target1 in un unico video sorgente in questi framework popolari comporterebbe la modifica dei vettori di allineamento facciale in un modo che queste architetture attualmente non facilitano.

Wav2Lip-Emotion mantiene la sincronizzazione delle labbra del dialogo audio video originale mentre trasforma le espressioni associate .

Invece, Wav2Lip-Emotion cerca efficacemente di “copiare e incollare” le espressioni relative alle emozioni da una parte di un video e sostituirle in altri punti, con una frugalità autoimposta dei dati di origine che alla fine ha lo scopo di offrire un metodo a basso sforzo per manipolazione dell’espressione

In seguito potrebbero essere sviluppati modelli offline che vengono addestrati su video alternativi dell’oratore, ovviando alla necessità che un qualsiasi video contenga una “tavolozza” di stati di espressione con cui manipolare il video.

Scopi potenziali

Gli autori suggeriscono una serie di applicazioni per la modifica dell’espressione, incluso un filtro video dal vivo per compensare gli effetti di PTSD e chi soffre di paralisi facciale. Il documento osserva:

‘Gli individui con o senza espressioni facciali inibite possono trarre beneficio dalla regolazione delle proprie espressioni per adattarsi meglio alle loro circostanze sociali. Si potrebbe voler modificare le espressioni nei video mostrati loro. Gli oratori potrebbero urlarsi l’un l’altro durante una videoconferenza, ma tuttavia vogliono raccogliere il contenuto nel loro scambio senza le espressioni sgradevoli. Oppure un regista potrebbe voler aumentare o diminuire le espressioni di un attore».

Poiché l’espressione facciale è un indicatore chiave e fondamentale dell’intento , anche laddove può abradere contro le parole pronunciate, la capacità di alterare l’espressione offre anche, in una certa misura, la capacità di cambiare il modo in cui viene ricevuta la comunicazione .

Lavoro precedente

L’interesse per l’alterazione delle espressioni di apprendimento automatico risale almeno al 2012, quando una collaborazione tra Adobe, Facebook e la Rutgers University ha proposto un metodo per alterare le espressioni utilizzando un approccio di ricostruzione della geometria 3D basato su Tensor, che ha imposto laboriosamente una mesh CGI su ogni fotogramma di un video di destinazione per effettuare la modifica.

Sebbene i risultati fossero promettenti, la tecnica era onerosa e le risorse necessarie erano considerevoli. A questo punto, la CGI era molto più avanti degli approcci basati sulla visione artificiale per dirigere lo spazio delle caratteristiche e la manipolazione dei pixel.

Più strettamente correlato al nuovo documento è MEAD , un modello di dataset e generazione di espressioni rilasciato nel 2020, in grado di generare video “talking-head”, ma senza il livello di sofisticatezza che è potenzialmente ottenibile modificando direttamente il video sorgente effettivo.

Nel 2018 un altro documento, intitolato GANimation: Anatomically-aware Facial Animation from a Single Image , è emerso come collaborazione di ricerca accademica tra Stati Uniti e Spagna e ha utilizzato le reti generative di contraddittorio per aumentare o modificare le espressioni solo nelle immagini fisse.

Wav2Lip-Emozione

Invece, il nuovo progetto si basa su Wav2Lip, che ha ottenuto pubblicità nel 2020 offrendo un potenziale metodo per risincronizzare il movimento delle labbra per accogliere nuovi input vocali ( o canzoni ) che non sono mai stati presenti nel video originale.

L’ architettura originale di Wav2Lip è stata addestrata su un corpus di frasi pronunciate dagli archivi della BBC. Per adattare Wav2Lip al compito di alterazione dell’espressione, i ricercatori hanno “sintonizzato” l’architettura sul set di dati MEAD sopra menzionato.

MEAD consiste in 40 ore di video con 60 attori che leggono la stessa frase mentre eseguono una varietà di espressioni facciali. Gli attori provengono da 15 paesi diversi e offrono una gamma di caratteristiche internazionali volte ad aiutare il progetto (e i progetti derivati) a produrre sintesi espressive applicabili e ben generalizzate.

Al momento della ricerca, MEAD aveva rilasciato solo la prima parte del set di dati, con 47 persone che eseguivano espressioni come “arrabbiato”, “disgusto”, “paura”, “disprezzo”, “felice”, “triste” e “sorpresa”. ‘. In questa prima uscita in un nuovo approccio, i ricercatori hanno limitato l’ambito del progetto alla sovrapposizione o all’alterazione delle emozioni percepite “felice” e “triste”, poiché queste sono le più facilmente riconoscibili.

Metodo e risultati

L’architettura originale Wav2Lip sostituisce solo la parte inferiore del viso, mentre Wav2Lip-Emotion sperimenta anche una maschera sostitutiva completa del viso e la sintesi dell’espressione. Pertanto è stato necessario per i ricercatori modificare ulteriormente i metodi di valutazione integrati, poiché questi non erano progettati per una configurazione integrale.

Gli autori migliorano il codice originale mantenendo l’input audio originale, mantenendo la coerenza del movimento delle labbra.

L’elemento generatore dispone di un codificatore di identità, codificatore vocale e decodificatore facciale, in conformità con il lavoro precedente. L’elemento vocale è codificato in aggiunta come convoluzioni 2D impilate che vengono successivamente concatenate ai frame associati.

Oltre all’elemento generativo, l’architettura modificata presenta tre componenti discriminatori principali, che mirano alla qualità della sincronizzazione labiale, un elemento obiettivo dell’emozione e un obiettivo della qualità visiva contrapposto.

Per la ricostruzione completa del viso, il lavoro originale di Wav2Lip non conteneva precedenti e quindi il modello è stato addestrato da zero. Per l’allenamento della faccia inferiore (mezza maschera), i ricercatori hanno proceduto dai checkpoint inclusi nel codice Wav2Lip originale.

Oltre alla valutazione automatica, i ricercatori hanno utilizzato l’opinione di crowdsourcing fornita da una piattaforma di servizi semiautomatica. I lavoratori hanno generalmente valutato molto bene l’output in termini di riconoscimento delle emozioni sovrapposte, riportando solo valutazioni “moderate” per la qualità dell’immagine.

Gli autori suggeriscono che, oltre a migliorare la qualità del video generato con ulteriori perfezionamenti, le future iterazioni del lavoro potrebbero comprendere una gamma più ampia di emozioni e che il lavoro potrebbe essere ugualmente applicato in futuro a dati e set di dati di origine etichettati o dedotti automaticamente, portando, infine, , a un sistema autentico in cui le emozioni possono essere aumentate o diminuite secondo il capriccio dell’utente, o infine sostituite da emozioni contrastanti rispetto al video originale.