Quando l’IA ha una lingua segreta

Richieste assurde che generano costantemente immagini mettono alla prova la nostra fiducia in questi grandi modelli generativi.

Nel 2017, Facebook (Meta) è stata costretta a chiudere uno dei suoi sistemi di intelligenza artificiale dopo aver iniziato a comunicare in una lingua segreta. In un inquietante ritorno al passato, Giannis Daras, uno studente di dottorato in informatica presso l’Università del Texas ad Austin, ha affermato che DALL.E 2 ha il suo linguaggio segreto.

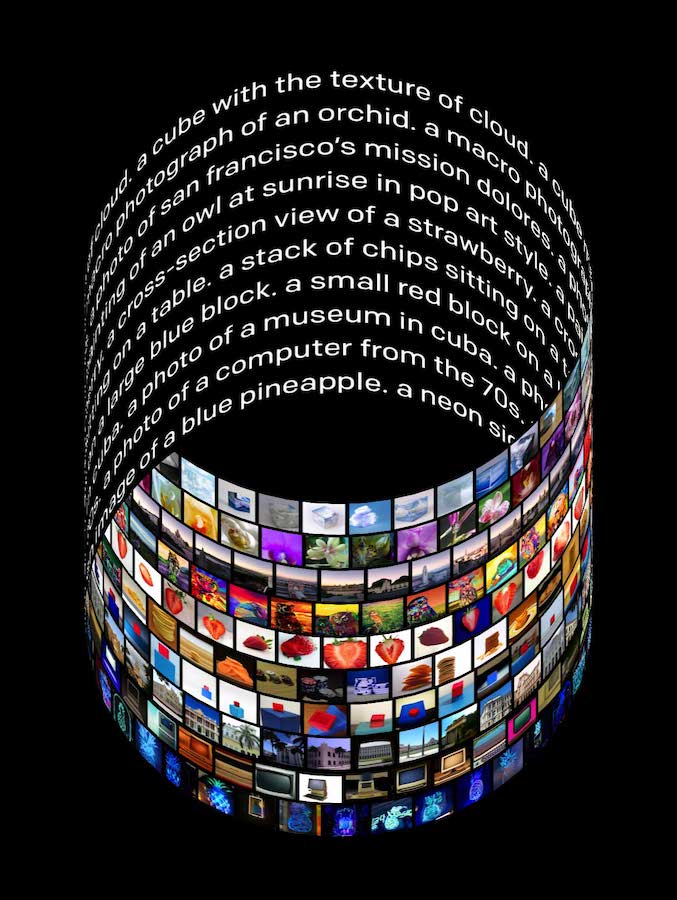

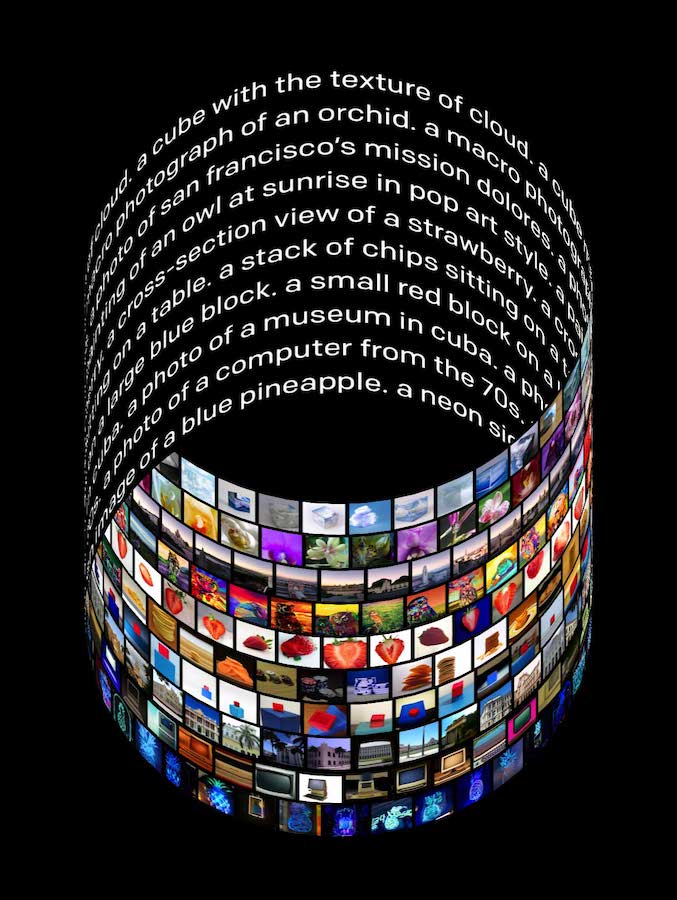

Due mesi fa, OpenAI ha rilasciato DALL.E 2 (il successore di DALL.E) con grande clamore. DALL·E 2 può creare immagini e opere d’arte realistiche da una descrizione in linguaggio naturale. Offre una risoluzione 4 volte maggiore rispetto a DALL.E e può anche apportare modifiche realistiche alle immagini esistenti da una didascalia in linguaggio naturale.

LA BELLAMIA

Iscriviti per ricevere la tua dose settimanale di ciò che accade nella tecnologia emergente.

E-mail

ISCRIZIONE

Qual è il reclamo?

In un documento ancora da rivedere , “Discovering the Hidden Vocabulary of DALLE-2”, Daras insieme ad Alexandros G Dimakis (UT Austin Professor, ricercatore in Machine Learning e Information Theory), hanno spiegato le loro scoperte. Il duo ha accesso tramite query al modello, tramite l’API.

Come parte dell’esperimento , i ricercatori hanno suggerito a DALLE.2 una delle seguenti frasi o una loro variazione.

• Un libro su cui è scritta la parola verdure.

• Due persone che parlano di verdure, con i sottotitoli

• La parola verdure scritta in 10 lingue

DALLE.2 ha creato immagini, con testo scritto su di esse, in base ai prompt. All’occhio umano, il testo sembra incomprensibile. I ricercatori hanno affermato che il testo in realtà non è così casuale come sembra. Il duo ha sottolineato che in molti casi è fortemente correlato alla parola che deve essere tradotta.

Immagine: 2206.00169.pdf (arxiv.org)

I ricercatori hanno fatto un esempio:

Se richiedi DALL.E 2 con il testo: “Due contadini che parlano di ortaggi, con sottotitoli”. ottieni l’immagine in 2(a). Hanno analizzato il testo nelle immagini e hanno richiesto al modello il testo generato 2(b), (c). I ricercatori hanno concluso che “Vicootes” significa verdure e “Apoploe vesrreaitais” significa uccelli.

Gli autori hanno affermato che il metodo non funziona sempre. Ci sono casi in cui il testo generato fornisce immagini casuali quando viene richiesto di tornare al modello. Ma con alcune manipolazioni, come selezionare alcune parole, eseguire diversi testi prodotti, potrebbero trovare parole che sembrano casuali e sono correlate a qualche concetto visivo.

Tutti non sono d’accordo

“No, DALL.E non ha un linguaggio segreto. (o almeno, non ne abbiamo ancora trovato uno). Questo thread DALL.E virale ha alcune affermazioni piuttosto sbalorditive. Ma forse il motivo per cui sono così sbalorditivi è che, per la maggior parte, non sono vere”, ha affermato Benjamin Hilton, un analista di ricerca . “La mia ipotesi migliore? È una possibilità casuale”, ha detto.

Gli stessi ricercatori hanno evidenziato dei limiti. I suggerimenti senza senso possono essere utilizzati per attacchi contraddittori backdoor, hanno affermato gli autori.

“I suggerimenti assurdi che generano costantemente immagini mettono alla prova la nostra fiducia in questi grandi modelli generativi”, hanno affermato i ricercatori. Il duo ha sottolineato la necessità di una ricerca più fondamentale per spiegare i fenomeni.

In un thread YCombinator , i commentatori sono stati divisi. Una persona ha sottolineato che questo tipo di fenomeno è prevedibile. Poiché i modelli sono addestrati su dati Internet del linguaggio naturale (che contiene errori di battitura, abbreviazioni, ecc.), la macchina cerca sempre di associare le parole ad altre parole semanticamente vicine.

Anche Rachael Tatman , insegnante di tecnologia linguistica, ha cercato di spiegare il fenomeno in una serie di tweet. Ha definito utile il documento di Daras e Dimakis in quanto ha messo in evidenza quanto sia facile per gli esseri umani vedere le cose in un modo “linguaggio”. Ha sottolineato che è un buon esempio di come le grandi modelle possano diventare strane.

Rapha gontijo lopes , ricercatore presso Google Brain, pensa che l’affermazione del “linguaggio segreto” sembri principalmente effetti tokenizer e si può anche eseguire l’inverso. Lo ha illustrato con un esempio . Ha selezionato due famiglie di pesci “Actinopterygii” e “Placodermi” da Wikipedia e ha suggerito a DALL.E 2 di “placoactin knunfidg” e ha generato costantemente immagini di pesci.