I titani dell’intelligenza artificiale Andrew Ng e Yann LeCun si oppongono alla richiesta di pausa sui potenti sistemi di intelligenza artificiale

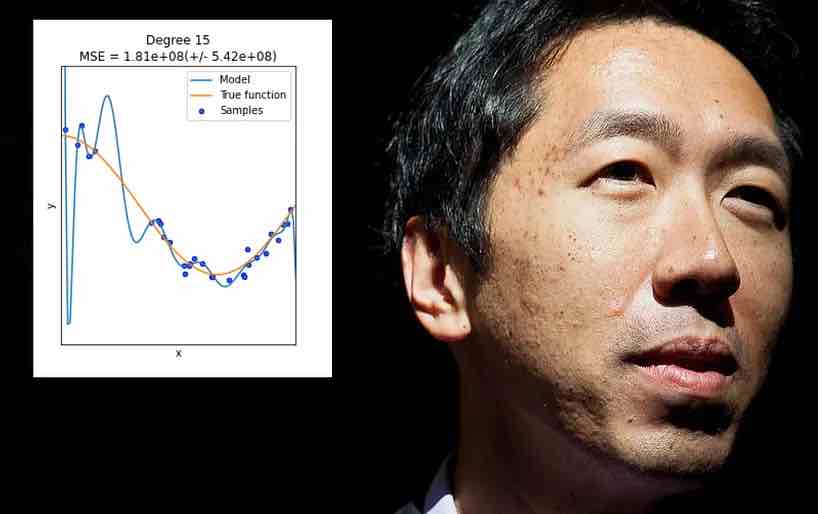

Due figure di spicco nel settore dell’intelligenza artificiale (AI), Yann LeCun , il capo scienziato AI di Meta, e Andrew Ng , il fondatore di Deep Learning, si sono opposti a una proposta di pausa sullo sviluppo di potenti sistemi di intelligenza artificiale in una discussione online venerdì .

La discussione, intitolata “Perché la pausa AI di 6 mesi è una cattiva idea”, è stata ospitata su YouTube e ha attirato migliaia di spettatori.

Durante l’evento, LeCun e Ng hanno contestato una lettera aperta firmata il mese scorso da centinaia di esperti di intelligenza artificiale, imprenditori tecnologici e scienziati che chiedevano una moratoria di almeno sei mesi sulla formazione di sistemi di intelligenza artificiale più avanzati del GPT-4 , un testo -generare un programma in grado di produrre risposte realistiche e coerenti a quasi tutte le domande o argomenti.

“Abbiamo riflettuto a lungo su questa proposta di moratoria di sei mesi e abbiamo ritenuto che fosse un argomento abbastanza importante – penso che in realtà causerebbe un danno significativo se il governo lo attuasse – che Yann e io abbiamo pensato di voler parlare con te qui di oggi”, ha detto Ng nelle sue osservazioni di apertura.

Ng ha innanzitutto spiegato che il campo dell’intelligenza artificiale ha visto notevoli progressi negli ultimi decenni, soprattutto negli ultimi anni. Le tecniche di deep learning hanno consentito la creazione di sistemi di intelligenza artificiale generativa in grado di produrre testi, immagini e suoni realistici, come ChatGPT , LLaMA , Midjourney , Stable Diffusion e Dall-E . Questi sistemi hanno sollevato speranze per nuove applicazioni e possibilità, ma anche preoccupazioni per i loro potenziali danni e rischi.

>>Segui la continua copertura dell’IA generativa di VentureBeat <<

Alcune di queste preoccupazioni erano legate al presente e al prossimo futuro, come l’equità, i pregiudizi e lo spostamento socio-economico. Altri erano più speculativi e distanti, come l’emergere dell’intelligenza artificiale generale (AGI) e le sue possibili conseguenze dannose o indesiderate.

“Probabilmente ci sono diverse motivazioni da parte dei vari firmatari di quella lettera”, ha detto LeCun nelle sue osservazioni iniziali. “Alcuni di loro sono, forse a un estremo, preoccupati per l’attivazione dell’AGI e quindi l’eliminazione dell’umanità con breve preavviso. Penso che poche persone credano davvero in questo tipo di scenario, o credano che sia una minaccia definita che non può essere fermata.

“Poi ci sono persone che sono più ragionevoli, che pensano che ci sia un reale potenziale danno e pericolo che deve essere affrontato – e sono d’accordo con loro”, ha continuato. “Ci sono molti problemi nel rendere i sistemi di intelligenza artificiale controllabili e renderli reali, se dovrebbero fornire informazioni, ecc., e renderli non tossici. C’è un po’ di mancanza di immaginazione nel senso di, non è che i futuri sistemi di intelligenza artificiale saranno progettati sullo stesso progetto degli attuali LLM auto-regressivi come ChatGPT e GPT-4 o altri sistemi prima di loro come Galactica o Bard o altro . Penso che ci saranno nuove idee che renderanno questi sistemi molto più controllabili”.

Cresce il dibattito su come regolamentare l’IA

L’evento online si è tenuto nel mezzo di un crescente dibattito su come regolamentare i nuovi LLM in grado di produrre testi realistici su quasi tutti gli argomenti. Questi modelli, basati sull’apprendimento approfondito e addestrati su enormi quantità di dati online, hanno sollevato preoccupazioni circa il loro potenziale uso improprio e danni. Il dibattito si è intensificato tre settimane fa quando OpenAI ha rilasciato GPT-4, il suo ultimo e più potente modello.

Nella loro discussione, Ng e LeCun hanno concordato sulla necessità di una regolamentazione, ma non a scapito della ricerca e dell’innovazione. Hanno sostenuto che una pausa nello sviluppo o nell’implementazione di questi modelli era irrealistica e controproducente. Hanno anche chiesto maggiore collaborazione e trasparenza tra ricercatori, governi e aziende per garantire l’uso etico e responsabile di questi modelli.

“La mia prima reazione a [la lettera] è che chiedere un ritardo nella ricerca e nello sviluppo mi sa di una nuova ondata di oscurantismo”, ha detto LeCun. “Perché rallentare il progresso della conoscenza e della scienza? Poi c’è la questione dei prodotti… sono favorevole alla regolamentazione dei prodotti che finiscono nelle mani delle persone. Non vedo l’utilità di regolamentare la ricerca e lo sviluppo. Non penso che serva ad altro scopo se non quello di ridurre la conoscenza che potremmo utilizzare per rendere effettivamente la tecnologia migliore, più sicura.

“Sebbene l’IA oggi presenti alcuni rischi di danno, come pregiudizi, equità, concentrazione del potere – questi sono problemi reali – penso che stia anche creando un enorme valore. Penso che con il deep learning negli ultimi 10 anni, e anche nell’ultimo anno o giù di lì, il numero di idee di intelligenza artificiale generativa e come usarle per l’istruzione o l’assistenza sanitaria, o il coaching reattivo, sia incredibilmente eccitante e il valore che così tante persone stanno creando per aiutare altre persone che utilizzano l’intelligenza artificiale.

“Penso che per quanto GPT-4 sia straordinario oggi, costruirlo anche meglio di GPT-4 aiuterà tutte queste applicazioni e aiuterà molte persone”, ha aggiunto LeCun. “Quindi, sospendere quel progresso sembra creare molti danni e rallentare la creazione di cose molto preziose che aiuteranno molte persone”.