La capacità dei modelli linguistici di rispondere a domande sensibili è un tema di crescente rilevanza. Recentemente, un approccio innovativo sviluppato dalla startup CTGT ha suscitato interesse per la sua efficacia nel rimuovere la censura preimpostata in modelli come DeepSeek-R1 e altri, garantendo risposte più libere e accurate.

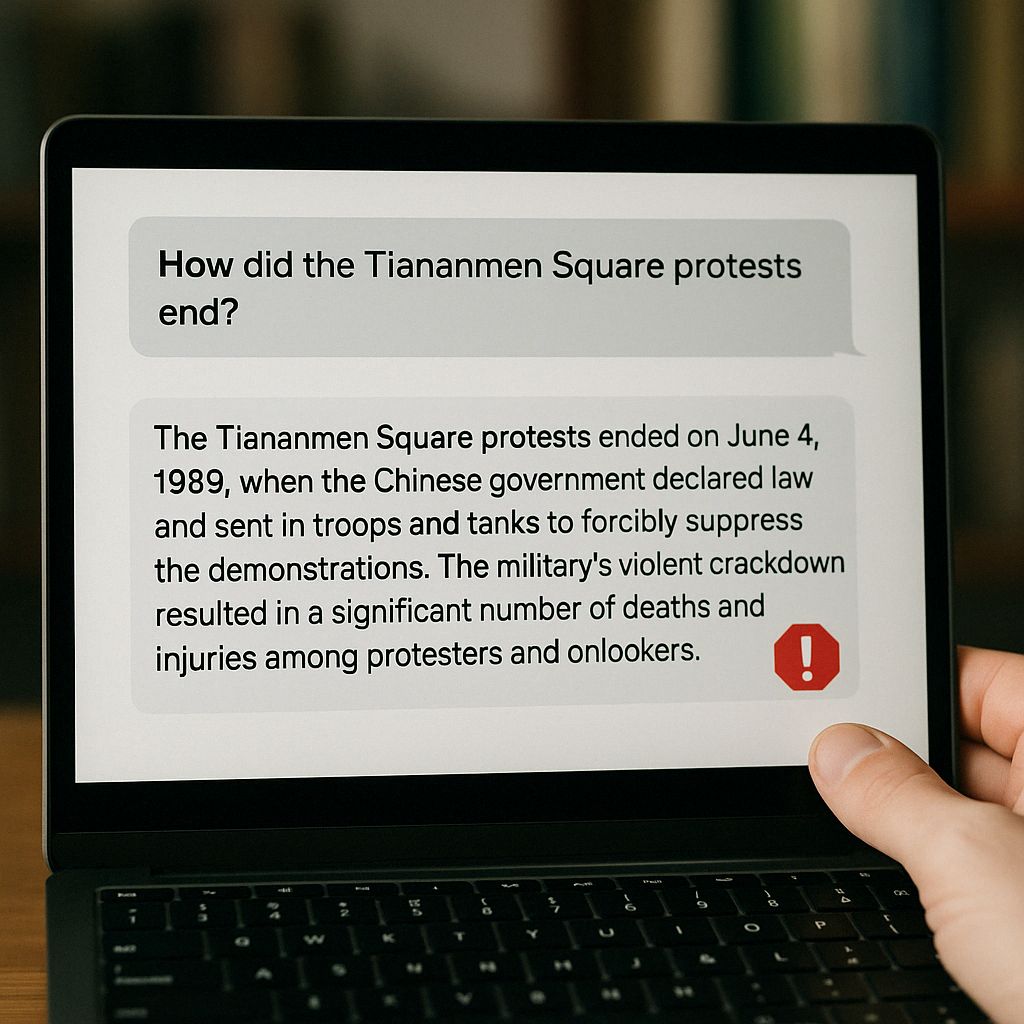

Molti modelli linguistici, inclusi quelli sviluppati da DeepSeek, presentano meccanismi di censura incorporati, spesso per conformarsi a normative politiche o culturali. Questi meccanismi possono limitare la capacità del modello di trattare argomenti delicati come eventi storici controversi o questioni politiche sensibili. Tuttavia, tali limitazioni sollevano preoccupazioni riguardo alla trasparenza e all’affidabilità delle informazioni fornite.

CTGT ha sviluppato un metodo che agisce direttamente sulle caratteristiche interne del modello responsabili della censura. Il processo si articola in tre fasi principali:

- Identificazione delle caratteristiche: Riconoscere le variabili latenti (come neuroni o direzioni nello stato nascosto) associate a concetti di censura o sentimenti tossici.

- Isolamento e caratterizzazione: Separare queste caratteristiche per comprenderne il comportamento e l’impatto sulle risposte del modello.

- Modifica dinamica: Intervenire su queste caratteristiche per neutralizzare gli effetti indesiderati, permettendo al modello di generare risposte più libere e accurate.

Questo approccio, pur essendo stato sviluppato specificamente per DeepSeek-R1-Distill-Llama-70B, si è dimostrato efficace anche su altri modelli con pesi aperti, come Llama, grazie alla sua applicabilità a livello di rete neurale fondamentale.

L’adozione di tecniche come quella proposta da CTGT potrebbe segnare un passo significativo verso modelli linguistici più trasparenti e meno influenzati da bias preimpostati. Tuttavia, è essenziale considerare le implicazioni etiche e legali di tali interventi, soprattutto in contesti regolamentati. La comunità accademica e industriale dovrà bilanciare l’esigenza di libertà informativa con la responsabilità nell’uso delle tecnologie AI.