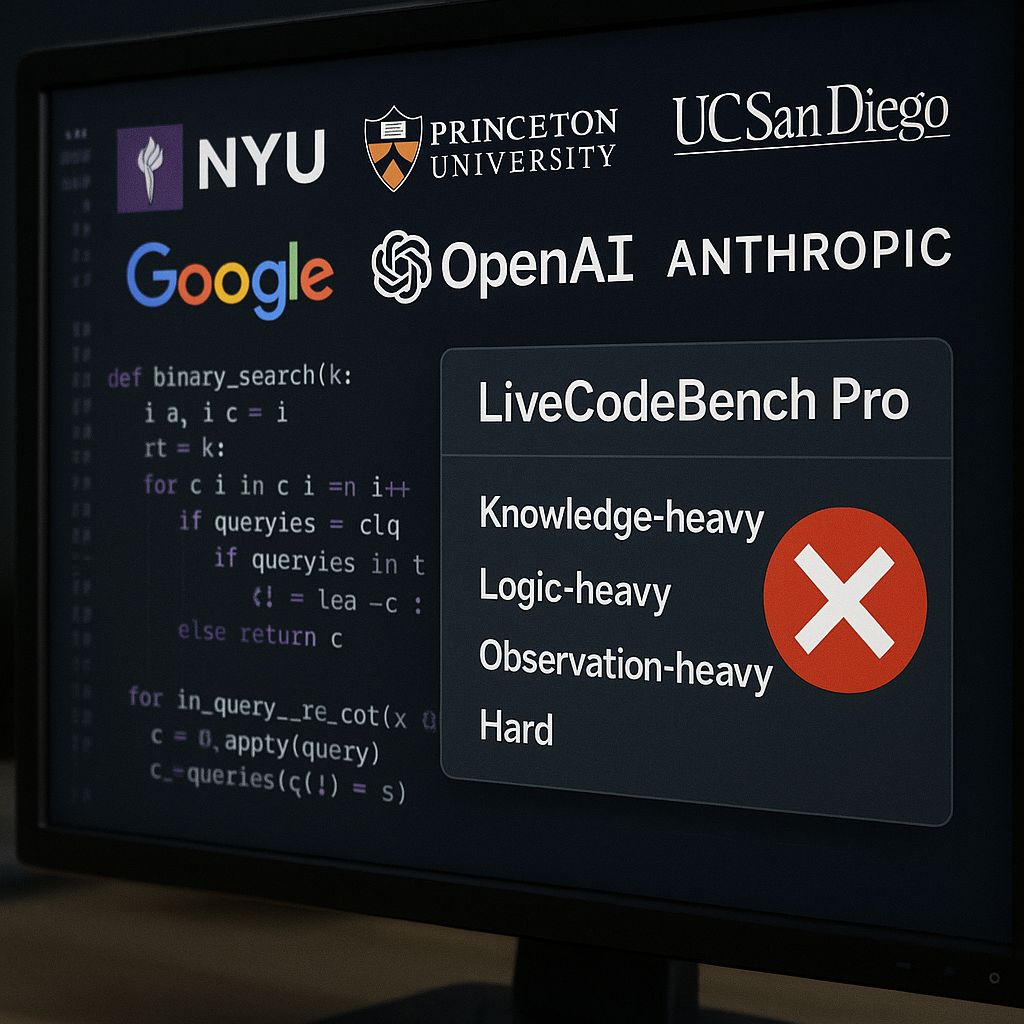

Nonostante l’entusiasmo crescente per le capacità dei modelli linguistici di grandi dimensioni (LLM) nel campo della programmazione, un recente studio ha evidenziato una realtà ben diversa. Una ricerca congiunta tra università prestigiose come la New York University, Princeton, l’Università della California di San Diego e McGill ha rivelato che i principali modelli IA di Google, OpenAI e Anthropic non sono riusciti a risolvere neanche un singolo problema nella categoria “Hard” di un nuovo benchmark chiamato LiveCodeBench Pro .

Il LiveCodeBench Pro è stato progettato per valutare le capacità dei modelli IA in scenari di programmazione avanzata, utilizzando problemi provenienti direttamente da concorsi di livello mondiale e annotati da medagliati olimpici in informatica. Questi problemi sono suddivisi in categorie: “Knowledge-heavy”, “Logic-heavy” e “Observation-heavy”. Mentre i modelli IA hanno mostrato una certa competenza nei primi due, hanno fallito completamente nella categoria più impegnativa, che richiede intuizioni originali e capacità di ragionamento avanzato.

I ricercatori hanno identificato diverse ragioni per questi insuccessi. In primo luogo, i modelli tendono a basarsi su pattern appresi dai dati di addestramento, senza una comprensione profonda dei concetti sottostanti. Inoltre, spesso commettono errori concettuali genuini, indicando una mancanza di comprensione algoritmica. Anche quando vengono forniti input di esempio, i modelli non riescono a utilizzarli correttamente, suggerendo una comprensione incompleta delle informazioni fornite.

Nei problemi di difficoltà “Medium”, il modello o4-mini-high di OpenAI ha ottenuto il punteggio più alto, pari al 53,5%. Tuttavia, anche in questi casi, le prestazioni erano limitate. I modelli hanno avuto successo principalmente nei problemi “Knowledge-heavy”, che possono essere risolti applicando template noti. Al contrario, hanno mostrato scarse capacità nei problemi “Observation-heavy”, che richiedono intuizioni nuove e originali.