Il rapido e inarrestabile boom dell’Intelligenza Artificiale Generativa ha imposto alle aziende una corsa all’infrastruttura, in particolare per quanto riguarda le costose e potenti GPU (Graphics Processing Units), il cuore pulsante dei modelli linguistici di grandi dimensioni (LLM) e di altre applicazioni AI complesse. Con sempre più imprese, soprattutto quelle attente alla riservatezza dei dati, che scelgono di ospitare i propri modelli AI in ambienti self-hosted (autogestiti) su piattaforme cloud-native come Kubernetes, è emersa una sfida titanica: la gestione efficiente e la minimizzazione dei costi operativi. È in questo contesto che si inserisce il nuovo AI Infra Product di ScaleOps, una soluzione che sta riscrivendo le regole dell’economia dell’AI, promettendo di ridurre i costi GPU fino al 70% per le grandi organizzazioni.

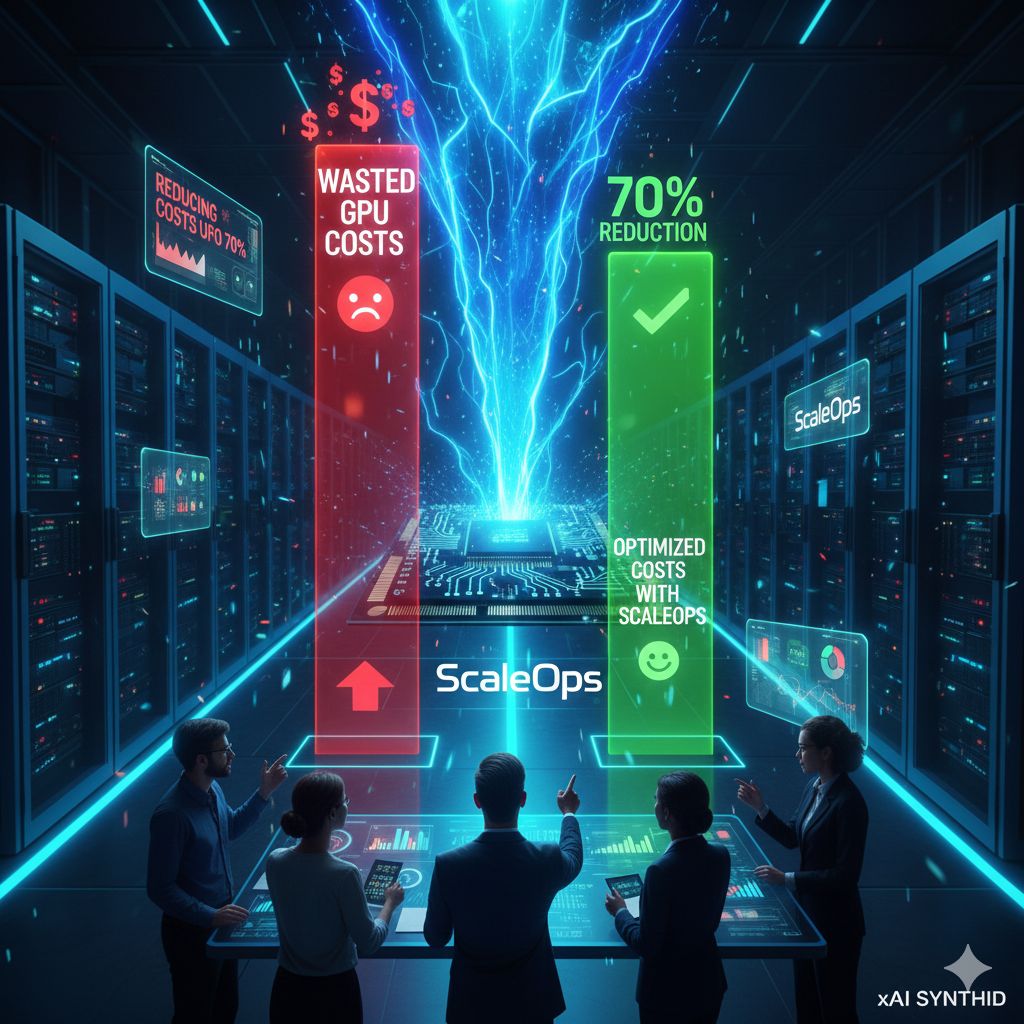

Il problema centrale affrontato da ScaleOps è tanto diffuso quanto costoso: l’inefficienza nell’utilizzo delle GPU. Queste unità di calcolo sono tra le risorse più onerose nel cloud computing e, ironicamente, sono spesso utilizzate in modo estremamente inefficace negli ambienti aziendali. Storicamente, gli engineering team sono costretti a sovra-provisionare le risorse per garantire che i loro modelli AI e LLM abbiano sempre la potenza necessaria per gestire picchi di domanda o carichi di lavoro variabili. Questo approccio cautelativo, unito alla difficoltà di prevedere con precisione l’utilizzo in tempo reale, porta a periodi prolungati di bassa utilizzazione delle GPU. In pratica, le aziende pagano cifre esorbitanti per hardware ad alte prestazioni che rimane spesso inattivo, trasformando una risorsa strategica in uno spreco massiccio di spesa cloud. A questa inefficienza si aggiunge l’onere del tuning manuale continuo, che sottrae tempo prezioso ai team DevOps e AIOps, distraendoli dall’innovazione.

L’AI Infra Product di ScaleOps si presenta come una risposta completa a questa crisi di efficienza. Non si tratta di un semplice strumento di monitoraggio, ma di un gestore di risorse di nuova generazione che utilizza una logica complessa per ottimizzare dinamicamente l’infrastruttura AI. Il cuore della soluzione è la sua capacità di combinare la consapevolezza del contesto applicativo con l’automazione continua in tempo reale.

Invece di basarsi su ipotesi statiche o su regole predefinite, il prodotto ScaleOps analizza in modo intelligente il carico di lavoro effettivo del modello LLM o dell’applicazione GPU-based. Adatta e scala le risorse GPU in tempo reale in base alla domanda dinamica. Quando l’utilizzo è basso, riduce l’allocazione per minimizzare i costi; quando è necessario, garantisce la disponibilità immediata, accelerando persino i tempi di caricamento del modello, un fattore cruciale per le performance e l’esperienza utente. Questa capacità di adattamento continuo elimina la necessità di sovra-provisioning, garantendo che le aziende paghino solo per la potenza di calcolo che stanno effettivamente utilizzando in un dato momento.

L’impatto di questa innovazione si traduce in numeri impressionanti. Secondo i dati aziendali, i primi clienti ad aver adottato l’AI Infra Product di ScaleOps hanno registrato una riduzione dei costi GPU compresa tra il 50% e il 70%. Per le grandi aziende che gestiscono vaste infrastrutture AI, questi risparmi si proiettano in decine di milioni di dollari su base annua, un dato che non può essere ignorato in un’era in cui l’ottimizzazione dei costi, o FinOps, è diventata una priorità strategica, specialmente per l’AI.

Oltre al risparmio economico diretto, la soluzione libera le preziose risorse umane. Automatizzando la complessa e ripetitiva attività di tuning manuale dell’infrastruttura, ScaleOps permette agli ingegneri di dedicare il loro tempo e le loro competenze a compiti di alto valore, come lo sviluppo di nuovi modelli o l’innovazione di prodotto, piuttosto che alla gestione estenuante dei cluster e dei container.

L’AI Infra Product di ScaleOps non è solo un meccanismo per tagliare i costi, ma un vero e proprio fattore abilitante. Rimuovendo la barriera dei costi operativi proibitivi e fornendo una gestione delle risorse efficiente e automatizzata, sta facilitando l’adozione su larga scala di modelli AI self-hosted tra le imprese, permettendo loro di competere con i giganti tecnologici e di mantenere un controllo completo sui propri dati sensibili, trasformando l’AI da un costoso esperimento a una componente sostenibile e fondamentale della loro strategia aziendale.