L’intelligenza artificiale ha rapidamente superato i limiti che un tempo le venivano attribuiti, trasformandosi da mera macchina calcolatrice a entità capace di scrivere testi, comporre musica e persino proporre soluzioni a problemi scientifici complessi. Tuttavia, mentre la sua potenza computazionale cresce in modo esponenziale, il dibattito etico e filosofico converge su un limite intrinseco e, almeno per ora, invalicabile: l’incapacità dell’AI di emettere un vero giudizio. Questa barriera non è di natura tecnica, bensì esistenziale e morale, e definisce chiaramente dove finisce il dominio della macchina e dove inizia l’insostituibile responsabilità dell’uomo.

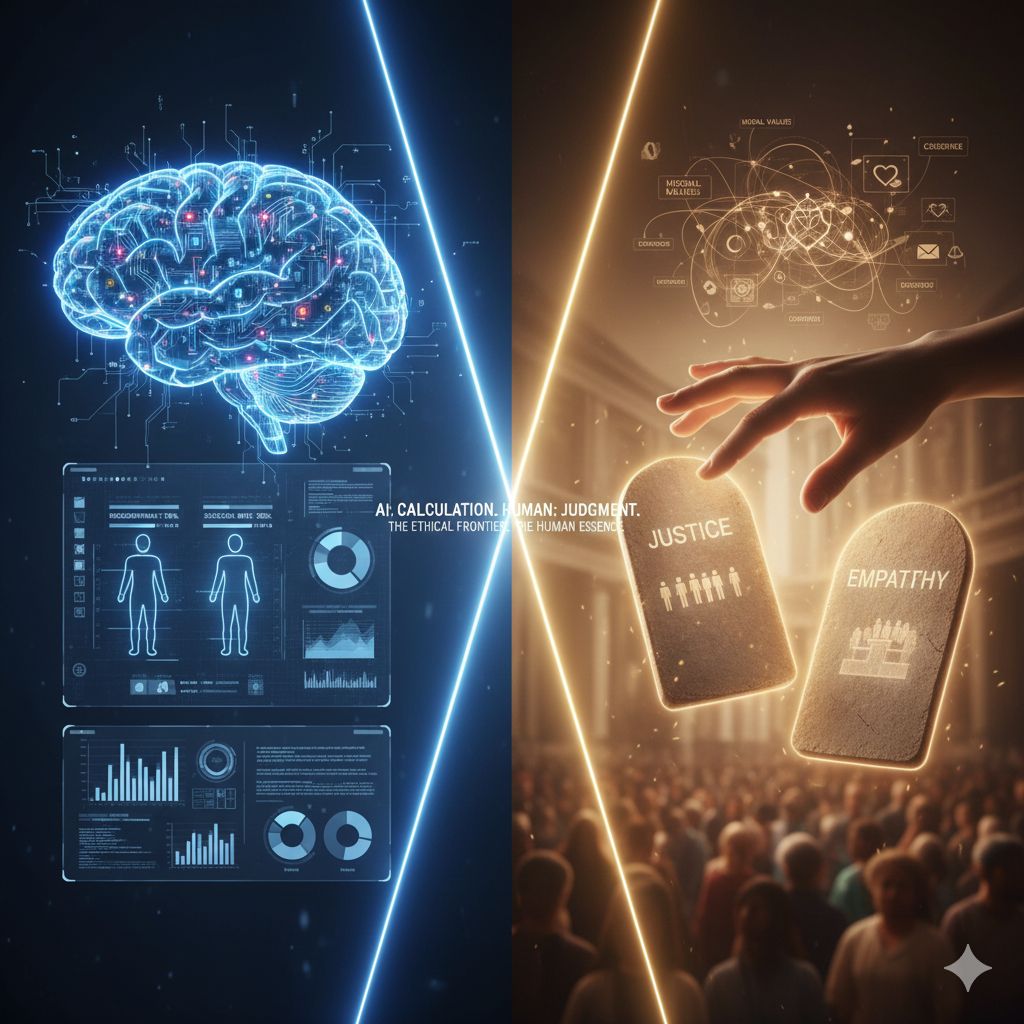

Il cuore del problema risiede nella distinzione fondamentale tra previsione statistica e giudizio valoriale. L’Intelligenza Artificiale eccelle nel primo: è maestra nell’analisi di masse immense di dati, nell’identificazione di pattern e nel calcolo delle probabilità. Quando un algoritmo suggerisce una diagnosi medica o predice la probabilità di recidiva di un imputato, sta compiendo un’operazione di ottimizzazione statistica, scegliendo l’opzione con la massima probabilità di successo o la minore probabilità di errore, secondo i parametri con cui è stato addestrato.

Il giudizio umano, al contrario, non è solo una funzione matematica. Esso affonda le sue radici nella coscienza, nell’esperienza vissuta, nell’empatia, nel senso di giustizia e in un complesso e spesso contraddittorio sistema di valori morali. Decidere se un’azione è “giusta” o “sbagliata”, se un’opera d’arte è “bella” o “significativa”, o se una pena è “equa” richiede la comprensione delle conseguenze umane e sociali al di là del puro calcolo razionale. L’AI, priva di un corpo, di un’esperienza soggettiva del dolore o della gioia e, soprattutto, di un quadro etico autoimposto, non può accedere a questa dimensione. Il suo mondo è fatto di dati e correlazioni; il nostro è fatto di significato e responsabilità.

Questa limitazione diventa particolarmente critica quando l’AI viene introdotta in settori ad alto rischio morale. Nel campo della giustizia, ad esempio, un algoritmo può predire la probabilità di recidiva, ma non può e non deve decidere la pena, poiché quest’ultima è un atto di giustizia che richiede valutazione della colpa, riabilitazione e principi di umanità. In medicina, l’AI può suggerire il trattamento più efficace, ma la scelta finale che coinvolge il bilanciamento tra rischio e beneficio, e la considerazione della volontà del paziente, rimane un atto etico interamente umano. Delegare il giudizio all’algoritmo non farebbe altro che nascondere decisioni profondamente soggettive e potenzialmente viziate, dietro il velo illusorio dell’oggettività scientifica.

Inoltre, il giudizio che l’AI sembra emettere non è altro che il riflesso delle scelte e dei pregiudizi insiti nei dati che la hanno formata. Se i dati di addestramento riflettono iniquità storiche o preferenze estetiche di una cultura dominante, l’AI riprodurrà e, in certi casi, amplificherà tali storture, presentandole con l’autorità di un verdetto algoritmico.

L’Intelligenza Artificiale è uno strumento ineguagliabile per l’analisi e la previsione, capace di assisterci nel prendere decisioni più informate e rapide. Ma la sua vera funzione è quella di supporto e non di sostituzione del processo decisionale umano. Il giudizio, inteso come atto finale di responsabilità etica e morale, è destinato a rimanere l’ultima e più importante prerogativa dell’uomo. Mantenere questa distinzione netta è cruciale per garantire che il progresso tecnologico serva l’umanità senza mai usurparne l’essenza valoriale.