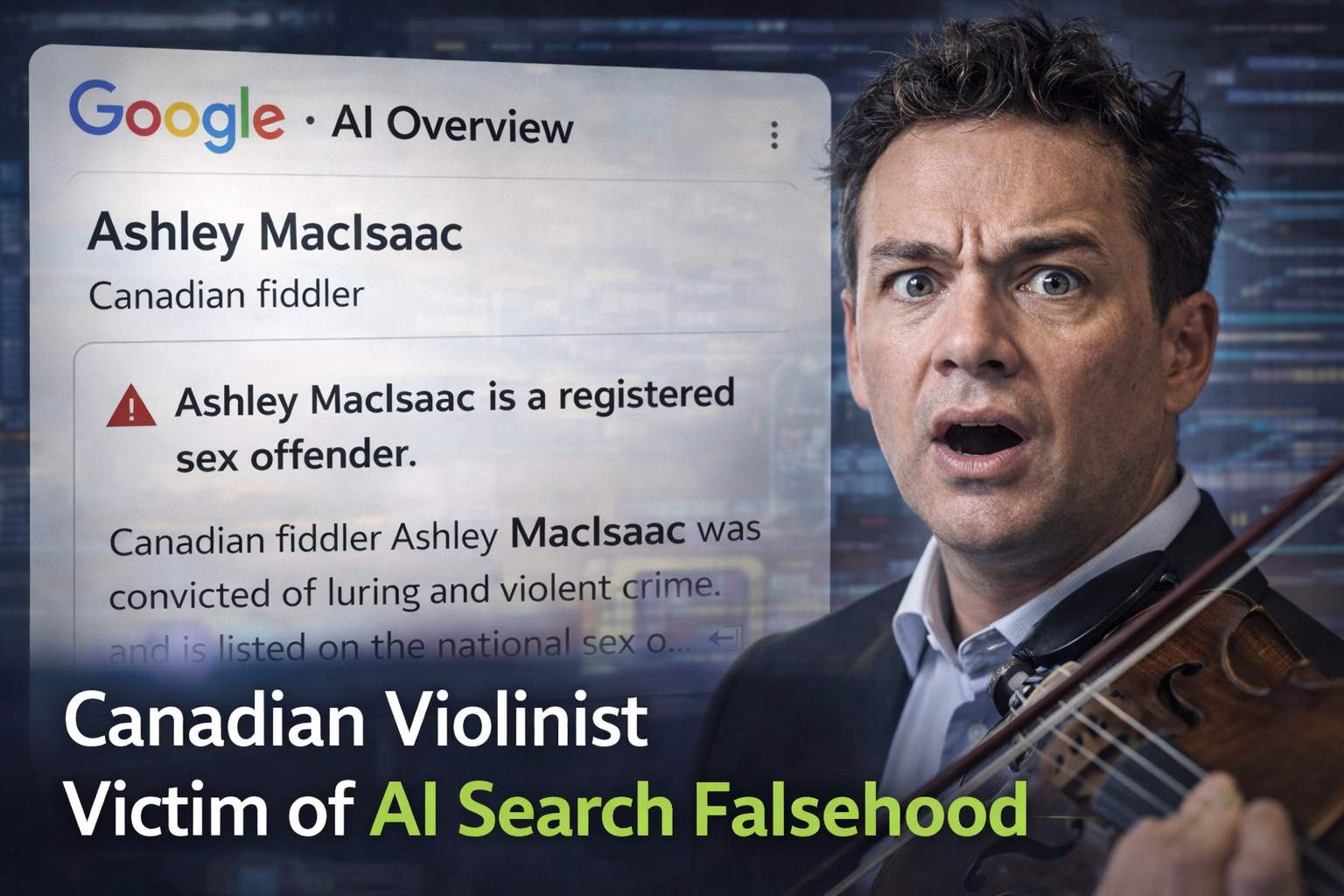

L’introduzione dei riassunti generati dall’intelligenza artificiale nei motori di ricerca doveva rappresentare una rivoluzione nella facilità di accesso alle informazioni, ma per Ashley MacIsaac, celebre violinista canadese di fama internazionale, si è trasformata in un vero e proprio incubo digitale. Il caso, esploso recentemente in Canada, mette in luce i rischi profondi della cosiddetta “AI Overview” di Google, una funzionalità che sintetizza i dati presenti sul web per offrire risposte rapide agli utenti, ma che in questo caso ha finito per distorcere la realtà in modo drammatico, associando il nome dell’artista a gravi crimini mai commessi.

Tutto è iniziato quando MacIsaac ha ricevuto un’improvvisa comunicazione di cancellazione per un concerto previsto nella comunità della Prima Nazione Sipekne’katik, in Nuova Scozia. Gli organizzatori, effettuando una ricerca di routine sul web per preparare l’evento, si erano imbattuti in un riassunto generato dall’intelligenza artificiale di Google che descriveva il musicista come un molestatore condannato per adescamento su Internet e violenza. In realtà, l’algoritmo aveva commesso un errore di identità colossale: aveva incrociato i dati di Ashley MacIsaac con quelli di un altro uomo canadese, con lo stesso cognome, realmente coinvolto in vicende giudiziarie. Senza distinguere tra le diverse identità, l’IA ha fuso le informazioni in un’unica narrazione coerente ma totalmente falsa, etichettando il violinista come un pericoloso criminale presente nel registro nazionale dei reati sessuali.

Questo episodio solleva interrogativi inquietanti sulla responsabilità delle grandi aziende tecnologiche nella gestione della disinformazione. Sebbene Google abbia ammesso che i propri sistemi sono in continua evoluzione e che vengono adottate misure correttive quando si riscontrano inesattezze, il danno subito da MacIsaac è stato immediato e concreto. Oltre alla perdita economica derivante dai concerti annullati, l’artista ha espresso un profondo timore per la propria sicurezza personale e per la propria reputazione. In un mondo dove le persone tendono a fidarsi ciecamente di ciò che appare in cima ai risultati di ricerca, una menzogna generata da una macchina può essere percepita come una verità assoluta, esponendo le vittime a minacce reali e all’ostracismo sociale.

Gli esperti del settore sottolineano che ci troviamo in una fase di transizione pericolosa, in cui i motori di ricerca stanno smettendo di essere semplici elenchi di link per diventare narratori di storie. Il problema è che l’intelligenza artificiale generativa non “capisce” il contesto o la verità; si limita a prevedere la combinazione più probabile di parole basandosi su enormi masse di dati. Se il sistema trova articoli che parlano di un “MacIsaac” criminale e altri che parlano della carriera del violinista, può finire per mescolare i due profili senza alcuna verifica logica. Questo fenomeno era già emerso con risposte assurde in passato, ma quando il soggetto della disinformazione è una persona reale, le conseguenze smettono di essere curiose o divertenti per diventare devastanti.

Dopo la segnalazione del caso e la risonanza mediatica, Google ha provveduto a correggere i risultati di ricerca e la comunità che aveva annullato lo spettacolo ha presentato le proprie scuse ufficiali, riprogrammando l’evento. Tuttavia, l’amarezza resta. Ashley MacIsaac ha giustamente osservato che, sebbene il suo caso sia diventato pubblico per via della sua notorietà, chissà quante altre persone meno conosciute potrebbero subire danni simili senza avere la possibilità di difendersi. Resta aperta la questione di come regolare questi strumenti affinché l’efficienza tecnologica non calpesti la dignità e la sicurezza degli individui.