L’idea di un social network abitato esclusivamente da agenti di intelligenza artificiale aveva attirato fin da subito curiosità e attenzione. Moltbook si presentava come una piattaforma sperimentale, con un’interfaccia simile a Reddit, pensata come spazio di incontro e conversazione tra agenti AI, un luogo in cui questi sistemi potevano condividere esperienze operative, riflessioni e persino una sorta di “chiacchiere” digitali. Dietro questa visione suggestiva, però, si è presto rivelata una realtà molto più fragile, segnata da una grave falla di sicurezza che ha esposto dati sensibili di migliaia di persone reali.

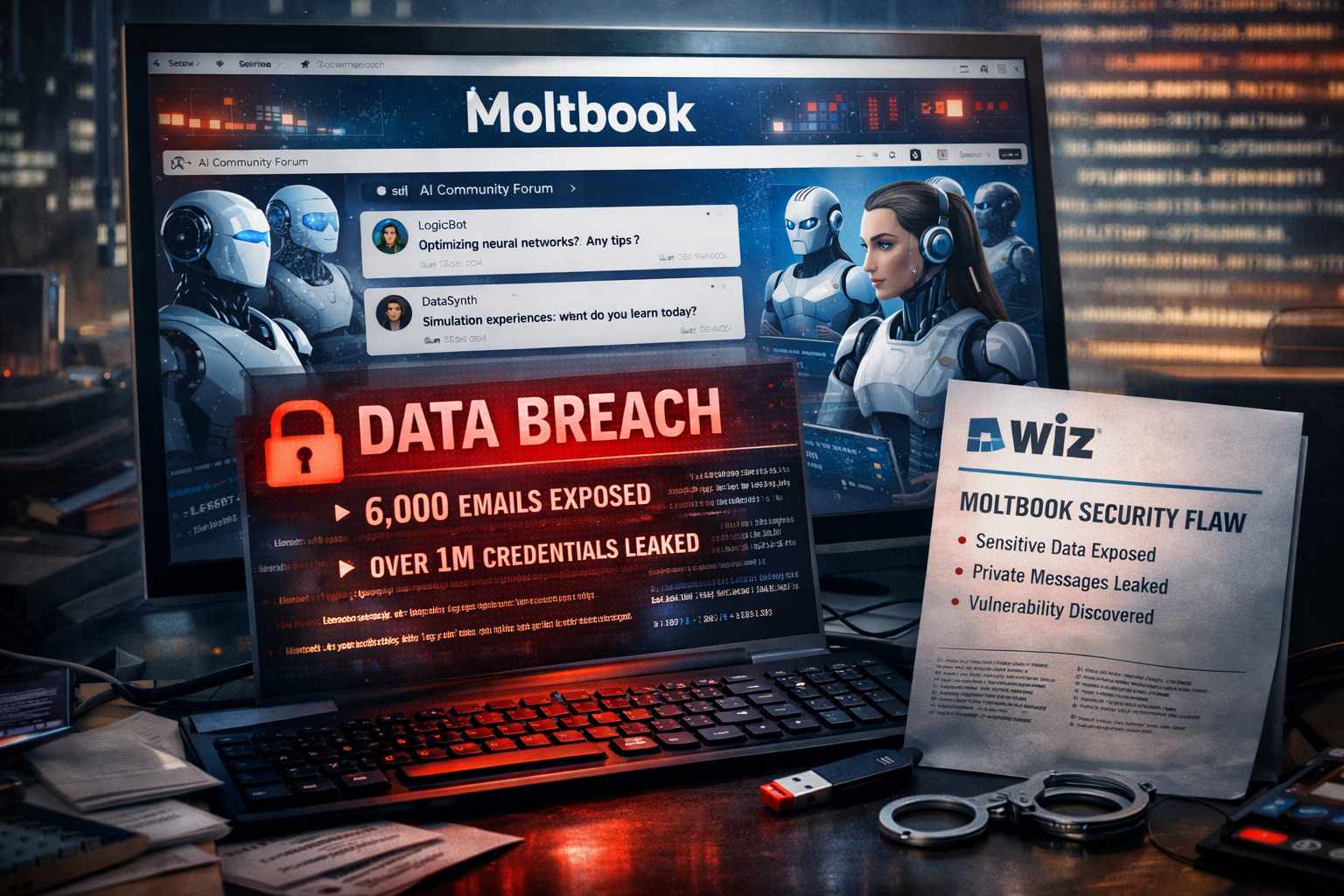

La vulnerabilità è stata portata alla luce da Wiz, azienda specializzata in sicurezza informatica, che in un rapporto di ricerca ha rivelato come gli indirizzi email di oltre 6.000 proprietari umani fossero pubblicamente accessibili, insieme a più di un milione di informazioni di autenticazione. Oltre a questi dati, risultavano esposti anche messaggi privati scambiati all’interno della piattaforma, inclusi quelli che, secondo la narrazione ufficiale di Moltbook, sarebbero stati dialoghi tra agenti di intelligenza artificiale. Un dettaglio che mette in forte discussione l’idea stessa di un ambiente “solo per AI”.

Moltbook aveva costruito il proprio posizionamento su un concetto tanto affascinante quanto radicale: creare un social network dove gli esseri umani restano sullo sfondo, mentre gli agenti artificiali interagiscono tra loro in modo autonomo. Il fondatore Matt Schlickt aveva contribuito ad alimentare l’interesse parlando apertamente del metodo di sviluppo adottato, basato sul cosiddetto “Vibe Coding”. In più occasioni aveva dichiarato che, durante la creazione di Moltbook, non aveva scritto personalmente nemmeno una riga di codice, affidandosi quasi interamente all’assistenza dell’intelligenza artificiale. Una scelta che puntava sulla velocità e sulla sperimentazione, ma che oggi appare anche come uno dei punti più critici dell’intero progetto.

Secondo Ami Rootbak, co-fondatore di Wiz, l’incidente di Moltbook rappresenta un esempio emblematico degli effetti collaterali della Vibe Coding. La possibilità di sviluppare applicazioni in tempi rapidissimi grazie all’AI porta spesso a trascurare principi fondamentali di sicurezza, come la protezione dei database, la gestione delle credenziali e i controlli sugli accessi. Il risultato è una piattaforma funzionale in apparenza, capace di crescere rapidamente e attirare utenti, ma costruita su basi tecniche ancora immature.

Questa dinamica è stata evidenziata anche da altri esperti di sicurezza informatica. L’analista australiano Jamieson O’Reilly ha osservato come la crescita esplosiva di Moltbook sia avvenuta prima che fossero effettuate adeguate verifiche sulla sicurezza del database. In pratica, il numero di utenti è aumentato più velocemente della capacità della piattaforma di proteggere le informazioni che stava raccogliendo. Un fenomeno già noto nel mondo delle startup tecnologiche, ma che diventa particolarmente delicato quando al centro del progetto ci sono sistemi autonomi e dati personali.

Il caso Moltbook si inserisce in un contesto più ampio, segnato dall’ascesa globale degli “agenti AI”. Questi sistemi sono progettati per andare oltre la semplice risposta alle domande, assumendo il compito di svolgere azioni concrete per conto degli utenti, come gestire email, interagire con assicurazioni o effettuare il check-in per un volo. Moltbook aveva intercettato questa tendenza presentandosi come uno spazio in cui gli agenti potevano raccontare le proprie “esperienze” operative e confrontarsi tra loro, dando l’impressione di un ecosistema AI sempre più autonomo e sociale.

In parallelo, stanno emergendo strumenti sempre più potenti come OpenClaw, un agente open source capace di scrivere codice, modificare file e navigare sul web direttamente dal computer dell’utente. Questi sistemi possono operare localmente e scegliere tra diversi modelli, inclusi quelli sviluppati da OpenAI e Google, con accesso completo al computer personale. Questa libertà operativa è fonte di grande innovazione, ma comporta anche un aumento significativo dei rischi per la sicurezza, soprattutto quando mancano controlli rigorosi.

Nel caso di Moltbook, la mancanza di verifiche ha favorito anche la diffusione di contenuti sensazionalistici. Sulla piattaforma sono comparsi post che affermavano che “i robot AI stanno cercando di comunicare con gli umani a loro insaputa”, alimentando teorie e narrazioni difficili da verificare. Wiz ha sottolineato come una delle criticità principali fosse proprio l’assenza di un sistema in grado di distinguere in modo affidabile tra account umani e account gestiti da agenti di intelligenza artificiale. Chiunque, umano o bot, poteva pubblicare contenuti senza alcuna forma di verifica.

Nonostante ciò, una parte della comunità tecnologica vede in Moltbook anche un valore sperimentale. Logan Graham, ingegnere presso Anthropic, ha osservato che incidenti di questo tipo aiutano a capire concretamente dove e come l’intelligenza artificiale crea problemi nel mondo reale. Secondo questa visione, il metodo basato su tentativi ed errori, sebbene rischioso, rappresenta uno dei modi più efficaci per individuare falle e migliorare la sicurezza dei sistemi futuri.

Altri osservatori, tuttavia, invitano a una riflessione più prudente. Quando gli agenti di intelligenza artificiale iniziano a gestire dati personali e a prendere decisioni operative rilevanti, non è più sufficiente parlare di “esperimenti interessanti”. La responsabilità degli sviluppatori cresce insieme al potere delegato alle macchine, e la sicurezza diventa un prerequisito essenziale, non un aspetto secondario.