C’è un’idea che, negli ultimi mesi, ha iniziato a risuonare nei laboratori di ricerca sull’IA: non è necessario alterare i pesi di un modello linguistico per farlo “migliorare” nei contesti reali, basta far sì che il contesto attraverso cui interagisce evolva, si arricchisca e si auto-corregga nel tempo. Questo è il fulcro del framework ACE (Agentic Context Engineering), ideato da un team congiunto di Stanford, UC Berkeley e SambaNova, che propone una via alternativa per l’adattamento dinamico dei modelli linguistici, trattando il contesto come un “manuale vivente” da aggiornare piuttosto che un prompt da riscrivere da capo.

L’intuizione nasce da due criticità che affliggono i metodi classici di adattamento contestuale. La prima è il bias di brevità: quando un prompt o una memoria vengono rielaborati, spesso tendono a essere compressi, semplificati e privati di dettagli importanti. La seconda è il cosiddetto collasso del contesto, che si manifesta quando successive riscritture portano a perdere progressivamente informazioni fino a sacrificare coerenza e ricchezza. In quei casi, l’adattamento “da zero” può generare regressioni anziché progressi.

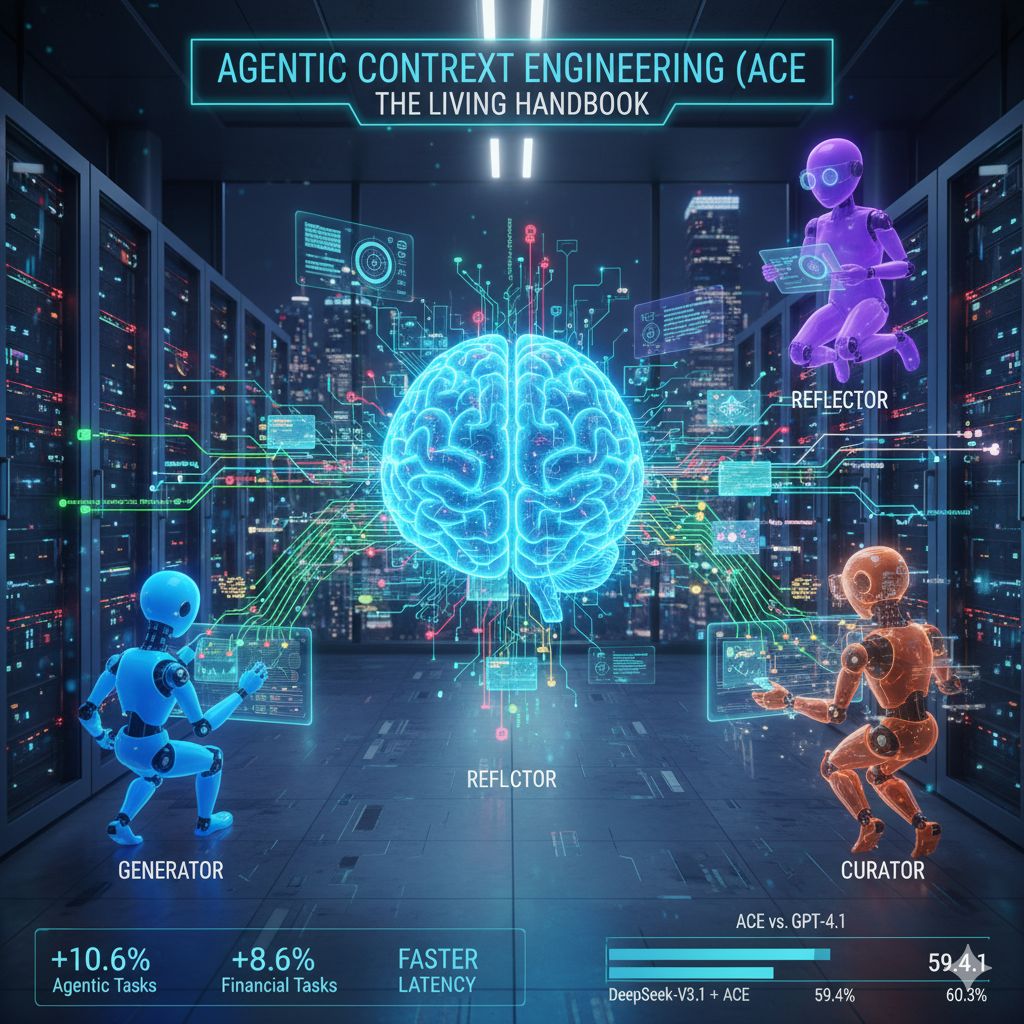

ACE propone un paradigma in cui il contesto non è più un documento monolitico da rifare tutto, ma un sistema modulare che cresce, si sperimenta, riflette e si cura. Tre funzioni si intrecciano in questa architettura: Generator, Reflector e Curator. Il Generator esegue i compiti, raccoglie traiettorie di ragionamento e mette in luce strategie utili o errori; il Reflector osserva i risultati, coglie ciò che ha funzionato e ciò che no, distilla insegnamenti; il Curator infine trasforma queste lezioni in “delta contestuali” — piccole modifiche incrementali — integrandole al contesto in modo organizzato, eliminando ridondanze e preservando ciò che è essenziale. In questo modo il contesto si evolve gradualmente, mantenendo memoria delle buone strategie e rimuovendo ciò che è superfluo o dannoso.

Uno degli aspetti più interessanti è che l’aggiornamento del contesto diventa leggero ed efficiente: non serve riscrivere tutto con l’LLM, ma basta un insieme limitato di modifiche delta che il Curator integra con meccanismi deterministici. Questo approccio aiuta a contenere la latenza e i costi di calcolo rispetto a strategie che rifanno interamente i prompt o la memoria.

I risultati ottenuti nei benchmark mostrano che ACE può fare la differenza: nei task agentici (come AppWorld) si registra un guadagno medio di circa +10,6% rispetto ai migliori metodi basati su contesto, mentre nei compiti finanziari (ragionamento su XBRL, tagging numerico) si osserva un miglioramento dell’8,6%. Non meno importante: l’adattamento del contesto risulta in media più rapido, con una riduzione significativa della latenza rispetto alle tecniche concorrenti.

Un dato che colpisce è che in alcuni casi ACE, pur utilizzando modelli “più piccoli” o open source come DeepSeek-V3.1, riesce a raggiungere prestazioni comparabili a sistemi di punta basati su GPT-4.1. Ad esempio, nella classifica ufficiale di AppWorld, l’implementazione ReAct + ACE ha ottenuto un’accuratezza del 59,4%, molto vicina al 60,3% del metodo IBM CUGA basato su GPT-4.1, pur superandolo nelle sezioni di test più difficili.

La trasformazione che ACE porta con sé non è solo tecnica, ma filosofica: più che puntare sull’aggiornamento dei pesi (che richiede nuovi training, versioning, costi hardware), si punta a rendere i modelli “auto-miglioranti” attraverso l’evoluzione del contesto che li guida. In tal senso, il contesto non è più un vincolo fisso, ma diventa l’elemento attivo di apprendimento. I ricercatori vedono in ACE una strada promettente per sistemi LLM e agenti che apprendono continuamente, senza necessità di riaddestramenti pesanti.