Il settore della generazione musicale tramite intelligenza artificiale, per lungo tempo dominato da piattaforme chiuse e servizi in abbonamento come Suno e Udio, sta vivendo un momento di profonda trasformazione. Il catalizzatore di questo cambiamento è il rilascio di ACE-Step 1.5, un modello di base open source ad alte prestazioni sviluppato dai ricercatori di Ace Studio e China Stepfun. Questa nuova soluzione non si limita a offrire un’alternativa gratuita, ma introduce un cambio di paradigma tecnico e filosofico, portando la qualità della produzione musicale professionale direttamente sull’hardware domestico degli utenti.

Il cuore tecnologico di ACE-Step 1.5 risiede in un’architettura ibrida estremamente sofisticata che separa il processo creativo in due fasi distinte. Nella prima fase, un Large Language Model (LLM) agisce come un “pianificatore” logico: utilizzando un approccio simile alla catena di pensiero (Chain-of-Thought), il modello progetta la struttura del brano, definendo l’atmosfera, gli strumenti e lo sviluppo armonico prima ancora di emettere un singolo suono. Nella seconda fase, un Diffusion Transformer (DiT) prende questo progetto e lo trasforma in audio reale. Questo metodo “riflessivo” evita la generazione casuale di suoni, garantendo che ogni brano abbia una coerenza strutturale superiore, paragonabile alle produzioni commerciali più blasonate.

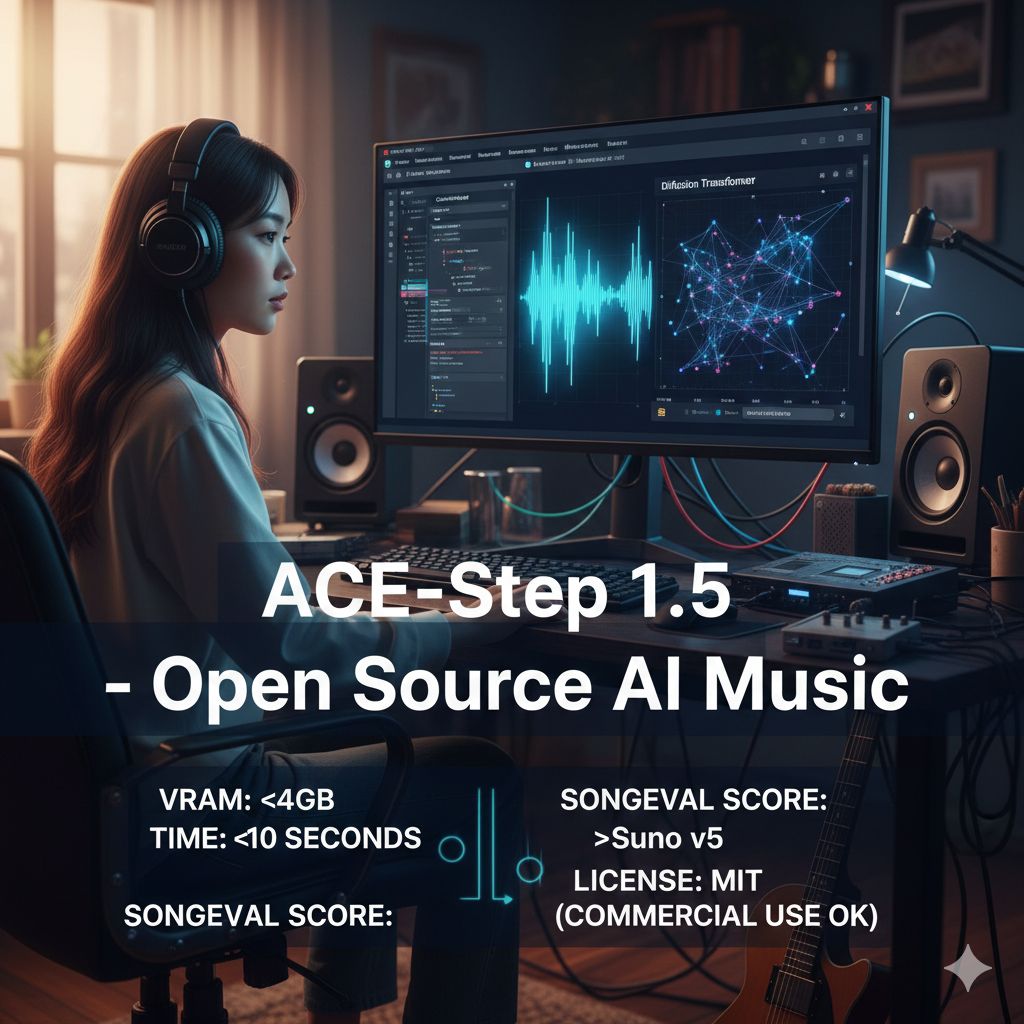

Uno dei punti di forza più sorprendenti di questo modello è la sua incredibile efficienza energetica e prestazionale. ACE-Step 1.5 è stato progettato per funzionare su hardware di consumo: è possibile eseguire l’intero processo di generazione locale con meno di 4 GB di VRAM, rendendolo accessibile anche a chi possiede una comune scheda video da gaming. In termini di velocità, i risultati sono impressionanti: una canzone completa può essere generata in meno di dieci secondi su una scheda RTX 3090, mentre su server ad alte prestazioni il tempo scende sotto i due secondi. Questa democratizzazione tecnologica significa che non è più necessario affidarsi a costosi server cloud per creare musica di alta qualità.

L’approccio open source di ACE-Step 1.5 apre inoltre la strada a una personalizzazione senza precedenti grazie all’uso di LoRA (Low-Rank Adaptation). Questa tecnica permette agli utenti di addestrare versioni “leggere” del modello partendo da pochissimi brani di riferimento. In questo modo, un artista può creare un’IA specializzata in un genere di nicchia, come il city pop giapponese degli anni ’80 o sottogeneri specifici dell’hip-hop, catturando toni strumentali e stili di arrangiamento unici. È la realizzazione della “vera personalizzazione”, dove lo strumento si adatta alla visione dell’utente e non viceversa.

Oltre alla creazione da zero, il modello integra funzionalità avanzate essenziali per il lavoro pratico in studio. ACE-Step 1.5 supporta la creazione di cover, la rielaborazione di brani esistenti e la conversione “vocal-to-BGM”, che permette di trasformare una traccia vocale in un accompagnamento musicale coerente. Con il supporto a oltre 50 lingue e un punteggio nell’indice SongEval superiore a quello di modelli commerciali come Suno v5, ACE-Step 1.5 si posiziona non più come una semplice curiosità sperimentale, ma come uno strumento di produzione maturo e versatile.

Infine, un aspetto cruciale riguarda la trasparenza e la legalità. Rilasciato sotto licenza MIT, il modello permette il libero utilizzo commerciale della musica generata, offrendo una sicurezza giuridica fondamentale per i creator. Gli sviluppatori hanno inoltre dichiarato che l’addestramento è avvenuto su fonti sonore autorizzate e musica royalty-free, affrontando direttamente le preoccupazioni etiche legate al copyright che spesso affliggono il mondo dell’IA generativa. Con la disponibilità dei pesi del modello su HuggingFace e del codice su GitHub, ACE-Step 1.5 rappresenta ufficialmente il “momento Stable Diffusion” per la musica, spostando il potere creativo dai grandi colossi tecnologici alle mani dei singoli artisti.