Nell’intelligenza artificiale, la capacità di comprendere e interpretare simultaneamente testo e immagini è diventata fondamentale. Modelli come OpenAI CLIP e Google SigLIP hanno svolto un ruolo cruciale in questo ambito, ma entrambi presentano limitazioni in termini di accessibilità, trasparenza e flessibilità. In risposta a queste sfide, l’Università della California, Santa Cruz, ha sviluppato OpenVision: una famiglia di encoder visivi completamente open source, progettata per superare le barriere esistenti e offrire soluzioni più efficienti e scalabili.

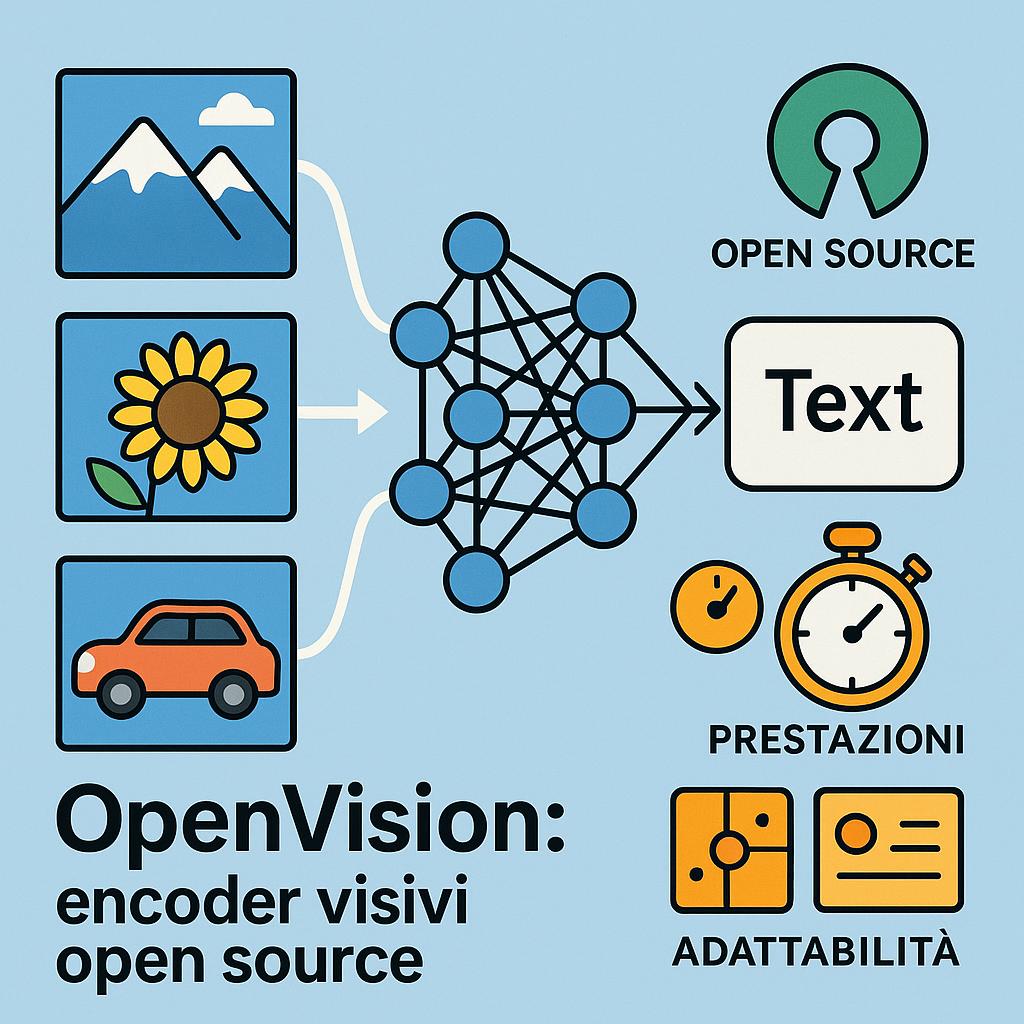

OpenVision è una suite di modelli di encoder visivi che trasforma immagini in rappresentazioni numeriche comprensibili da modelli linguistici di grandi dimensioni (LLM). A differenza di CLIP e SigLIP, OpenVision è completamente open source, con dati di addestramento, ricette e checkpoint disponibili pubblicamente sotto licenza Apache 2.0. Questo approccio promuove la trasparenza e consente a ricercatori e sviluppatori di adattare facilmente i modelli alle proprie esigenze.

I vantaggi chiave di OpenVision sono:

- Prestazioni Superiore nei Compiti Multimodali

OpenVision ha dimostrato prestazioni superiori rispetto a CLIP e SigLIP in vari benchmark multimodali, tra cui TextVQA, ChartQA e OCR. Utilizzando framework come LLaVA-1.5 e Open-LLaVA-Next, i modelli OpenVision hanno ottenuto risultati migliori in compiti complessi che richiedono una comprensione profonda delle immagini e del testo. - Efficienza Computazionale Avanzata

Grazie a una strategia di addestramento a risoluzione progressiva, OpenVision è in grado di ridurre significativamente i tempi di addestramento, risultando da due a tre volte più veloce rispetto ai modelli concorrenti, senza compromettere le prestazioni. Questo approccio è particolarmente vantaggioso in scenari con risorse limitate. - Adattabilità a Diverse Esigenze

Con oltre 25 varianti di modelli, OpenVision offre una gamma che va da 5,9 milioni a 632,1 milioni di parametri. Ciò consente di scegliere il modello più adatto in base alle specifiche esigenze di precisione e risorse computazionali disponibili. I modelli più piccoli sono ideali per dispositivi edge, mentre quelli più grandi sono adatti per applicazioni server-intensive.

OpenVision può essere combinato con modelli linguistici di piccole dimensioni, come Smol-LM da 150 milioni di parametri, per creare sistemi multimodali compatti e performanti. Questa integrazione è particolarmente utile per applicazioni su dispositivi mobili o in scenari con risorse limitate.

L’introduzione di OpenVision rappresenta un passo significativo verso una maggiore democratizzazione dell’intelligenza artificiale. La disponibilità di modelli open source consente alle aziende e ai ricercatori di sviluppare soluzioni personalizzate senza dipendere da modelli proprietari con limitazioni d’uso. Inoltre, la trasparenza nel processo di addestramento favorisce una maggiore fiducia e facilita la riproducibilità dei risultati.