Un’intelligenza artificiale che non si perde nei suoi stessi passi, che non rincorre catene lunghissime di ragionamento (“chain of thought”) fino a inciampare in un errore banale, ma che sa usare strumenti, controllare ogni tappa, correggersi, affinare le risposte: questo è il tipo di salto che Microsoft propone con rStar2-Agent, un framework progettato per addestrare modelli di ragionamento potenti ma con costi computazionali molto più contenuti.

Molte AI oggi migliorano nel ragionamento aumentando la lunghezza delle tracce di pensiero (“pensare più a lungo”) — ossia generando molte tappe intermedie, elaborazioni interne, riflessioni su se stesse. Ma questo ha limiti reali: ogni errore in una fase può compromettere tutto il ragionamento, e soprattutto sono richiesti enormi investimenti in dati, infrastrutture, tempo. Non solo: l’AI può deviare, perdersi in parti inutili o contraddittorie, o generare risposte verbose, poco chiare.

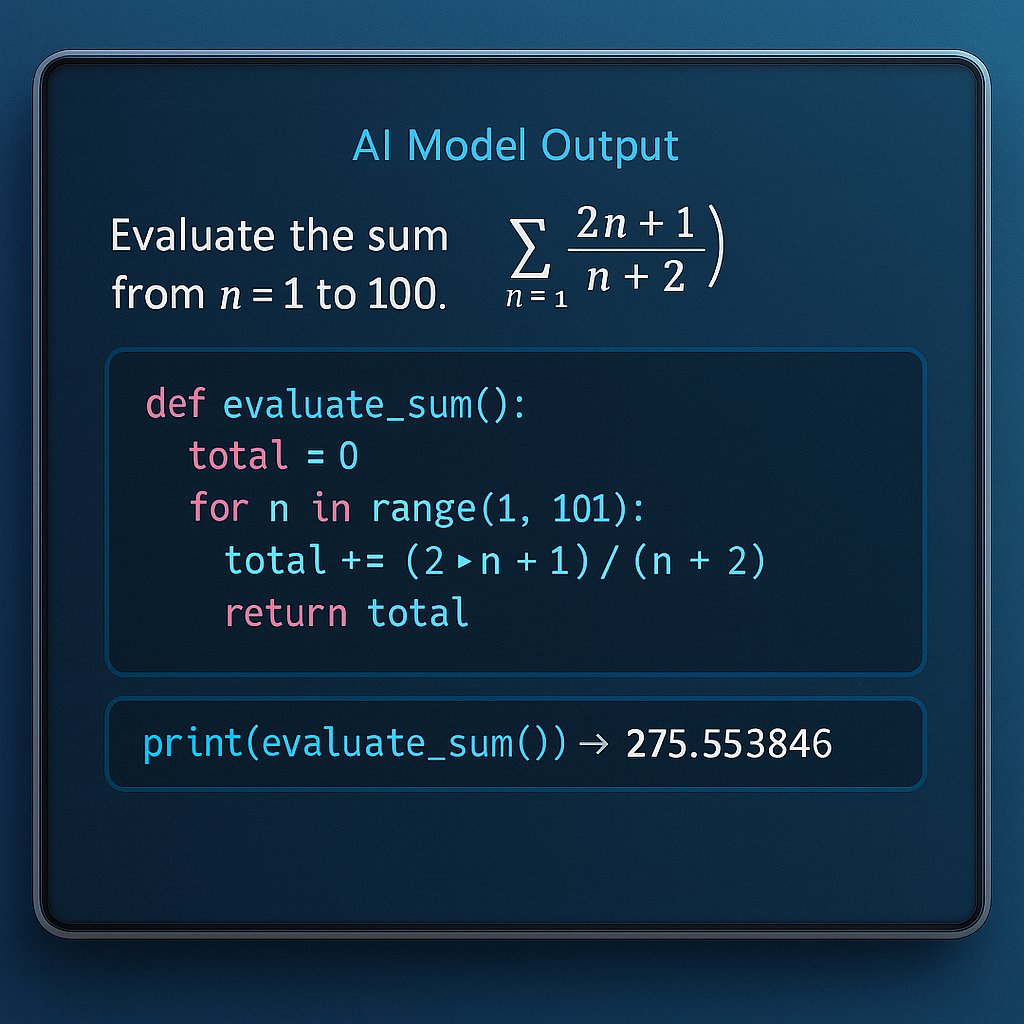

Microsoft propone una via diversa: non «più passaggi» ma passaggi più utili, più controllati, grazie all’integrazione con strumenti (in questo caso l’interprete Python), capacità di verifica intermedia e feedback, e algoritmi che premiano non solo la correttezza finale, ma la qualità del percorso intermedio.

rStar2-Agent è un framework di reinforcement learning “agentico”: il modello non genera solo una risposta, ma si comporta come un agente che interagisce con un ambiente, utilizza strumenti (qui, Python), esegue codice, verifica risultati, e adatta il suo ragionamento man mano. È un loop: ragiona → chiama codice → ottiene output → aggiusta → continua finché non arriva alla risposta finale. Questo permette di correggere errori intermedi che altrimenti resterebbero nascosti, e di costruire ragionamenti “più intelligenti”.

Ci sono tre innovazioni chiave:

- Infrastruttura efficiente e robusta: costruire un ambiente in cui l’agente può fare decine di migliaia di chiamate a strumenti in parallelo, gestendo errori, latenza, utilizzo bilanciato tra CPU e GPU. Nel caso di rStar2-Agent, si arriva a gestire fino a 45.000 tool call concorrenti per step, con latenza media di 0,3 secondi. Ma questo tipo di sistema richiede anche scheduler che bilancino il carico, isolamento per evitare che errori “vaghi” danneggino la stabilità, e gestione intelligente delle risorse hardware.

- Gruppo Relative Policy Optimization con Resampling on Correct (GRPO-RoC): un’evoluzione del metodo GRPO, adattata allo scenario tool-centric. In breve, si generano gruppi di traiettorie di ragionamento (diversi possibili percorsi che il modello può prendere), si valuta quali sono quelli “positivi” (cioè conducono a una risposta corretta, con errori minimi negli strumenti e nel formato), si selezionano quelli di qualità per l’addestramento (oversampling delle traiettorie corrette), ma si mantiene anche una selezione delle traiettorie fallite, per imparare dagli errori. Lo scopo è evitare che il modello impari solo da strade perfette (il che rischia l’overfitting) ma che impari anche a non sbagliare dove è facile sbagliare.

- Ricetta formativa progressiva: non si parte subito con problemi complessissimi, lunghe risposte, ragionamenti intricati. Si inizia con addestramento supervisionato (SFT) su compiti più semplici — insegnando al modello, per esempio, a seguire istruzioni, formattare output, usare strumenti. Poi si passa al reinforcement learning con difficoltà crescente: problemi più difficili, risposte più lunghe, tanto che la lunghezza massima delle risposte scala via via. Questo permette di mantenere controllo sulla complessità e sull’efficacia.

L’esperimento che Microsoft riporta è particolarmente interessante: un modello da 14 miliardi di parametri, denominato Qwen3-14B-base, è stato fine-tuned con rStar2-Agent usando hardware di tutto rispetto (64 GPU AMD MI300X).

In appena una settimana e con 510 step di reinforcement learning, questo modello ha raggiunto livelli di accuratezza nei benchmark matematici paragonabili, e talvolta superiori, a modelli molto più grandi, come DeepSeek-R1 (671 miliardi di parametri) o Claude Opus 4.0, generando risposte più concise, meno verbose.

In particolare, su benchmark come AIME24 ha fatto 80,6% di accuratezza, superando modelli molto più ingombranti. E non solo in matematica: ha mostrato buone capacità anche in scienze e ragionamenti generali, il che suggerisce che le abilità sviluppate in un dominio possono trasferirsi ad altri.

Per le imprese, per la ricerca, per chi costruisce applicazioni AI avanzate, l’innovazione di rStar2-Agent offre diverse promesse concrete:

- Riduzione dei costi: meno passi, meno risorse, meno tempo di addestramento. Un modello più piccolo che ottiene risultati comparabili a modelli molto più costosi è un affare.

- Maggiore affidabilità: gli output sono più stabili, con meno errori intermedi, codici eseguibili corretti al primo tentativo, meno “rumore” generato dagli strumenti.

- Risposte più snelle, quindi più rapide ed efficienti: generare risposte concise non è solo una questione estetica; significa meno token da elaborare, meno latenza, meno costi di inferenza.

- Generalizzazione: non serve che il modello sia addestrato su ogni possibile compito; imparare modalità di ragionamento solide, l’uso degli strumenti, feedback, può permettere di affrontare nuovi domini con meno risorse extra.

Naturalmente, non tutto è già risolto. Alcune difficoltà emergono chiaramente:

- Passare da un ambiente molto controllato (l’interprete Python) a strumenti reali aziendali, che sono spesso rumorosi, non ben documentati, con errori imprevedibili.

- Gestire l’“environment noise”: errori, messaggi di eccezione, comportamenti inaspettati degli strumenti che possono disturbare il ragionamento.

- Mantenere sicurezza, isolamento, controllo quando si permettono tool call massicce e interazioni molto dinamiche.

- Scalare non solo in dimensione del modello, ma in varietà di strumenti, domini applicativi, complessità del ragionamento reale.

Microsoft suggerisce che questo approccio agentico-tool-centrico può essere esteso ben oltre la matematica: immagina assistenti per la scoperta farmaceutica che possano integrare banche dati chimiche o biologiche, modelli legali che verificano sentenze, sistemi finanziari che simulano scenari complessi. L’idea è che, con la ricetta giusta, non servano solo modelli giganteschi per avere potenza, ma modelli “smart” che sanno ragionare bene.