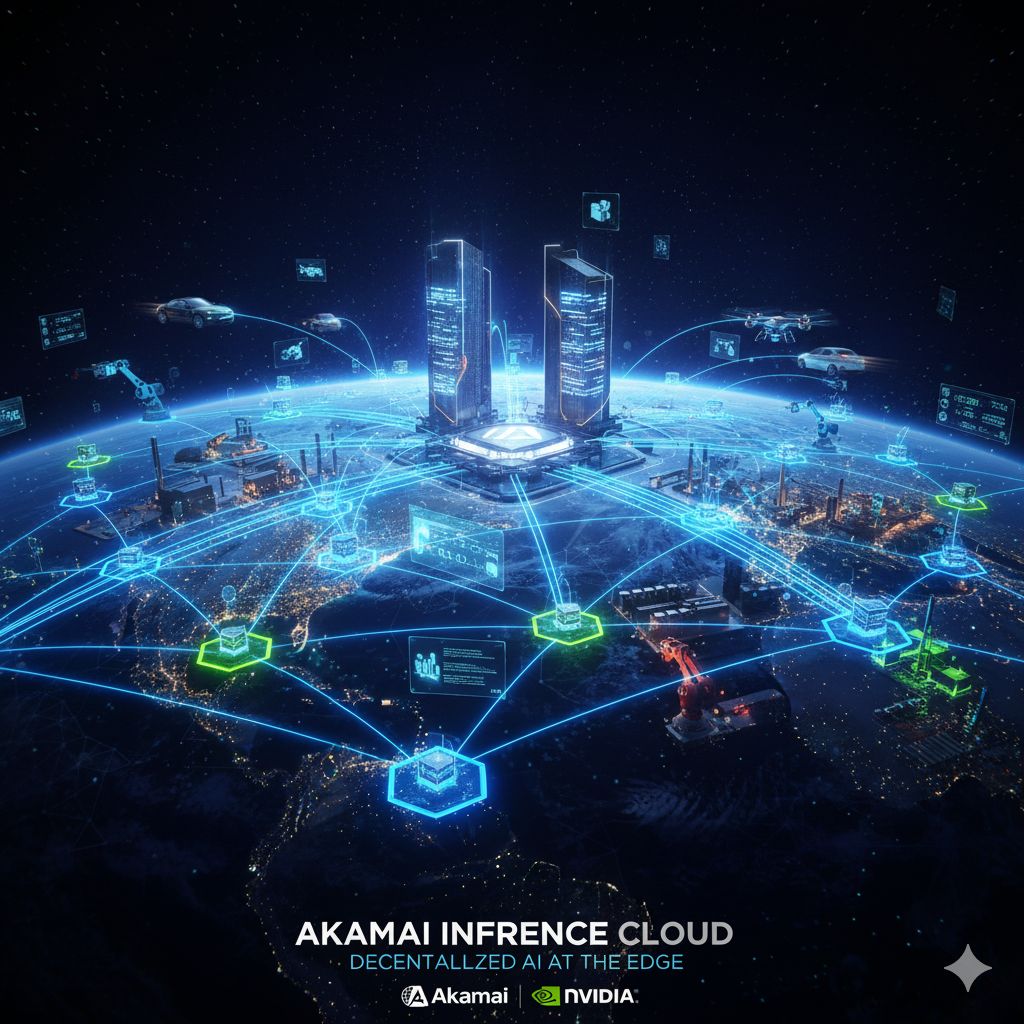

L’Intelligenza Artificiale, con la sua inarrestabile ondata di innovazione, sta per compiere un balzo evolutivo che ne ridefinirà l’architettura e l’efficacia a livello globale. Akamai Technologies, un’azienda da tempo pilastro della distribuzione di contenuti e della sicurezza su internet, ha lanciato una nuova piattaforma destinata a riscrivere le regole dell’elaborazione AI: l’Akamai Inference Cloud. Questo annuncio, maturato in una stretta collaborazione con NVIDIA, non è una semplice evoluzione dei servizi cloud, ma una vera e propria decentralizzazione strategica dell’AI, spostando il fulcro dell’inferenza – la fase in cui i modelli AI prendono decisioni o generano output – dai tradizionali data center centralizzati, noti come Core, al cosiddetto Edge, ovvero la periferia della rete, il punto più vicino agli utenti e ai dispositivi.

La logica dietro questa trasformazione è dettata da un’esigenza fondamentale: la velocità. La nuova generazione di applicazioni basate sull’AI, come gli agenti intelligenti autonomi, i sistemi decisionali in tempo reale e la cosiddetta Physical AI (ovvero l’AI che interagisce con il mondo fisico, pensiamo ai veicoli autonomi o alla robotica industriale), non possono tollerare i ritardi tipici del trasferimento dei dati verso un Core distante. Questi workload agentici e autonomi richiedono una latenza estremamente bassa e una conoscenza del contesto locale per poter reagire con prontezza, spesso a velocità superiori a quelle di un essere umano.

Akamai Inference Cloud è la risposta diretta a questa sfida. Sfruttando la sua vasta esperienza nelle architetture distribuite a livello planetario, la piattaforma è stata specificamente progettata per fornire un’AI inference intelligente e proattiva sull’Edge, garantendo risposte pressoché istantanee su scala globale. Questo significa che l’elaborazione dei dati dei sensori, la valutazione di una transazione finanziaria per la prevenzione delle frodi, o la coordinazione dei movimenti di un drone di consegna, avverranno nel momento esatto e nel luogo esatto in cui i dati vengono creati.

L’ambizione di Akamai di creare una rete globale AI-capace è resa possibile dalla partnership strategica con NVIDIA, un’azienda leader nell’infrastruttura per l’Intelligenza Artificiale. Akamai Inference Cloud integra lo stack AI di NVIDIA – incluse le tecnologie di ultima generazione come le architetture Blackwell per i server RTX PRO™ e la nuova DPU NVIDIA BlueField-4 – posizionando di fatto questa potenza di calcolo accelerato più vicino al punto di bisogno.

Questa sinergia non è solo un potenziamento hardware, ma una profonda integrazione software. Il livello di coordinamento intelligente della Akamai Inference Cloud è cruciale: è capace di instradare automaticamente i compiti AI verso le posizioni ottimali. Le operazioni di inference più semplici e routinarie vengono eseguite istantaneamente sull’Edge utilizzando i microservizi NIM (NVIDIA Inference Microservices), garantendo la minima latenza. Al contrario, i compiti di ragionamento più sofisticato, che richiedono un’enorme capacità di calcolo, possono essere indirizzati verso AI Factories centralizzate, il tutto gestito attraverso un’unica piattaforma unificata. Questo mix and match dinamico assicura che ogni attività AI riceva la giusta quantità di potenza di calcolo nel punto più efficiente della rete.

L’estensione dell’inferenza AI all’Edge apre le porte a una miriade di applicazioni che finora erano limitate dalla latenza.

- Agenti Digitali: Permette a chatbot e assistenti virtuali di operare con una reattività quasi umana, supportando workflow complessi in più fasi, essenziale per i sistemi finanziari in tempo reale e per l’accelerazione dei pagamenti sicuri.

- AI Fisica: Trasforma l’ambiente fisico. Immaginiamo stabilimenti di produzione, reti di trasporto autonomo o persino robot chirurgici in grado di prendere decisioni di sicurezza e coordinare azioni alla velocità del mondo reale. Questa AI fisica non è più in ritardo, ma è perfettamente allineata al ritmo degli eventi.

- Scalabilità e Sicurezza: Sfruttando l’infrastruttura di Akamai, l’AI diventa non solo veloce, ma anche massivamente scalabile e intrinsecamente sicura, utilizzando la tecnologia di NVIDIA per accelerare e proteggere l’accesso ai dati e ai workload dal Core all’Edge.

Con questa iniziativa, Akamai e NVIDIA stanno trasformando l’AI in un’infrastruttura distribuita e capillare che promette di sbloccare il vero potenziale delle applicazioni intelligenti di prossima generazione, portando l’intelligenza dove i dati vengono generati e dove le decisioni devono essere prese.