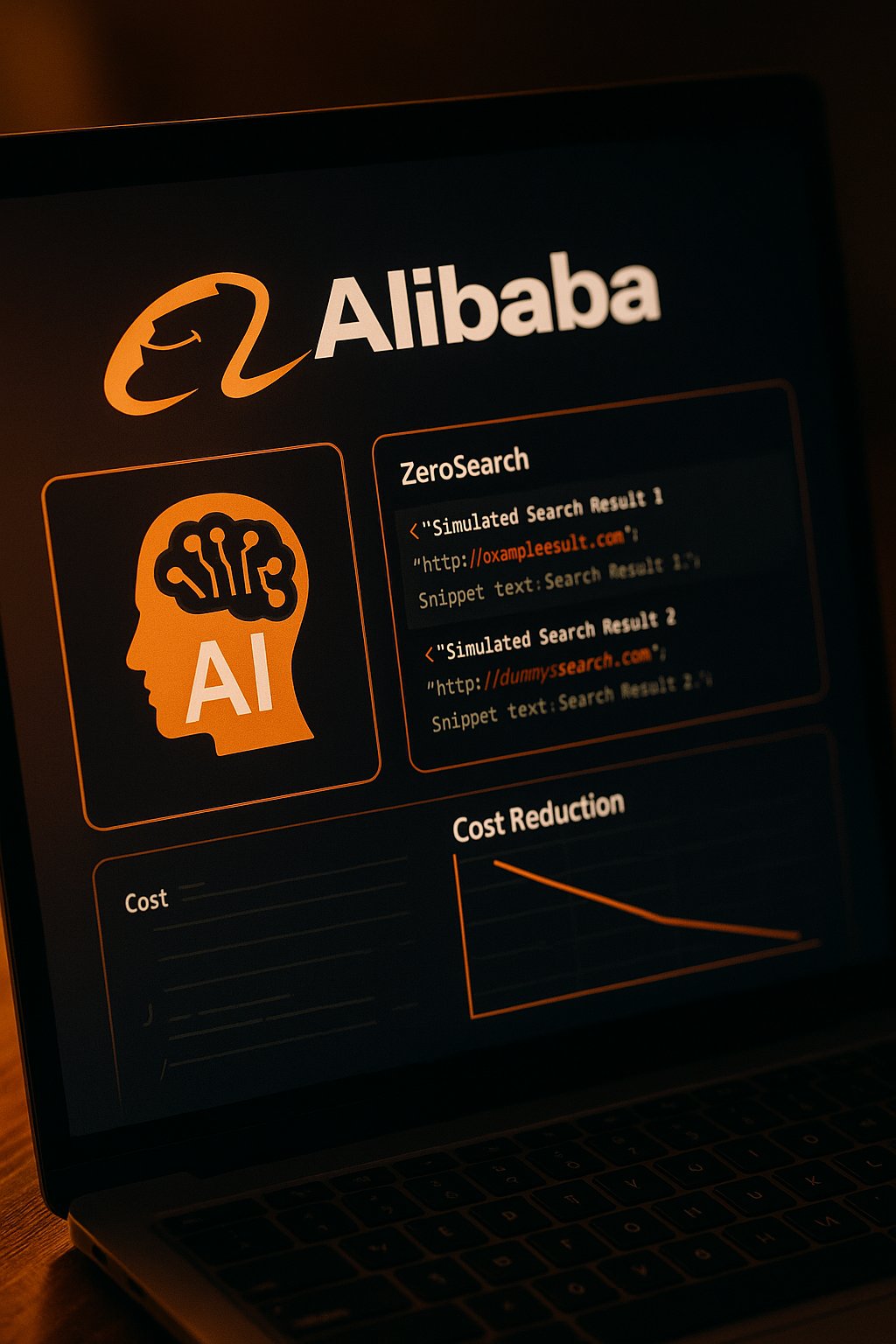

Alibaba ha recentemente introdotto un’innovativa metodologia chiamata ZeroSearch, destinata a trasformare il modo in cui gli assistenti AI apprendono a effettuare ricerche online. Questa tecnica permette ai modelli linguistici di grandi dimensioni (LLM) di sviluppare capacità di ricerca avanzate senza interagire con motori di ricerca reali durante il processo di addestramento. Il risultato? Una riduzione dei costi di addestramento fino all’88%, rendendo questa tecnologia accessibile anche a piccole imprese e startup.

Tradizionalmente, per addestrare un assistente AI a effettuare ricerche efficaci, è necessario utilizzare API di motori di ricerca commerciali come Google. Tuttavia, questo approccio presenta due principali svantaggi:

- Qualità Inaffidabile dei Documenti: I documenti restituiti dai motori di ricerca possono variare notevolmente in qualità, influenzando negativamente l’efficacia dell’addestramento.

- Costi Elevati: Ogni richiesta API comporta un costo, e addestrare un modello richiede milioni di chiamate, accumulando spese significative.

- Questi ostacoli limitano la scalabilità e l’accessibilità dell’addestramento AI, soprattutto per le realtà con budget ridotti.

ZeroSearch affronta questi problemi adottando un metodo di simulazione invece di dipendere da motori di ricerca reali. Il processo inizia con un fine-tuning supervisionato, trasformando un LLM in un modulo di recupero in grado di generare documenti pertinenti e non pertinenti in risposta a una query. Durante l’addestramento con apprendimento per rinforzo, il sistema impiega una “strategia di rollout basata su curriculum”, che degrada gradualmente la qualità dei documenti generati. Questo approccio sfrutta la vasta conoscenza acquisita dal LLM durante il pre-addestramento, consentendogli di simulare efficacemente un motore di ricerca.

Gli esperimenti condotti su sette dataset di domande e risposte hanno mostrato che ZeroSearch non solo ha eguagliato, ma spesso ha superato le prestazioni dei modelli addestrati con motori di ricerca reali. In particolare, un modulo di recupero con 7 miliardi di parametri ha raggiunto prestazioni comparabili a Google Search, mentre un modulo con 14 miliardi di parametri lo ha addirittura superato.

Dal punto di vista economico, la differenza è notevole. Addestrare un modello utilizzando circa 64.000 query di ricerca tramite SerpAPI costerebbe circa $586,70. Utilizzando un LLM simulato da 14 miliardi di parametri su quattro GPU A100, il costo scende a soli $70,80, con una riduzione dell’88%.

Questa innovazione ha il potenziale di democratizzare l’accesso all’addestramento AI avanzato. Le piccole e medie imprese, così come le startup, ora possono sviluppare assistenti AI sofisticati senza affrontare le barriere finanziarie e tecniche precedentemente associate all’uso di motori di ricerca commerciali. Inoltre, ZeroSearch offre agli sviluppatori un maggiore controllo sul processo di addestramento, permettendo loro di definire con precisione le informazioni che l’AI apprende.

Alibaba ha reso disponibili su GitHub e Hugging Face il codice, i dataset e i modelli pre-addestrati, consentendo ad altri ricercatori e aziende di implementare questo approccio. Con l’evoluzione dei modelli linguistici, tecniche come ZeroSearch suggeriscono un futuro in cui i sistemi AI possono sviluppare capacità sempre più sofisticate attraverso l’auto-simulazione, riducendo la dipendenza da servizi esterni e cambiando le dinamiche economiche dello sviluppo AI.