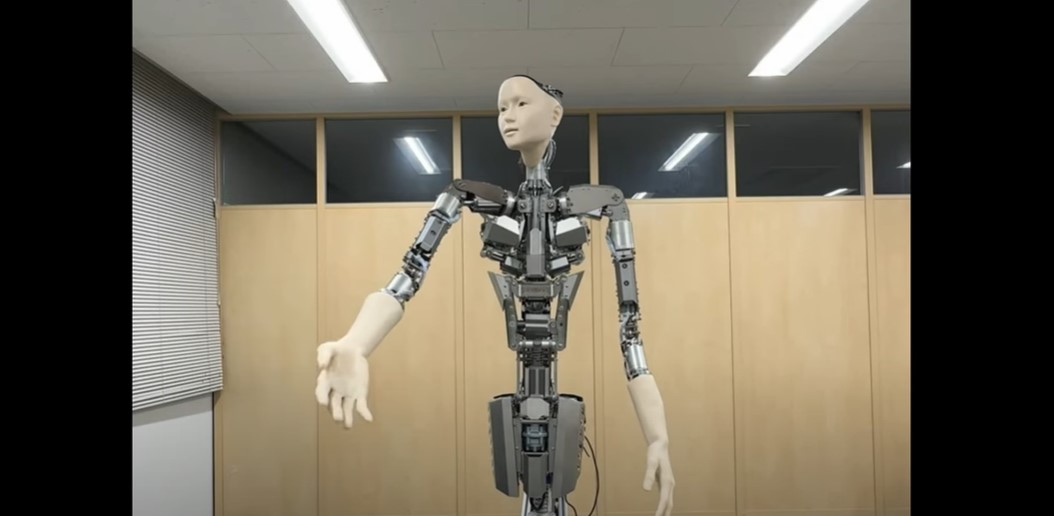

I ricercatori dell’Università di Tokyo e di Alternative Machine hanno sviluppato un nuovo sistema robotico umanoide chiamato Alter3, capace di tradurre direttamente comandi del linguaggio naturale in azioni fisiche del robot. Questo sistema sfrutta GPT-4, un ampio modello linguistico, per compiere compiti complessi come scattare selfie o simulare comportamenti come quello di un fantasma.

Questo progetto rappresenta l’ultima frontiera di una crescente ricerca che combina modelli linguistici avanzati con sistemi robotici. Anche se non ancora pronto per un utilizzo commerciale su larga scala, questi sviluppi recenti stanno rivoluzionando la robotica e promettono risultati molto promettenti.

Alter3 utilizza GPT-4 come motore principale. Il modello riceve istruzioni in linguaggio naturale che descrivono azioni o situazioni alle quali il robot deve reagire.

Il modello linguistico utilizza un “quadro agentico” per pianificare una serie di azioni che il robot deve eseguire per raggiungere il suo obiettivo. Inizialmente, il modello funge da pianificatore, determinando i passaggi necessari per eseguire l’azione desiderata.

Questo piano d’azione viene quindi inviato a un agente di codifica che genera i comandi specifici per il robot, necessari per ogni fase dell’azione. Poiché GPT-4 non è stato addestrato specificamente sui comandi di Alter3, i ricercatori adattano il modello utilizzando il suo apprendimento contestuale per interagire con l’API del robot. Questo implica che il prompt include un elenco di comandi e degli esempi per illustrare come utilizzarli. Il modello associa quindi ciascun passaggio con uno o più comandi API che vengono eseguiti dal robot.

Prima dell’avvento dei modelli linguistici, i ricercatori dovevano controllare manualmente i 43 assi del robot in sequenza per imitare gesti umani o comportamenti complessi come versare il tè o giocare a scacchi. GPT-4 ha liberato i ricercatori da questo processo iterativo.

Tuttavia, il linguaggio naturale non è sempre preciso nel descrivere movimenti fisici dettagliati, il che significa che la sequenza di azioni generata dal modello potrebbe non sempre produrre il comportamento esatto desiderato nel robot.

Per affrontare questo problema, i ricercatori hanno implementato un sistema che consente agli esseri umani di fornire feedback immediato, come “Solleva un po’ di più il braccio”. Questi feedback vengono elaborati da un altro agente GPT-4 che apporta le correzioni necessarie al codice, restituendo quindi una sequenza di azioni migliorata al robot. Le nuove istruzioni e il codice dell’azione perfezionato vengono archiviati per utilizzi futuri.

Alter3 è stato testato con successo in vari compiti, inclusi quelli quotidiani come fare selfie o bere il tè, così come in movimenti mimici come simulare un fantasma o un serpente. I ricercatori hanno anche esplorato la capacità del modello di gestire scenari che richiedono pianificazioni complesse delle azioni.

GPT-4, grazie alla sua vasta conoscenza dei comportamenti umani e delle azioni, consente di creare piani comportamentali più realistici per i robot umanoidi come Alter3. Gli esperimenti condotti dai ricercatori dimostrano che il modello è in grado di imitare anche emozioni come imbarazzo e gioia nel comportamento del robot.

L’uso dei modelli linguistici avanzati sta diventando sempre più diffuso nella ricerca robotica. Per esempio, Figure, un progetto valutato 2,6 miliardi di dollari, utilizza modelli di OpenAI per comprendere istruzioni umane e compiere azioni nel mondo reale. Con l’evolversi verso la multimodalità nei modelli di base, i sistemi robotici saranno sempre più capaci di interpretare il loro ambiente e scegliere azioni appropriate.

Alter3 rappresenta un esempio di come i modelli linguistici di base possano essere utilizzati come moduli per il ragionamento e la pianificazione nei sistemi di controllo robotico. Anche se non ottimizzato specificamente per GPT-4, il codice di Alter3 potrebbe essere adattato per altri robot umanoidi.

Altri progetti come RT-2-X e OpenVLA utilizzano modelli linguistici specializzati progettati per generare comandi robotici diretti, risultando in sistemi più stabili e adattabili a una vasta gamma di compiti e ambienti. Tuttavia, la loro creazione richiede competenze tecniche e risorse più elevate.

Chris Paxton, un esperto di intelligenza artificiale e robotica, ha sottolineato che una delle sfide principali rimane la capacità dei robot di eseguire compiti di base come afferrare oggetti e mantenere l’equilibrio, aree dove i modelli attuali possono ancora migliorare.