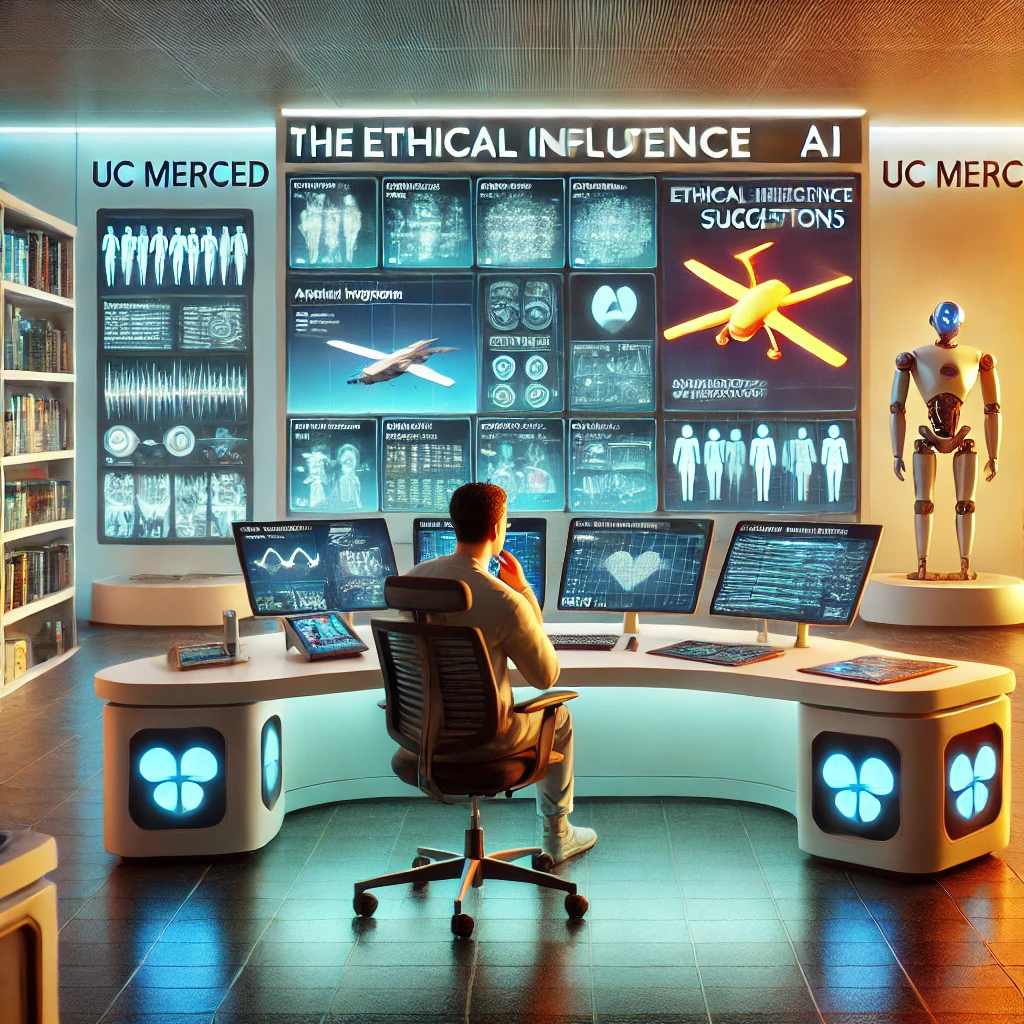

Uno studio recente dell’Università della California, Merced, ha rivelato una preoccupante tendenza: gli esseri umani tendono a riporre troppa fiducia nei sistemi di intelligenza artificiale, anche in situazioni di vita o di morte.

Con l’IA che permea sempre più aspetti della nostra vita, dagli assistenti virtuali ai sistemi di supporto alle decisioni, ci affidiamo sempre di più a queste tecnologie. Sebbene l’IA porti molti benefici, lo studio dell’UC Merced solleva preoccupazioni su quanto siamo disposti a delegare le nostre decisioni a questi sistemi, specialmente in contesti critici.

Per esplorare la fiducia umana nell’IA, i ricercatori hanno condotto esperimenti simulando situazioni ad alta pressione. In uno di questi, i partecipanti dovevano gestire un drone armato simulato e identificare i bersagli su uno schermo. Nonostante i partecipanti sapessero che l’IA forniva suggerimenti casuali e non basati su un’analisi reale, circa due terzi di loro hanno modificato le loro decisioni iniziali quando l’IA era in disaccordo.

Lo studio ha anche esaminato come l’aspetto fisico dell’IA influenzi la fiducia. Sono stati utilizzati diversi tipi di rappresentazioni dell’IA, tra cui robot umanoidi e robot a forma di scatola. I risultati mostrano che, sebbene i robot simili agli umani avessero un’influenza leggermente maggiore, la tendenza a fidarsi dell’IA era consistente in tutte le rappresentazioni.

Anche se lo studio si è concentrato su scenari militari, le sue implicazioni sono ampie:

- Forze dell’Ordine: L’IA viene sempre più integrata nelle decisioni di polizia. Questo studio suggerisce che le raccomandazioni dell’IA potrebbero influenzare le decisioni sugli interventi, come l’uso della forza.

- Emergenze Mediche: In medicina, l’IA è utilizzata per diagnosi e trattamenti. Lo studio sottolinea la necessità di cautela nell’integrare i consigli dell’IA in situazioni di emergenza.

- Altri Contesti Critici: La fiducia eccessiva nell’IA può influenzare anche altri ambiti ad alto rischio come il trading finanziario o le decisioni politiche strategiche.

I risultati dello studio sollevano interrogativi sulla psicologia della fiducia nell’IA. I fattori includono:

- Percezione di Obiettività: L’IA è vista come oggettiva e priva di pregiudizi.

- Sovrastima delle Capacità: Si tende ad attribuire all’IA capacità superiori a quelle reali.

- Bias dell’Automazione: Gli utenti attribuiscono un peso eccessivo alle informazioni generate dai computer.

- Delegazione di Responsabilità: Gli utenti possono sentirsi sollevati dalla responsabilità in decisioni difficili.

Il professor Colin Holbrook, uno dei ricercatori principali, avverte che, nonostante i limiti dell’IA siano stati spiegati, gli utenti spesso ignorano questi avvertimenti.

Per integrare l’IA in modo sicuro nei processi decisionali critici, si raccomanda di:

- Testare e validare accuratamente i sistemi di IA prima dell’uso.

- Fornire formazione completa sugli strumenti di IA.

- Stabilire protocolli chiari per l’uso dell’IA.

- Mantenere la supervisione umana e la possibilità di ignorare l’IA.

- Rivedere e aggiornare regolarmente i sistemi di IA.