La ricerca sull’architettura neurale (NAS) si occupa della selezione di modelli neurali per problemi di apprendimento specifici. Il NAS, tuttavia, è computazionalmente costoso per l’automazione e la democratizzazione dell’apprendimento automatico. Il successo iniziale del NAS è stato attribuito in parte al metodo di condivisione del peso , che ha contribuito alla drammatica accelerazione del rilevamento delle architetture. Ma perché viene criticato il metodo di condivisione del peso ?

Breve panoramica della condivisione del peso

Tradizionalmente, i metodi NAS erano costosi a causa dell’ampio spazio di ricerca combinatoria, che richiedeva il completamento di migliaia di reti neurali. Nel 2018, il documento ENAS (NAS efficiente) ha introdotto l’idea della condivisione del peso, in cui viene addestrato un solo set condiviso di parametri del modello per tutte le architetture.

Questi pesi condivisi sono stati utilizzati per calcolare le perdite di convalida di diverse architetture che sono quindi utilizzate come stime delle loro perdite di convalida. Dal momento che si è dovuto allenare solo un set di parametri, la condivisione del peso ha portato a un enorme aumento di velocità rispetto ai metodi precedenti, riducendo i tempi di ricerca su CIFAR-10 da 2.000-20.000 GPU-ora a soli 16.

Le precisioni di validazione calcolate usando pesi condivisi erano sufficienti per trovare buoni modelli a buon mercato. Tuttavia, questa correlazione, sebbene sufficiente, non significa che la condivisione del peso faccia bene.

Questo metodo è stato esaminato a causa delle sue scarse prestazioni in sostituzione della formazione completa del modello e si presume non sia coerente con i risultati dei recenti parametri di riferimento.

La tecnica di condivisione dei parametri tra i modelli figlio ha consentito a NAS efficienti di offrire prestazioni empiriche elevate, pur utilizzando un numero di ore GPU molto inferiore rispetto agli approcci di progettazione automatica dei modelli esistenti, e in particolare 1000 volte meno costosi dell’architettura neurale standard.

L’implementazione più popolare di pesi condivisi come sostituti di pesi autonomi è il metodo Random Search with Weight-Sharing (RS-WS), in cui i parametri condivisi sono ottimizzati eseguendo passaggi di gradiente utilizzando architetture campionate uniformemente a caso dallo spazio di ricerca.

Tuttavia, i professionisti hanno iniziato a chiedersi se la condivisione dei pesi tra i modelli accelerasse il NAS.

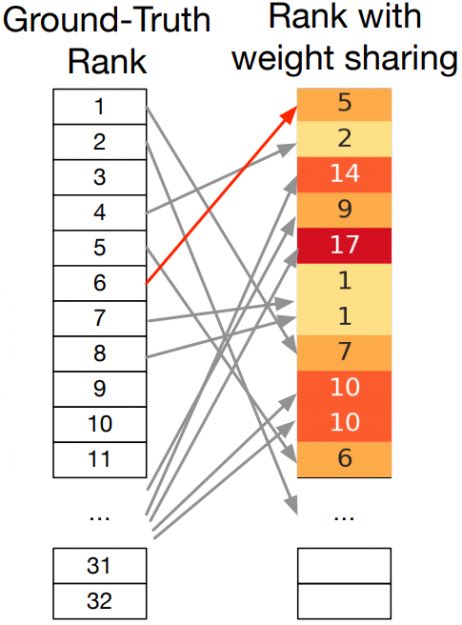

Nel tentativo di affrontare questo problema e presentare un caso per il meccanismo di condivisione del peso, i ricercatori della CMU hanno pubblicato un lavoro che elenca i loro risultati. Il documento afferma che la maggior parte delle critiche sulla condivisione del peso ha il problema del disturbo di grado come un evento comune. Il disordine di rango si verifica quando le prestazioni a peso condiviso delle architetture non sono correlate bene alle loro prestazioni autonome.

Il disordine di rango è un problema per quei metodi, che si basano sulle prestazioni dei pesi condivisi per classificare le architetture per la valutazione, in quanto causeranno loro di ignorare le reti che raggiungono un’elevata precisione quando i loro parametri vengono addestrati senza condividere.

Come l’approccio del deep learning per il rilevamento di oggetti si è evoluto nel corso degli anni

L’immagine sopra mostra i problemi di disordine di rango in cui i pesi condivisi sono a destra, mentre i pesi individuali allenati da zero sono a sinistra.

Per far fronte a questo, i ricercatori presentano un quadro unificante per la progettazione e l’analisi di metodi NAS basati su gradiente che sfruttano la struttura problematica sottostante per trovare rapidamente architetture ad alte prestazioni. Il framework consapevole della geometria, hanno scritto i ricercatori, ha portato agli algoritmi che:

godere di garanzie di convergenza più rapide rispetto ai metodi esistenti basati sul gradiente e;

ottenere una precisione all’avanguardia sugli ultimi benchmark NAS nella visione artificiale.

I risultati mostrano che questo nuovo framework supera le precedenti opere migliori sia per CIFAR che per ImageNet sia sullo spazio di ricerca DARTS sia su NAS-Bench-201.

Key Takeaways

Secondo gli autori, questo lavoro sui metodi di condivisione del peso ha cercato di stabilire quanto segue:

Il successo dei metodi di condivisione del peso non dovrebbe sorprendere dato il fatto che l’inclinazione della comunità ML verso l’ottimizzazione non convessa di modelli con parametri eccessivi.

Il disordine di rango non dovrebbe preoccupare poiché ottenere architetture di alta qualità ha una priorità maggiore rispetto a classificarle.

Le prestazioni talvolta scarse della condivisione del peso sono il risultato di problemi di ottimizzazione che possono essere risolti mentre si utilizza ancora la condivisione del peso.

A tal fine, viene proposto un algoritmo esponenziale consapevole della geometria (GAEA) che è applicabile a molti metodi NAS diffusi e raggiunge risultati all’avanguardia attraverso diverse impostazioni.