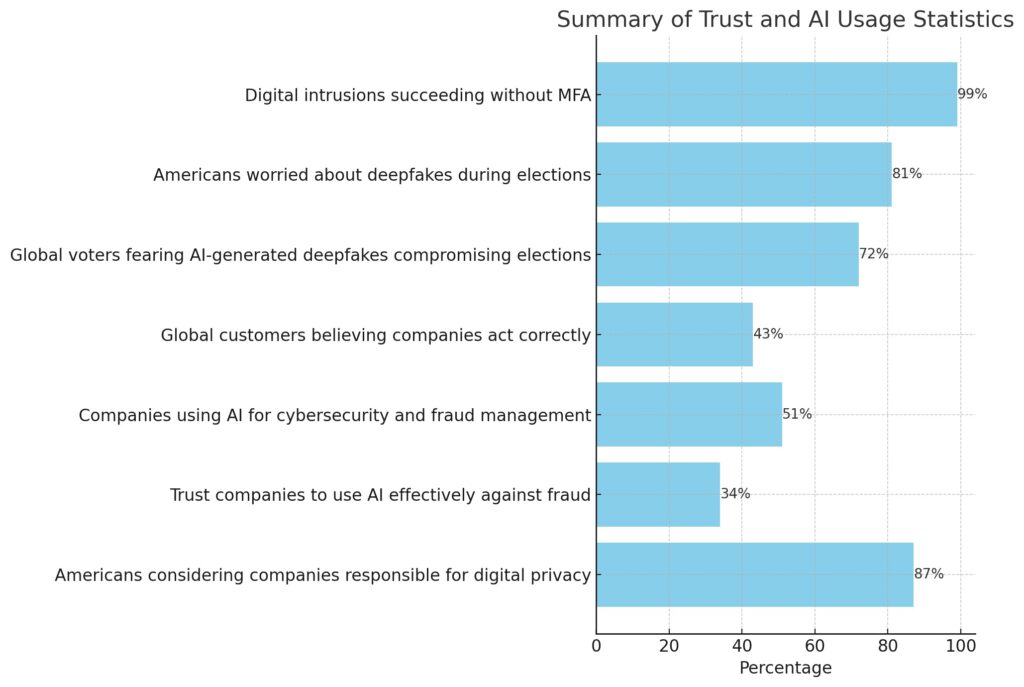

Con l’87% degli americani che considera le aziende responsabili della privacy digitale, ma solo il 34% che si fida della loro capacità di usare l’intelligenza artificiale (IA) in modo efficace per proteggersi dalle frodi, emerge un significativo divario di fiducia. Nonostante il 51% delle aziende utilizzi l’IA per la sicurezza informatica e la gestione delle frodi, solo il 43% dei clienti globali crede che le aziende stiano agendo correttamente. È urgente colmare questo divario di fiducia e garantire che le misure di sicurezza basate sull’IA ispirino fiducia. I deepfake stanno ampliando ulteriormente questo divario.

Il crescente divario di fiducia si riflette in tutti gli ambiti, dai rapporti di acquisto tra clienti e aziende fidate da lungo tempo fino alle elezioni in sette dei dieci paesi più grandi del mondo. Il Trust Index 2024 di Telesign offre nuovi dati su questo divario crescente tra clienti e aziende da cui acquistano, e più ampiamente riguardo alle elezioni nazionali.

I deepfake e la disinformazione stanno aumentando la sfiducia tra aziende, clienti e cittadini coinvolti nelle elezioni di quest’anno. Secondo Andy Parsons, direttore senior della Content Authenticity Initiative di Adobe, “Una volta ingannati da un deepfake, potresti non credere più a ciò che vedi online. Quando la gente inizia a dubitare di tutto e non riesce a distinguere tra realtà e finzione, la democrazia stessa è minacciata”.

La diffusa diffusione di deepfake su piattaforme social, spesso gestite da account falsi automatizzati, rende ancora più difficile distinguere tra contenuti autentici e falsi. Questa pratica è diventata comune a livello globale. Ad esempio, nel settembre 2020, Graphika e Facebook hanno smantellato una rete cinese di account legati all’“Operazione Naval Gazing”, che pubblicava contenuti su questioni geopolitiche, inclusa la situazione tra USA e Cina nel Mar Cinese Meridionale.

Gli stati-nazione stanno investendo considerevoli risorse nelle campagne di disinformazione per influenzare le elezioni in nazioni con cui sono in conflitto, spesso con l’intento di destabilizzare la democrazia o provocare disordini sociali. Il rapporto annuale sulla valutazione delle minacce 2024 della comunità di intelligence statunitense afferma che “La Russia sta utilizzando l’intelligenza artificiale per creare deepfake e sta sviluppando la capacità di ingannare gli esperti. Gli individui in zone di conflitto e ambienti politici instabili possono essere bersagli particolarmente allettanti per questa influenza maligna e fasulla”.

Gli aggressori stanno intensificando i loro sforzi nella creazione di deepfake utilizzando reti generative avversarie (GAN) avanzate, con impatti diretti sugli elettori in tutto il mondo. Secondo l’indice di Telesign, il 72% degli elettori globali teme che i deepfake, con video e clonazioni vocali generati dall’IA, stiano compromettendo le elezioni attuali. L’81% degli americani è particolarmente preoccupato per il potenziale impatto di questi contenuti durante le elezioni. Gli americani sono tra i più informati riguardo agli annunci e ai messaggi politici generati dall’IA: il 45% ha visto un annuncio o un messaggio simile nell’ultimo anno, mentre il 17% lo ha visto nella scorsa settimana.

I GAN, motori tecnologici alla base dei deepfake, stanno aumentando la loro popolarità. Da aggressori disonesti a sofisticati stati-nazione come la Russia, tutti stanno incrementando gli sforzi sui GAN per creare contenuti che sembrano autentici.

Aumentando l’autenticità dei deepfake, cresce anche l’impatto sulla fiducia dei clienti e degli elettori. Data la loro difficoltà nel rilevamento, i GAN sono ampiamente utilizzati in attacchi di phishing, furto di identità e ingegneria sociale. Il New York Times ha proposto un quiz per testare la capacità dei lettori di identificare immagini generate dall’IA rispetto a quelle reali, evidenziando l’avanzamento dei GAN nella creazione di deepfake.

I GAN operano attraverso due reti neurali concorrenti: il generatore crea dati sintetici, come immagini o audio falsi, mentre il discriminatore valuta quanto siano realistici. L’obiettivo è che il generatore continui a migliorare la qualità dei dati per ingannare il discriminatore. Questa complessità permette la creazione di deepfake difficilmente distinguibili da contenuti autentici, minando la fiducia. Questi contenuti falsi generati dall’IA possono diffondersi rapidamente attraverso i social media e gli account falsi, erodendo la fiducia non solo nei marchi ma anche nei processi democratici.

Telesign utilizza oltre 2.200 segnali di identità digitale per proteggere le transazioni e accrescere la fiducia tra aziende e clienti. La loro Verify API utilizza AI e ML per migliorare la verifica omnicanale, semplificando le transazioni e riducendo i rischi di frode.

Il Trust Index di Telesign evidenzia la preoccupazione riguardo alla corretta igiene informatica. Il loro studio ha scoperto che il 99% delle intrusioni digitali ha successo quando non è attivata l’autenticazione a più fattori (MFA). Le violazioni dell’identità possono rapidamente erodere la fiducia dei clienti, rendendo cruciale un robusto piano di Identity and Access Management (IAM).

Con l’avanzamento delle reti neurali e dei GAN, è fondamentale per i CISO e i CIO rafforzare la sicurezza per prevenire l’uso malintenzionato di deepfake. Il riconoscimento di identità compromesse e la chiusura di vulnerabilità sono passi cruciali per proteggere la fiducia dei clienti e l’integrità delle elezioni democratiche.