Google promette principi etici per guidare lo sviluppo dell’IA militare

La compagnia dice che le linee guida includeranno un divieto allo sviluppo di armi ad intelligenza artificiale

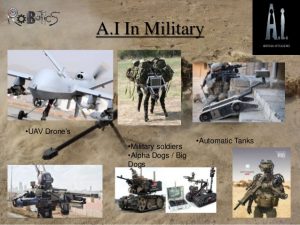

Google sta elaborando una serie di linee guida che guideranno il suo coinvolgimento nello sviluppo di strumenti di intelligenza artificiale per le forze armate, secondo quanto riportato da The New York Times e Defense One . Che cosa esattamente queste linee guida stabiliranno non è chiaro, ma Google ha detto al Times che includeranno il divieto dell’uso dell’intelligenza artificiale nelle armi. I principi dovrebbero essere annunciati per intero nelle prossime settimane. Sono una risposta alla controversia sulla decisione dell’azienda di sviluppare strumenti di intelligenza artificiale per il Pentagono che analizzano i filmati di sorveglianza dei droni.

Google sta elaborando una serie di linee guida che guideranno il suo coinvolgimento nello sviluppo di strumenti di intelligenza artificiale per le forze armate, secondo quanto riportato da The New York Times e Defense One . Che cosa esattamente queste linee guida stabiliranno non è chiaro, ma Google ha detto al Times che includeranno il divieto dell’uso dell’intelligenza artificiale nelle armi. I principi dovrebbero essere annunciati per intero nelle prossime settimane. Sono una risposta alla controversia sulla decisione dell’azienda di sviluppare strumenti di intelligenza artificiale per il Pentagono che analizzano i filmati di sorveglianza dei droni.

Sebbene le aziende tecnologiche presentino regolarmente contratti per il settore della difesa statunitense, il coinvolgimento di Google (una società che una volta vantava il motto “non essere cattivo”) e l’avanguardia della tecnologia IA ha sollevato le sopracciglia, sia all’interno che all’esterno dell’azienda. La notizia del contratto del Pentagono è stata resa pubblica per la prima volta da Gizmodo a marzo e migliaia di dipendenti di Google hanno firmato una petizione per chiedere alla società di ritirarsi da tutto questo lavoro. Circa una dozzina di persone hanno persino rassegnato le dimissioni .

Le e-mail interne ottenute dal Times mostrano che Google era a conoscenza del turbamento che questa notizia potrebbe causare. Il capo scienziato di Google Cloud, Fei-Fei Li, ha detto ai colleghi che dovrebbero “evitare a TUTTI I COSTI qualsiasi menzione o implicazione di IA” quando si annuncia il contratto del Pentagono. “L’IA con armi è probabilmente uno degli argomenti più sensibilizzati dell’IA – se non il più. Questa è carne rossa per i media per trovare tutti i modi per danneggiare Google “, ha detto Li.

Ma Google non ha mai finito per fare l’annuncio, e da allora è stato sul piede posteriore a difendere la sua decisione. La società dice che la tecnologia che sta aiutando a costruire per il Pentagono semplicemente “contrassegna le immagini per la revisione umana” ed è per “solo usi non offensivi”. Il contratto è anche piccolo per gli standard del settore – vale solo 9 milioni di dollari per Google, secondo il volte .

Ma questo contesto extra non ha represso il dibattito in azienda, con dipendenti di Google che discutono i pro ei contro dell’IA militare nelle riunioni e nelle bacheche interne. Molti importanti ricercatori della compagnia si sono già pronunciati contro l’uso di armi ad intelligenza artificiale. Jeff Dean, che dirige l’intelligenza artificiale a Google, ha detto questo mese di aver firmato una lettera nel 2015 che si oppone allo sviluppo di armi autonome. I dirigenti di DeepMind, la filiale di Google con sede a Londra, hanno firmato una petizione simile e l’hanno inviata alle Nazioni Unite l’anno scorso.

Ma la domanda che devono affrontare questi dipendenti (e Google stessa) è: dove tracciate la linea? Usare l’apprendimento automatico per analizzare i filmati di sorveglianza per i militari conta come “IA armata”? Probabilmente no. Ma cosa succederebbe se quell’analisi informasse le decisioni future sugli attacchi dei droni? Importa allora? Come fa Google a sapere se è successo?

Queste sono domande difficili, e probabilmente è impossibile rispondere in un modo che soddisfi tutte le parti. Nell’impegnarsi a elaborare linee guida, Google si è data un compito difficile.