I modelli di generazione dell’IA da testo a immagine sono molto popolari in questi giorni.

Quando OpenAI ha annunciato Dall-E2 , Internet era in delirio.

Poco dopo, Google ha annunciato che sta costruendo il proprio strumento di intelligenza artificiale da testo a immagine chiamato Imagen .

Ma anche prima che Imagen raggiunga una fase beta privata, Google ha annunciato un altro strumento di intelligenza artificiale che sostanzialmente fa la stessa cosa: esegue il rendering di immagini iperrealistiche da brevi input testuali.

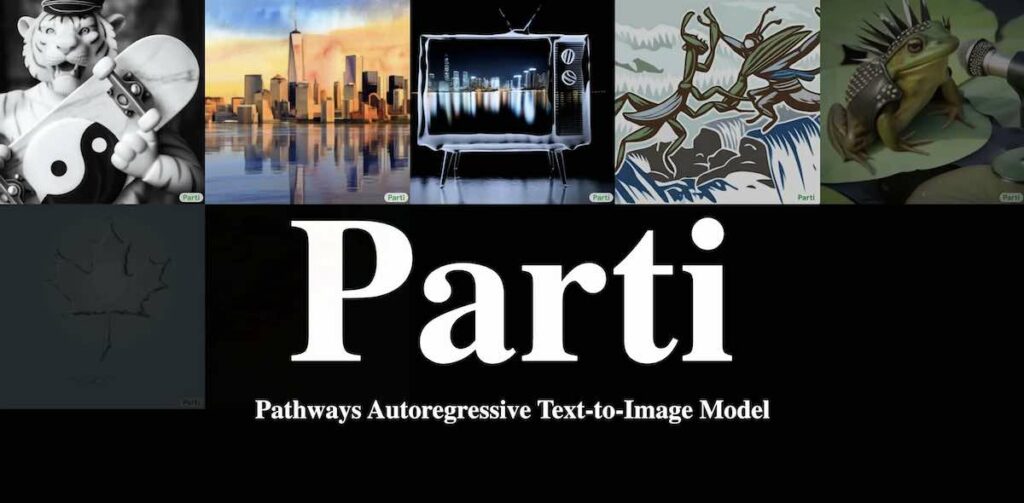

Il nuovo strumento si chiama Parti che sta per Pathways Autoregressive Text-to-Image.

Google Parti Tweet di Google AI

Parliamo di alcune cose.

Che cos’è Google Parti e come funziona?

In cosa è diverso da Google Imagen?

Come si confronta con Dall-E2 e MidJourney di OpenAI?

Che cos’è Google Parti?

Parti è un modello di generazione di intelligenza artificiale da testo a immagine che accetta un semplice messaggio di testo da un utente e genera immagini iperrealistiche con il suo codificatore-decodificatore in grado di scalare fino a 20 miliardi di parametri.

Dai un’occhiata a come è in grado di generare il seguente insieme di immagini con lo stesso prompt di testo ma parametri variabili.

Prompt: una foto di un astronauta a cavallo nella foresta. C’è un fiume di fronte a loro con le ninfee.

Screenshot da Google Parti

Guardando queste immagini, è chiaro che man mano che i modelli vengono ingranditi, anche l’immagine risultante migliora.

In cosa differisce da Google Imagen e Dall-E2?

Imagen di Google e DALL·E 2 di OpenAI sono modelli di diffusione. Google Parti, invece, segue un modello autoregressivo.

Secondo gli ingegneri di Google, autoregressivo e diffusione sono modelli generativi complementari e stanno esplorando nuove idee che combinano il meglio di entrambi i modelli.

Il nostro obiettivo è portare nel mondo le esperienze degli utenti basate su questi modelli in un modo sicuro e responsabile che ispiri la creatività.

Ma indipendentemente dall’architettura e dal metodo di formazione, il risultato finale è lo stesso: questi modelli genereranno immagini surreali e dettagliate basate sull’input di testo descrittivo dell’utente.

Come si confronta con Dall-E2 e MidJourney di OpenAI?

Poiché Parti non è ancora disponibile per l’accesso pubblico, ho preso un messaggio di testo da una foto generata campione nel sito Web di Parti e ho utilizzato lo stesso prompt per generare immagini in Dall-E2 e MidJourney.

Ecco il prompt.

Un castoro dignitoso con gli occhiali, un gilet e una cravatta colorata. Si trova accanto a un’alta pila di libri in una biblioteca. foto dslr.

Chi pensi che abbia interpretato meglio?

Per me, Google Parti ha fatto meglio. È follemente realistico e sembra molto meglio della sua concorrenza.

Un’area minore in cui penso che sia leggermente incasinato è il braccio destro sulla pila di libri. Ma a parte questo, ha funzionato abbastanza bene, specialmente con la sfocatura della profondità aggiunta.

Dall-E2 è riuscito a creare anche un castoro realistico ma la cravatta non è troppo colorata e il riflesso negli occhiali è un po’ incasinato.

Il risultato di MidJourney sembra più un peluche che uno reale. Inoltre non è in piedi accanto a un’alta pila di libri e la cravatta non è colorata.

Pensieri finali

Nel complesso, Parti di Google sembra molto promettente.

Sono passati solo un paio d’anni da quando il generatore di immagini AI è diventato una cosa e finora ha fatto notevoli miglioramenti in termini di qualità dei risultati.

Immagino che un giorno gli strumenti di intelligenza artificiale da testo a immagine diventeranno così avanzati da essere in grado di creare immagini indistinguibili dalla vita reale.

Le possibilità di questo strumento sono infinite e possiamo solo immaginare cosa riserverà il futuro per questa straordinaria tecnologia.

di Jim Clyde Monge da medium.com