L’intelligenza artificiale (AI) su larga scala sta vivendo un momento di intensa ridefinizione, con Google che lancia una sfida diretta al predominio infrastrutturale di NVIDIA attraverso un aggiornamento radicale del suo sistema di supercalcolo integrato. Con la presentazione delle istanze AI di nuova generazione basate sulle TPU “Ironwood” e sulle CPU “Axion”, Google Cloud non sta semplicemente rilasciando nuovi prodotti, ma sta proponendo un cambio di paradigma: il passaggio dai server generici ai supercomputer AI personalizzati.

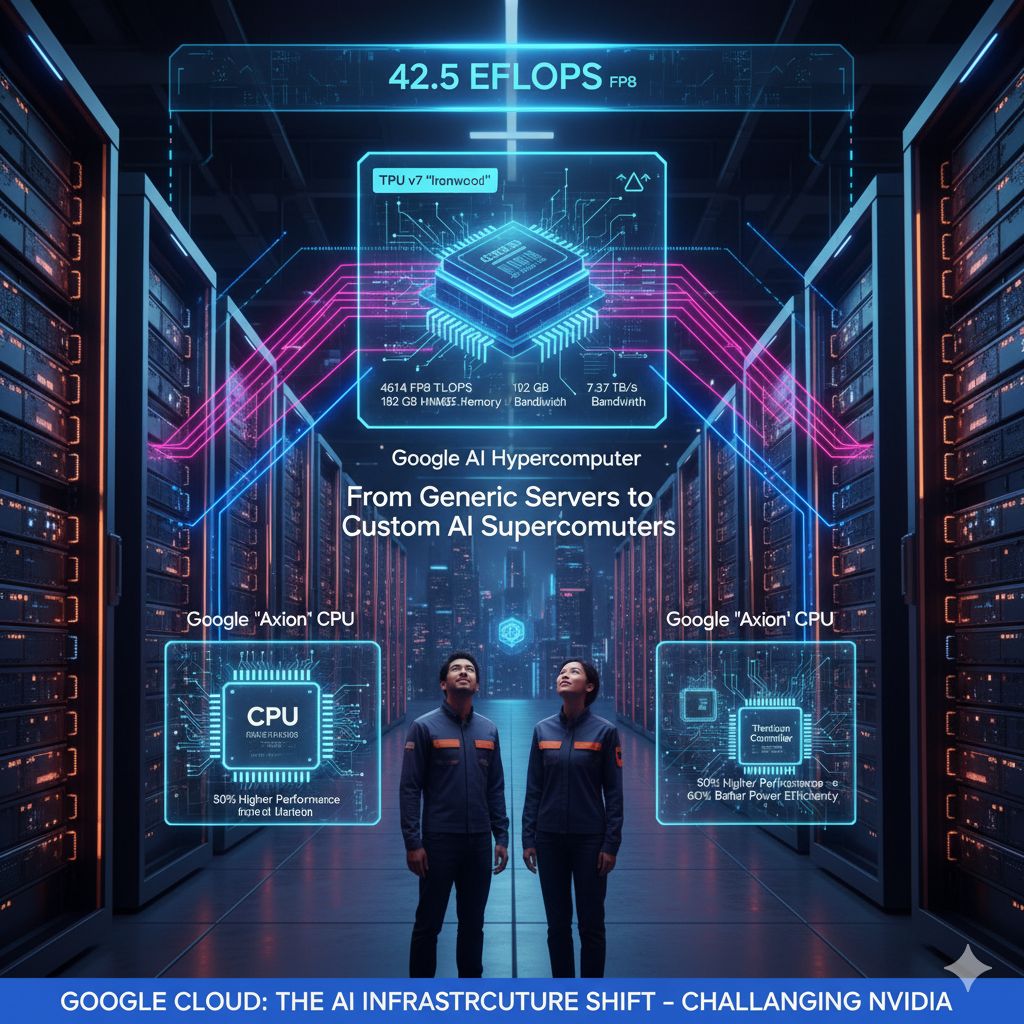

Il fulcro di questa offensiva è rappresentato da Ironwood, il processore Tensor di settima generazione (TPU v7) di Google. Questo chip è una vera e propria centrale di calcolo, vantando prestazioni di elaborazione sbalorditive pari a 4614 FP8 TFLOPS e una memoria HBM3E da 192 GB con una larghezza di banda di 7,37 TB/s.

La vera forza si manifesta quando questi processori vengono assemblati in cluster. Un singolo Ironwood Pod è equipaggiato con 9.216 Ironwood, una configurazione che fornisce una potenza massima di 42,5 exaflop FP8 (EFLOPS). Per dare un’idea della portata di questa cifra, essa supera di gran lunga la potenza di sistemi concorrenti come l’NVIDIA GB300 NVL72, un chiaro segnale che Google punta a supportare l’addestramento e l’inferenza di modelli di AI più grandi e complessi mai visti. Questi chip sono interconnessi da una rete interchip da 9,6 Tb/s, collegando un totale di circa 1,77 PB di memoria HBM3E. A garanzia della stabilità operativa critica per carichi di lavoro così intensivi, Google ha implementato la tecnologia di commutazione dei circuiti ottici, permettendo al sistema di riconfigurare istantaneamente i percorsi in caso di guasti hardware e garantendo una manutenzione senza interruzioni.

A complemento della potenza di Ironwood, Google ha contemporaneamente introdotto la propria tecnologia CPU con il rilascio di Axion, un processore server basato sull’architettura ARMv9. Axion è costruito sull’architettura Neoverse V2 di ARM e offre un netto vantaggio in termini di efficienza: Google dichiara prestazioni fino al 50% superiori e un’efficienza energetica migliorata del 60% rispetto alle più recenti CPU x86, oltre a un vantaggio prestazionale del 30% rispetto alle attuali istanze ARM di fascia alta.

Queste CPU sono fondamentali perché agiscono come l’infrastruttura di hosting e gestione per le TPU e il sistema più ampio. I server che utilizzano Axion e Ironwood sono potenziati dal controller Titanium, un chip di Google che dedica le attività di networking, sicurezza ed elaborazione I/O, alleggerendo il carico sulla CPU host. Questa integrazione di hardware personalizzato massimizza le prestazioni complessive e la gestibilità del sistema.

Axion alimenta diverse istanze Cloud, tra cui le istanze C4A, ottimizzate per carichi di lavoro ad alte prestazioni sostenuti con fino a 72 vCPU e 576 GB di memoria; le istanze N4A per casi d’uso più generici (come web serving); e le configurazioni C4A Metal, bare-metal ideali per lo sviluppo nativo ARM.

L’annuncio congiunto di Ironwood e Axion è il pilastro del nuovo AI Hypercomputer di Google. Questo non è solo un cluster di componenti, ma una piattaforma integrata che fonde risorse di calcolo, archiviazione e rete sotto un unico livello di gestione. Questa strategia trasforma l’infrastruttura cloud da una raccolta di risorse virtualizzate a un supercomputer integrato e ottimizzato per l’AI.

I benefici di questo approccio non sono teorici: secondo la società di ricerche IDC, le aziende che hanno adottato gli ipercomputer basati sull’AI hanno ottenuto un ritorno sull’investimento (ROI) medio del 353% in tre anni, una riduzione del 28% dei costi IT e un aumento del 55% dell’efficienza operativa. Il mercato ha già risposto: Anthropic ha ampliato la sua partnership con Google per utilizzare fino a un milione di chip Ironwood, e Literix ha adottato il sistema per l’addestramento del suo modello multimodale LTX-2.

Con l’aggiunta di Axion, Google completa la sua gamma di semiconduttori personalizzati, che comprende già TPU, VCU, Tensor Mobile Chips e l’infrastruttura Titanium. La sua strategia di puntare sui “supercomputer basati sull’intelligenza artificiale personalizzati” è la mossa chiave per competere direttamente con NVIDIA e AMD nel mercato in rapida crescita delle infrastrutture AI, segnando la fine dell’era dei server generici e l’inizio di quella del calcolo AI-first.