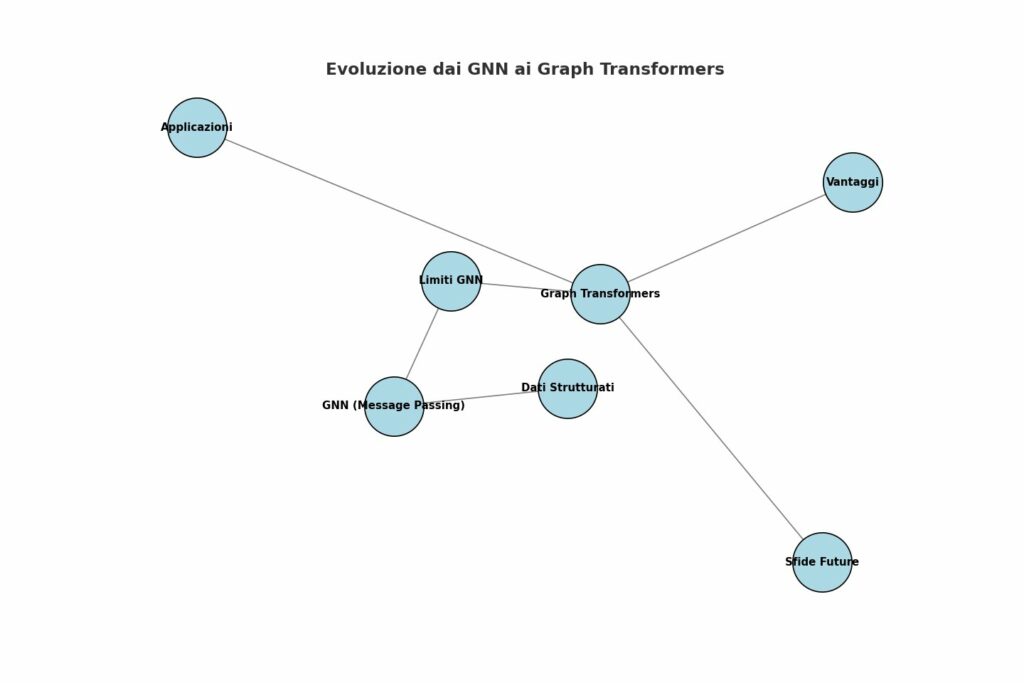

Immagina ogni riga di un database, ogni scheda strutturata, ogni tabella ordinatamente disposta: spesso tratteniamo l’informazione come un’isola. Ma in realtà, ogni pezzo di conoscenza esiste in connessione con altri — un nodo immerso in una rete più vasta. È a partire da questa consapevolezza che Dr. Jure Leskovec, tra i pionieri dei Graph Neural Networks (GNN) alla Stanford, ci conduce in un viaggio affascinante verso il cuore dell’evoluzione dell’IA: i Graph Transformers.

La riflessione alla base è potente: le informazioni aziendali, spesso custodite gelosamente in tabelle e archivi, possono essere reinterpretate come grafi — reti di conoscenza dove gli elementi non sono isolati, ma dialogano tra di loro. I GNN hanno insegnato all’IA a pensare in termini di vicinato e aggregazione locale, ma ora i Graph Transformers introducono una visione più ampia, consentendo a ogni nodo di “mettere a fuoco” direttamente qualsiasi altro nodo, grazie ai meccanismi di attenzione. Il risultato? Rappresentazioni più ricche, una maggiore precisione e meno distorsioni rispetto ai modelli precedenti.

Il punto di partenza del dibattito è il message passing: i GNN ottengono la loro forza perché ogni nodo, iterativamente, raccoglie informazioni dai vicini. Ma questo approccio presenta dei limiti:

- Over‑squashing: le informazioni si comprimono troppo man mano che si attraversano strati e nodi distanti.

- Contesto limitato: catturare dipendenze a lunga distanza richiede molti livelli, aumentando la complessità e il rumore.

- Espressività ridotta: alcuni schemi grafici non possono essere distinti se ci si affida solo all’ambiente locale.

I Graph Transformers abolano questi limiti: grazie alla self-attention, ogni nodo può valutare l’importanza di altri nodi, anche lontani, direttamente e in modo parametricamente flessibile.

Secondo Kumo e la visione di Leskovec, queste nuove architetture possono rivoluzionare l’analisi dei dati strutturati in moltissimi scenari. Pensiamo, ad esempio, a:

- Previsione di proprietà molecolari in bioinformatica

- Rilevamento di frodi in transazioni finanziarie

- Raccomandazioni più intelligenti nei social network

- Ragionamento su knowledge graph e sistemi cognitivi

Il campo è in fermento: studi e survey recenti delineano le architetture emergenti dei Graph Transformers, i loro fondamenti teorici e le applicazioni più promettenti. Ad esempio:

- Tutto il potenziale dei transformer “ritagliati” sui grafi, in cui si incorporano token, posizioni e attenzioni consapevoli della struttura.

- Le difficoltà che restano: scalabilità, efficienza, generalizzazione, robustezza, interpretabilità, dinamismo dei grafi, qualità dei dati.

- Modelli specifici come Exphormer, che utilizzano grafi expander per ridurre la complessità e catturare efficacemente dipendenze a lungo raggio, anche su dataset di grandi dimensioni.

Il fascino dei Graph Transformers sta proprio nella capacità di combinare attitudine relazionale e potenza elastica dell’attenzione del Transformer. Non si tratta di forzare i dati in vecchie strutture, ma di adattare il modello a mettere in luce le relazioni nascoste. Solo che, come ogni potente strumento, richiede:

- Attenti meccanismi di riduzione della complessità (attenzioni sparse, sub-grafi, campionamenti)

- Encodings strutturali (come laplaciani, distanze, random walk, etc.)

- Architetture ibride (GNN+Transformer) che uniscano il meglio dei due mondi.