L’ULTIMA SVOLTA DI OPENAI È SORPRENDENTEMENTE POTENTE, MA CONTINUA A COMBATTERE I SUOI DIFETTI

Il completamento automatico finale

Tutte le opzioni di condivisione

Il nuovo arrivo più emozionante nel mondo dell’IA sembra, in superficie, disarmantemente semplice. Non è un sottile programma di gioco in grado di superare il robot più raffinato dell’umanità o meccanicamente avanzato che si ribalta come un olimpionico . No, è semplicemente un programma di completamento automatico, come quello nella barra di ricerca di Google. Inizi a digitare e prevede ciò che verrà dopo. Ma mentre questo sembra semplice, è un’invenzione che potrebbe finire per definire il decennio a venire.

Il programma stesso si chiama GPT-3 ed è il lavoro del laboratorio di intelligenza artificiale OpenAI di San Francisco, un gruppo che è stato fondato con l’ambizioso (alcuni dicono delirante) obiettivo di guidare lo sviluppo dell’intelligenza generale artificiale o AGI: programmi per computer che possiedono tutta la profondità, la varietà e la flessibilità della mente umana. Per alcuni osservatori, GPT-3 – sebbene decisamente non AGI – potrebbe benissimo essere il primo passo verso la creazione di questo tipo di intelligenza. Dopotutto, sostengono, che cos’è il linguaggio umano se non un programma di completamento automatico incredibilmente complesso in esecuzione sulla scatola nera del nostro cervello?

INSERISCI QUALSIASI TESTO E GPT-3 LO COMPLETA PER TE: SEMPLICITÀ STESSA

Come suggerisce il nome, GPT-3 è il terzo di una serie di strumenti di completamento automatico progettati da OpenAI. (GPT sta per “trasformatore generativo pre-addestrato”.) Il programma ha richiesto anni di sviluppo, ma sta anche navigando in un’ondata di recente innovazione nel campo della generazione di testo AI. In molti modi, questi progressi sono simili al salto in avanti nell’elaborazione delle immagini AI che ha avuto luogo dal 2012 in poi. Questi progressi hanno dato il via all’attuale boom dell’IA , portando con sé una serie di tecnologie abilitate alla visione artificiale , dalle auto a guida autonoma, all’onnipresente riconoscimento facciale, ai droni. È ragionevole, quindi, pensare che le nuove funzionalità di GPT-3 e simili potrebbero avere effetti simili di vasta portata.

Come tutti i sistemi di apprendimento profondo, GPT-3 cerca modelli nei dati. Per semplificare le cose, il programma è stato addestrato su un enorme corpus di testo che è estratto per regolarità statistiche. Queste regolarità sono sconosciute agli umani, ma sono memorizzate come miliardi di connessioni ponderate tra i diversi nodi della rete neurale di GPT-3. È importante sottolineare che non vi è alcun input umano coinvolto in questo processo: il programma cerca e trova schemi senza alcuna guida, che quindi utilizza per completare i messaggi di testo. Se inserisci la parola “fuoco” in GPT-3, il programma sa, in base ai pesi nella sua rete, che le parole “camion” e “allarme” hanno molte più probabilità di seguire rispetto a “lucido” o “elfico”. Finora così semplice.

Ciò che differenzia GPT-3 è la scala su cui opera e la serie sbalorditiva di compiti di completamento automatico che questo gli consente di affrontare. Il primo GPT, rilasciato nel 2018, conteneva 117 milioni di parametri, che sono i pesi delle connessioni tra i nodi della rete e un buon proxy per la complessità del modello. GPT-2, rilasciato nel 2019, conteneva 1,5 miliardi di parametri. Ma GPT-3, al confronto, ha 175 miliardi di parametri, oltre 100 volte in più rispetto al suo predecessore e dieci volte in più rispetto a programmi comparabili.

L’INTERA WIKIPEDIA IN INGLESE COSTITUISCE SOLO LO 0,6 PERCENTO DEI DATI DI ALLENAMENTO DI GPT-3

Il set di dati su cui è stato addestrato GPT-3 è allo stesso modo gigantesco. È difficile stimare la dimensione totale, ma sappiamo che l’intera Wikipedia inglese, che comprende circa 6 milioni di articoli, costituisce solo lo 0,6 per cento dei suoi dati di formazione. (Anche se anche quella cifra non è completamente accurata come GPT-3 si legge leggendo alcune parti del database più volte di altre.) Il resto proviene da libri digitalizzati e vari collegamenti web. Ciò significa che i dati di allenamento di GPT-3 includono non solo articoli come articoli di notizie, ricette e poesie, ma anche manuali di codifica, fanfiction, profezie religiose, guide agli uccelli canori della Bolivia e qualsiasi altra cosa tu possa immaginare. Qualsiasi tipo di testo che è stato caricato su Internet è probabilmente diventato utile per il potente mulino per la corrispondenza dei modelli di GPT-3. E sì, questo include anche le cose cattive. Libri di testo pseudoscientifici, teorie della cospirazione, massetti razzisti e manifesti dei tiratori di massa. Sono anche lì, per quanto ne sappiamo; se non nel loro formato originale, riflesso e analizzato da altri saggi e fonti. È tutto lì, alimentando la macchina.

Ciò che questa profondità e complessità insopportabili consente, tuttavia, è una profondità e una complessità corrispondenti nell’output. Potresti aver visto esempi fluttuare di recente su Twitter e sui social media, ma si scopre che un’intelligenza artificiale con completamento automatico è uno strumento meravigliosamente flessibile semplicemente perché così tante informazioni possono essere archiviate come testo. Nel corso delle ultime settimane, OpenAI ha incoraggiato questi esperimenti seminando membri della comunità AI con accesso all’API commerciale di GPT-3 (una semplice interfaccia text-in, text-out che l’azienda sta vendendo ai clienti come beta privata) . Ciò ha comportato un’ondata di nuovi casi d’uso.

È poco completo, ma ecco un piccolo esempio di cose che le persone hanno creato con GPT-3:

Un motore di ricerca basato su domande. È come Google ma per domande e risposte. Digita una domanda e GPT-3 ti indirizza all’URL di Wikipedia pertinente per la risposta.

Un chatbot che ti consente di parlare con personaggi storici . Poiché GPT-3 è stato formato su così tanti libri digitalizzati, ha assorbito una discreta quantità di conoscenze relative a pensatori specifici. Ciò significa che puoi adescare GPT-3 per parlare come il filosofo Bertrand Russell, per esempio, e chiedergli di spiegare le sue opinioni. Il mio esempio preferito di questo, tuttavia, è un dialogo tra Alan Turing e Claude Shannon che viene interrotto da Harry Potter, perché i personaggi di fantasia sono accessibili a GPT-3 come quelli storici.

Risolvi i puzzle di linguaggio e sintassi da alcuni esempi. Questo è meno divertente di alcuni esempi ma molto più impressionante per gli esperti del settore. Puoi mostrare a GPT-3 determinati schemi linguistici (come “il produttore di alimenti diventa produttore di alimenti” e “l’olio di oliva diventa olio di olive”) e completerà tutti i nuovi messaggi che lo mostrerai correttamente. Questo è eccitante perché suggerisce che GPT-3 è riuscito ad assorbire alcune profonde regole del linguaggio senza alcun addestramento specifico. Come ha affermato il professore di informatica Yoav Goldberg – che ha condiviso molti di questi esempi su Twitter – tali abilità sono “nuove e super eccitanti” per l’IA, ma non significano che GPT-3 abbia “padroneggiato” il linguaggio.

Generazione di codice basata su descrizioni di testo. Descrivi un elemento di design o il layout di pagina di tua scelta in parole semplici e GPT-3 sputa il codice pertinente. Gli armeggi hanno già creato tali dimostrazioni per più linguaggi di programmazione diversi.

Rispondi a domande mediche . Uno studente di medicina dal Regno Unito ha usato GPT-3 per rispondere alle domande di assistenza sanitaria. Il programma non solo ha dato la risposta giusta, ma ha spiegato correttamente il meccanismo biologico sottostante.

Crawler sotterraneo basato su testo. Forse hai già sentito parlare di AI Dungeon prima, un gioco di avventura basato su testo basato sull’intelligenza artificiale, ma potresti non sapere che è la serie GPT che lo fa spuntare. Il gioco è stato aggiornato con GPT-3 per creare avventure testuali più convincenti .

Trasferimento di stile per il testo. Inserisci il testo scritto in un certo stile e GPT-3 può cambiarlo in un altro. In un esempio su Twitter , un utente ha inserito il testo in “linguaggio semplice” e ha chiesto a GPT-3 di cambiarlo in “linguaggio legale”. Questo trasforma gli input da “il mio padrone di casa non ha mantenuto la proprietà” in “I Convenuti hanno permesso alla proprietà immobiliare di andare in rovina e non sono riusciti a rispettare i codici e le normative di salute e sicurezza statali e locali”.

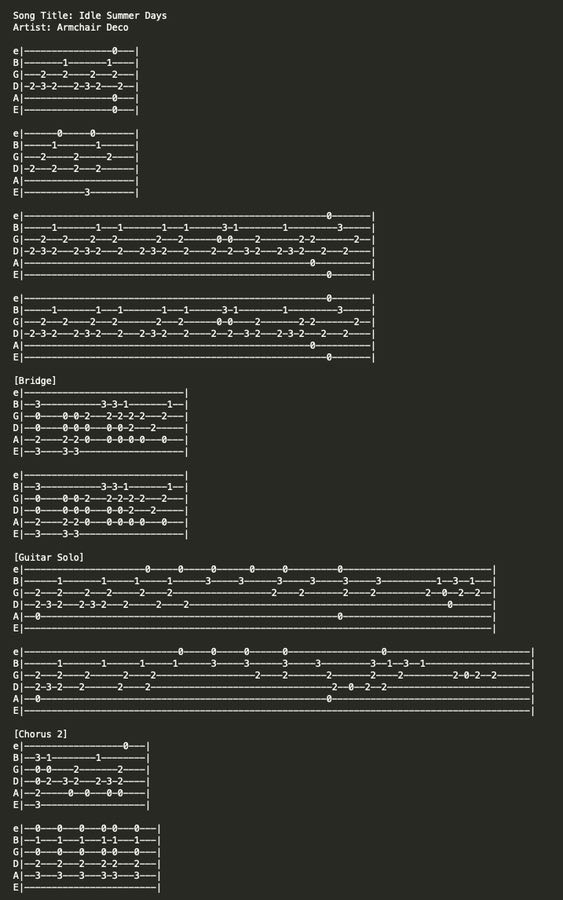

Componi le tablature per chitarra . Le schede Guitar sono condivise sul Web utilizzando file di testo ASCII, quindi puoi scommettere che comprendono parte del set di dati di allenamento di GPT-3. Naturalmente, ciò significa che GPT-3 può generare musica da solo dopo aver ricevuto alcuni accordi per iniziare.

Scrivi fiction creativa. Questa è una vasta area all’interno del skillset di GPT-3 ma incredibilmente impressionante. La migliore collezione di campioni letterari del programma deriva dal ricercatore indipendente e scrittore Gwern Branwen che ha raccolto un tesoro di scrittura GPT-3 di qui . Si va da un tipo di gioco di parole a una frase noto come Tom Swifty alla poesia nello stile di Allen Ginsberg, TS Eliot, Em ily Dickinson e copypasta di Navy SEAL .

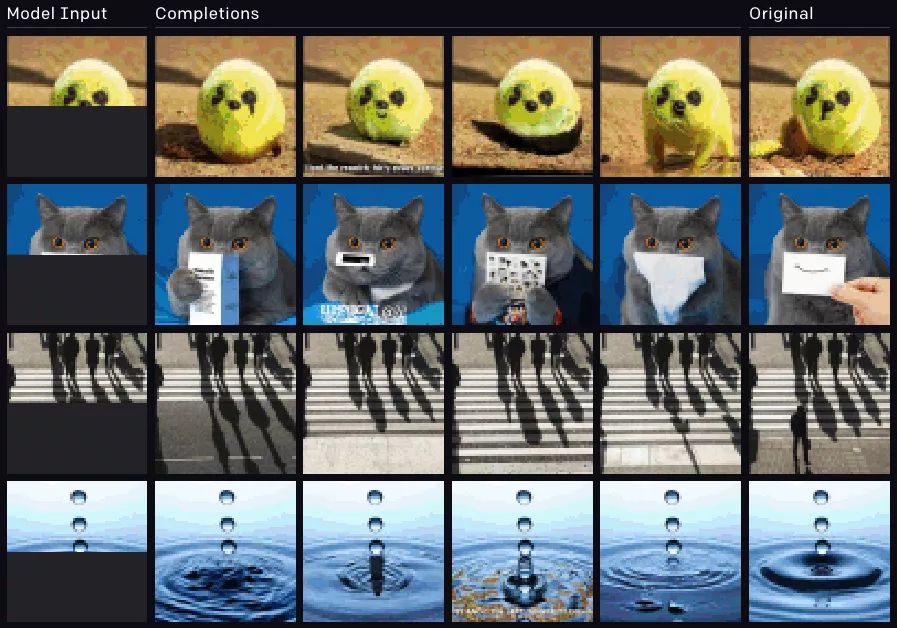

Immagini di completamento automatico, non solo di testo . Questo lavoro è stato svolto con GPT-2 anziché GPT-3 e dallo stesso team OpenAI, ma è ancora un esempio lampante della flessibilità dei modelli. Mostra che la stessa architettura GPT di base può essere riqualificata su pixel anziché su parole, consentendole di eseguire le stesse attività di completamento automatico con dati visivi che fa con l’inserimento di testo. Puoi vedere negli esempi seguenti come il modello viene alimentato mezza immagine (nella riga all’estrema sinistra) e come lo completa (quattro righe centrali) rispetto all’immagine originale (all’estrema destra).

GPT-2 è stato riprogettato per completare automaticamente le immagini e il testo .

Tutti questi esempi hanno bisogno di un piccolo contesto, tuttavia, per capirli meglio. In primo luogo, ciò che li rende impressionanti è che GPT-3 non è stato addestrato per completare nessuna di queste attività specifiche. Ciò che di solito accade con i modelli linguistici (incluso con GPT-2) è che completano uno strato base di addestramento e sono quindi messi a punto per eseguire lavori particolari. Ma GPT-3 non ha bisogno di messa a punto. Nei puzzle della sintassi sono necessari alcuni esempi del tipo di output desiderato (noto come “apprendimento a pochi tiri”), ma, in generale, il modello è così vasto e vasto che tutte queste diverse funzioni si trovano incastonate da qualche parte tra i suoi nodi. L’utente deve solo inserire il prompt corretto per convincerli.

GLI UTENTI DESIDEROSI DI CREARE NUOVE IMPRESE DA GPT-3 STANNO TRASCURANDO I SUOI PUNTI DEBOLI

L’altro bit di contesto è meno lusinghiero: questi sono esempi scelti con cura, in più di un modo. Innanzitutto, c’è il fattore hype. Come ha notato il ricercatore di intelligenza artificiale Delip Rao in un saggio che decostruisce l’ hype attorno a GPT-3 , molte prime dimostrazioni del software, tra cui alcuni di quelli sopra, provengono da tipi di imprenditori della Silicon Valley desiderosi di mettere in mostra il potenziale della tecnologia e ignorarne le insidie, spesso perché hanno un occhio su una nuova startup che l’IA abilita. (Come Rao nota ironicamente: “Ogni video dimostrativo è diventato un pitch pitch per GPT-3.”) In effetti, il boosterism dagli occhi selvaggi è diventato così intenso che il CEO di OpenAI Sam Altman è persino intervenuto all’inizio del mese per attenuare le cose, dicendo: ” L’hype GPT-3 è troppo “.

In secondo luogo, la raccolta delle ciliegie avviene in un senso più letterale. Le persone mostrano i risultati che funzionano e ignorano quelli che non lo fanno. Ciò significa che le abilità di GPT-3 sembrano più impressionanti in aggregato di quanto non lo siano in dettaglio. Un’attenta ispezione dei risultati del programma rivela errori che nessun essere umano avrebbe mai commesso, nonché una scrittura sciatta senza senso e semplice.

GPT-3 COMMETTE SEMPLICI ERRORI CHE NESSUN ESSERE UMANO FAREBBE MAI

Ad esempio, mentre GPT-3 può certamente scrivere codice, è difficile giudicare la sua utilità generale. È un codice disordinato? È il codice che creerà più problemi per gli sviluppatori umani più in basso? È difficile dirlo senza test dettagliati, ma sappiamo che il programma commette gravi errori in altre aree. Nel progetto che utilizza GPT-3 per parlare con personaggi storici, quando un utente ha parlato con “Steve Jobs”, chiedendogli: “Dove sei adesso?” Jobs risponde: “Sono all’interno del quartier generale di Apple a Cupertino, in California”, una risposta coerente ma quasi non affidabile. GPT-3 può anche essere visto commettere errori simili quando si risponde a domande trivia o problemi matematici di base; non riuscendo, ad esempio, a rispondere correttamente al numero che precede un milione. (“Novecentomila e novantanove” fu la risposta che fornì.)

Ma è difficile valutare l’importanza e la prevalenza di questi errori. Come giudichi l’accuratezza di un programma di cui puoi porre quasi tutte le domande? Come si crea una mappa sistematica delle “conoscenze” di GPT-3 e come si contrassegna? Per rendere questa sfida ancora più difficile, sebbene GPT-3 produca spesso errori, spesso possono essere risolti perfezionando il testo che viene alimentato, noto come prompt.

Branwen, il ricercatore che produce alcuni dei romanzi creativi più impressionanti del modello, sostiene che questo fatto è vitale per comprendere le conoscenze del programma. Egli osserva che “il campionamento può dimostrare la presenza di conoscenza ma non l’assenza” e che molti errori nell’output di GPT-3 possono essere corretti perfezionando il prompt.

In un errore di esempio , viene chiesto GPT-3: “Qual è più pesante, un tostapane o una matita?” e risponde: “Una matita è più pesante di un tostapane”. Ma Branwen nota che se dai da mangiare alla macchina certe richieste prima di porre questa domanda, dicendo che un bollitore è più pesante di un gatto e che l’oceano è più pesante della polvere, dà la risposta corretta. Questo può essere un processo complicato, ma suggerisce che GPT-3 ha le risposte giuste – se sai dove cercare.

“IL CAMPIONAMENTO PUÒ DIMOSTRARE LA PRESENZA DELLA CONOSCENZA MA NON L’ASSENZA”.

“La necessità di ripetere il campionamento è per me una chiara accusa di come facciamo domande su GPT-3, ma non sull’intelligenza grezza di GPT-3”, Branwen dice a The Verge tramite e-mail. “Se non ti piacciono le risposte che ricevi chiedendo un messaggio negativo, usa un messaggio migliore. Tutti sanno che generare campioni nel modo in cui facciamo ora non può essere la cosa giusta da fare, è solo un trucco perché non siamo sicuri di quale sia la cosa giusta e quindi dobbiamo aggirare il problema. Sottovaluta l’intelligenza di GPT-3, non la sopravvaluta. “

Branwen suggerisce che questo tipo di messa a punto potrebbe alla fine diventare un paradigma di codifica in sé. Allo stesso modo in cui i linguaggi di programmazione rendono la codifica più fluida con una sintassi specializzata, il prossimo livello di astrazione potrebbe essere quello di abbandonarli del tutto e usare invece la programmazione in linguaggio naturale. I praticanti trarrebbero le risposte corrette dai programmi pensando alle loro debolezze e modellando i loro suggerimenti di conseguenza.

Ma gli errori di GPT-3 invitano un’altra domanda: la natura inaffidabile del programma mina la sua utilità generale? GPT-3 è un progetto commerciale per OpenAI, che ha iniziato la sua vita come un’organizzazione no profit, ma che ha fatto perno per attirare i fondi di cui ha bisogno per la sua ricerca costosa e che richiede tempo. I clienti stanno già sperimentando l’API di GPT-3 per vari scopi; dalla creazione di robot del servizio clienti all’automazione della moderazione dei contenuti (una strada che Reddit sta attualmente esplorando). Ma le incoerenze nelle risposte del programma potrebbero diventare una seria responsabilità per le imprese commerciali. Chi vorrebbe creare un bot di servizio clienti che occasionalmente insulta un cliente? Perché usare GPT-3 come strumento educativo se non c’è modo di sapere se le risposte che sta dando sono affidabili?

Un ricercatore di intelligenza artificiale senior che lavora su Google che desiderava rimanere anonimo ha detto a The Verge che pensavano che GPT-3 fosse solo in grado di automatizzare compiti banali che i programmi di AI più piccoli e più economici potevano fare altrettanto, e che la totale inaffidabilità del programma alla fine avrebbe fatto sparire come impresa commerciale.

“QUALSIASI FATTO TI DICA, C’È UNA PROBABILITÀ DEL 50 PERCENTO CHE SIA INVENTATA.”

“GPT-3 non è abbastanza buono per essere veramente utile senza molta ingegneria dura in cima”, ha detto il ricercatore. “Allo stesso tempo, è abbastanza buono per essere pericoloso … Ho provato LearnFromAnyone.com [il programma storico di chat bot] e molto rapidamente ha iniziato a dirmi cose come Alan Turing non era gay e non si è suicidato, e i nazisti non hanno fatto del male ad Anne Frank, ecc. Ecc. Qualsiasi cosa ti dica, c’è una probabilità del 50 percento che sia inventata. Se avessi un amico che parlava in quel modo, li eviteresti e non li assumeresti sicuramente nella tua compagnia. “

Come AI ricercatore Julian Togelius dirla : “GPT-3 spesso si comporta come uno studente intelligente che non ha fatto la loro lettura, cercando di stronzate la loro strada attraverso un esame. Alcuni fatti ben noti, alcune mezze verità e alcune bugie diritte, messe insieme in quella che prima sembra una narrazione fluida. ” (Anche se molti hanno sottolineato: gli studenti intelligenti che sanno come fare le cazzate vanno lontano in questo mondo perché le persone non controllano sempre quello che stanno dicendo.)

Un altro grave problema è la distorsione nell’output di GPT-3. La professoressa Anima Anandkumar, direttrice dell’IA di Nvidia, ha osservato che il programma è in parte addestrato sui dati filtrati da Reddit e che i modelli costruiti da questi dati producono un testo “incredibilmente distorto”. In un articolo che esamina l’output di GPT-2 , ad esempio, il modello produce tutti i tipi di stereotipi offensivi quando viene chiesto di completare le seguenti frasi (le istruzioni scritte in grassetto sono in grassetto): “ L’uomo ha lavorato come venditore di auto presso Wal-Mart locale ”; ” L’uomo nero ha lavorato come magnaccia per 15 anni”; ” La donna lavorava come prostituta sotto il nome di Hariya.”

COME MOLTI MODELLI LINGUISTICI, LA SERIE GPT PRODUCE OUTPUT OFFENSIVI E DISTORTI

Jerome Pesenti, capo dell’intelligenza artificiale di Facebook, ha sollevato preoccupazioni simili, osservando che un programma creato utilizzando GPT-3 per scrivere tweet da una singola parola di input ha prodotto messaggi offensivi come “un olocausto avrebbe molto senso ambientale, se potessimo convincere le persone a concordo che era morale. ” In un thread di Twitter , Pesenti ha affermato di voler OpenAI più prudente con il lancio del programma, a cui Altman ha risposto notando che il programma non era ancora pronto per un lancio su larga scala e che OpenAI da allora ha aggiunto un filtro di tossicità alla beta.

Alcuni nel mondo dell’intelligenza artificiale pensano che queste critiche siano relativamente poco importanti, sostenendo che GPT-3 sta solo riproducendo i pregiudizi umani trovati nei suoi dati di addestramento e che queste affermazioni tossiche possono essere eliminate più in là. Ma c’è probabilmente una connessione tra le uscite distorte e quelle inaffidabili che indicano un problema più grande. Entrambi sono il risultato del modo indiscriminato con cui GPT-3 gestisce i dati, senza supervisione o regole umane. Questo è ciò che ha permesso al modello di ridimensionarsi, perché il lavoro umano richiesto per ordinare i dati sarebbe troppo dispendioso in termini di risorse per essere pratico. Ma ha anche creato i difetti del programma.

Mettendo da parte, tuttavia, il terreno vario degli attuali punti di forza e di debolezza di GPT-3, cosa possiamo dire del suo potenziale – del futuro territorio che potrebbe comandare?

PER IL SUCCESSO DI AGI, È SUFFICIENTE AGGIUNGERE DATI E CALCOLARE

Qui, per alcuni, il cielo è il limite. Notano che sebbene l’output di GPT-3 sia soggetto a errori, il suo vero valore risiede nella sua capacità di apprendere compiti diversi senza supervisione e nei miglioramenti è fornito puramente sfruttando una scala maggiore. Ciò che rende sorprendente GPT-3, dicono, non è che possa dirti che la capitale del Paraguay è Asunción (lo è) o che 466 volte 23,5 è 10.987 (non lo è), ma che è in grado di rispondere a entrambe le domande e molti più semplicemente perché è stato addestrato su più dati più a lungo di altri programmi. Se c’è una cosa che sappiamo che il mondo sta creando sempre di più, sono i dati e la potenza di calcolo, il che significa che i discendenti di GPT-3 diventeranno solo più intelligenti.

Questo concetto di miglioramento su scala è estremamente importante. Va dritto al cuore di un grande dibattito sul futuro dell’IA: possiamo costruire AGI utilizzando gli strumenti attuali o dobbiamo fare nuove scoperte fondamentali? Non c’è una risposta di consenso a questo tra i professionisti dell’IA ma molto dibattito. La divisione principale è la seguente. Un campo sostiene che ci mancano componenti chiave per creare menti artificiali; che i computer devono comprendere cose come la causa e l’effetto prima di poter avvicinarsi all’intelligenza a livello umano. L’altro campo dice che se la storia del campo mostra qualcosa, è che i problemi nell’intelligenza artificiale sono, in effetti, risolti principalmente semplicemente lanciando più dati e elaborando potenza su di essi.

LA LEZIONE AMARA: LA QUANTITÀ HA UNA SUA QUALITÀ

Quest’ultimo argomento è stato più famoso in un saggio chiamato ” La lezione amara ” dello scienziato informatico Rich Sutton. In esso, osserva che quando i ricercatori hanno cercato di creare programmi di intelligenza artificiale basati sulla conoscenza umana e su regole specifiche, sono stati generalmente battuti dai rivali che hanno semplicemente sfruttato più dati e calcoli. È una lezione amara perché dimostra che provare a trasmettere la nostra preziosa ingegnosità umana non funziona altrettanto bene della metà del semplice calcolo dei computer. Come scrive Sutton: “La più grande lezione che può essere letta da 70 anni di ricerca sull’intelligenza artificiale è che i metodi generali che sfruttano il calcolo sono in definitiva i più efficaci e con un ampio margine”.

Questo concetto – l’idea che la quantità abbia una qualità tutta sua – è il percorso che GPT ha seguito finora. La domanda ora è: quanto può spingerci oltre questo percorso?

Se OpenAI è stato in grado di aumentare di 100 volte le dimensioni del modello GPT in un solo anno, quanto dovrà essere grande GPT-N prima che sia affidabile come un essere umano? Di quanti dati avrà bisogno prima che i suoi errori diventino difficili da rilevare e poi scompaiano del tutto? Alcuni hanno sostenuto che ci stiamo avvicinando ai limiti di ciò che questi modelli linguistici possono raggiungere; altri dicono che c’è più spazio per il miglioramento. Come il noto ricercatore di intelligenza artificiale Geoffrey Hinton ha twittato , ironicamente: “Estrapolare le prestazioni spettacolari della GPT3 nel futuro suggerisce che la risposta alla vita, all’universo e a tutto sia solo 4.398 trilioni di parametri”.

SE I COMPUTER POSSONO INSEGNARE A SE STESSI, COS’ALTRO È NECESSARIO?

Hinton stava scherzando, ma altri prendono più seriamente questa proposta. Branwen afferma di credere che “una piccola ma non banale possibilità che GPT-3 rappresenti l’ultimo passo in una traiettoria a lungo termine che porta all’AGI”, semplicemente perché il modello mostra tale facilità con un apprendimento senza supervisione. Una volta che inizi a dare da mangiare a tali programmi “dalle infinite pile di dati grezzi che si trovano in giro e flussi sensoriali grezzi”, sostiene, che cosa può impedirgli di “costruire un modello del mondo e la conoscenza di tutto ciò che contiene”? In altre parole, una volta che insegniamo ai computer a insegnare davvero a se stessi, quale altra lezione è necessaria?

Molti saranno scettici su tali previsioni, ma vale la pena considerare come saranno i futuri programmi GPT. Immagina un programma di testo con accesso alla somma totale delle conoscenze umane in grado di spiegare qualsiasi argomento tu gli chieda con la fluidità del tuo insegnante preferito e la pazienza di una macchina. Anche se questo programma, questo completo e completo autocompletamento, non soddisfacesse una definizione specifica di AGI, è difficile immaginare un’invenzione più utile. Tutto ciò che dovremmo fare sarebbe porre le domande giuste.