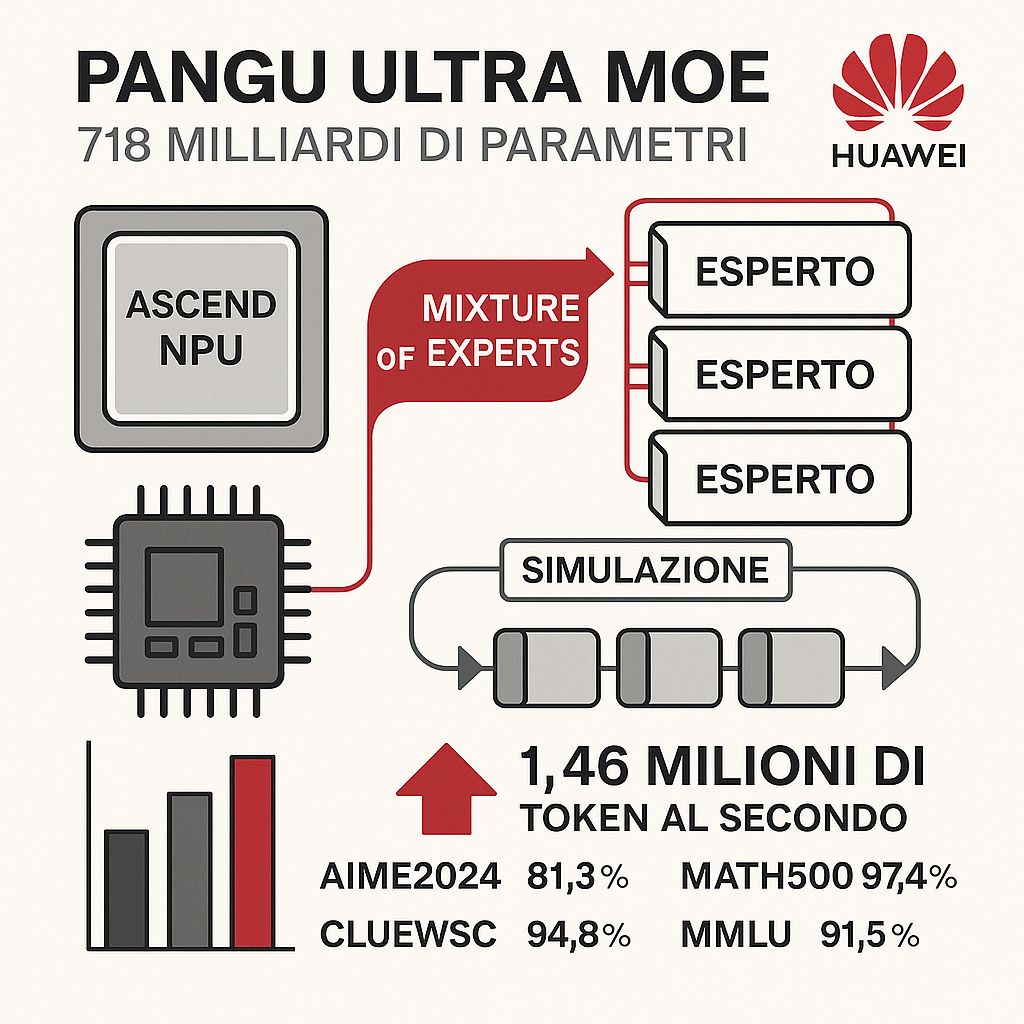

Huawei ha recentemente introdotto Pangu Ultra MoE, un modello linguistico di grandi dimensioni (LLM) con 718 miliardi di parametri, progettato per sfruttare al massimo i suoi chip Ascend NPU. Questo modello utilizza un’architettura sparsa basata sulla tecnica Mixture of Experts (MoE), che consente di attivare solo una parte dei parametri per ogni input, migliorando l’efficienza computazionale.

Per ottimizzare le prestazioni, il team di Huawei ha adottato un approccio innovativo basato su simulazioni. Hanno esplorato migliaia di configurazioni architetturali, considerando variabili come il numero di esperti, la dimensione degli stati nascosti e il numero di livelli, utilizzando cinque strategie di parallelismo: pipeline, tensore, esperti, dati e contesto. Questa metodologia ha permesso di identificare la configurazione ottimale per l’hardware Ascend, evitando costosi esperimenti pratici.

Il modello finale di Pangu Ultra MoE è stato addestrato su un cluster di 6.000 Ascend NPU, raggiungendo un utilizzo del flops (MFU) del 30,0% e una velocità di elaborazione di 1,46 milioni di token al secondo, paragonabile a modelli di punta come DeepSeek-R1. Inoltre, ha ottenuto risultati di rilievo in vari benchmark, tra cui un’accuratezza dell’81,3% in AIME2024, del 97,4% in MATH500, del 94,8% in CLUEWSC e del 91,5% in MMLU. Nel settore medico, ha superato DeepSeek-R1 con punteggi dell’87,1% in MedQA e dell’80,8% in MedMCQA.

Questa realizzazione sottolinea la capacità di Huawei di sviluppare modelli AI avanzati ottimizzati per la propria infrastruttura hardware, riducendo la dipendenza da tecnologie esterne come quelle di Nvidia.