2019: A Cambrian Explosion In Deep Learning, Parte 1

Approfondimenti e strategia

Ho iniziato a scrivere un singolo blog sui chip IA previsti per l’anno in arrivo, e come NVIDIA NVDA + 5,73%potrebbe rispondere alle sfide, ma ho subito capito che sarebbe stato molto più lungo del previsto. Dato che c’è così tanto da coprire, ho deciso di strutturare questo come tre articoli che si spera siano più consumabili. Ho incluso collegamenti a missive precedenti per coloro che vogliono scavare un po ‘più a fondo.

Parte 1: Introduzione e grandi giocatori che tentano di attaccare NVIDIA:

Parte 2: Startups e China Inc. e i ruoli che ciascuno può svolgere

Parte 3: Potenziali strategie NVIDIA per respingere i potenziali sfidanti

introduzione

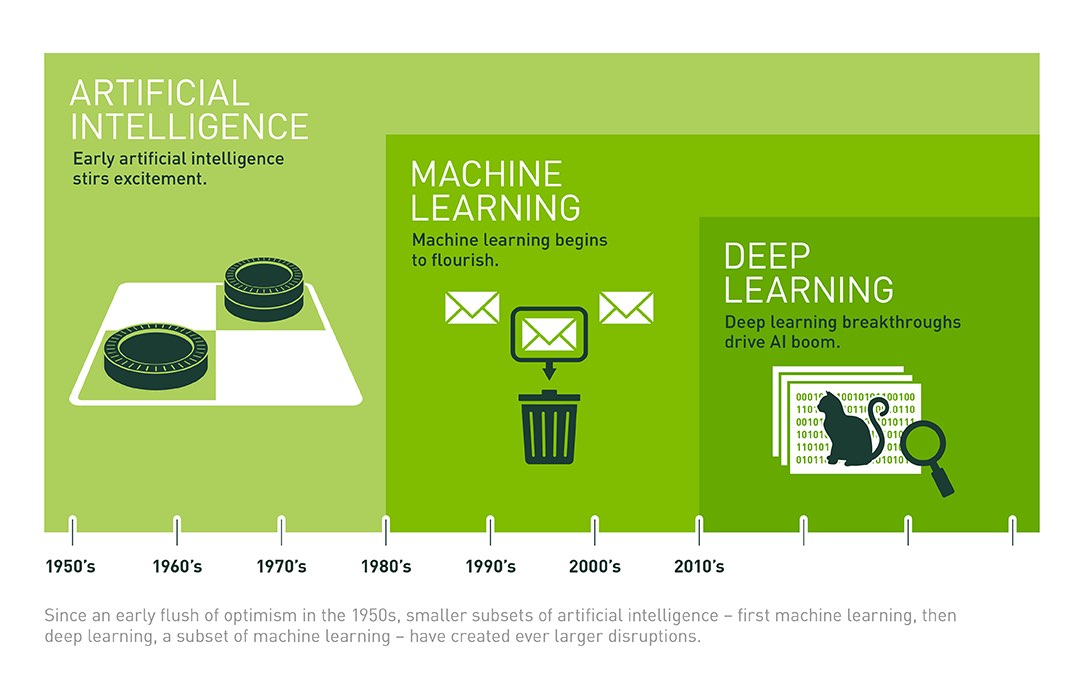

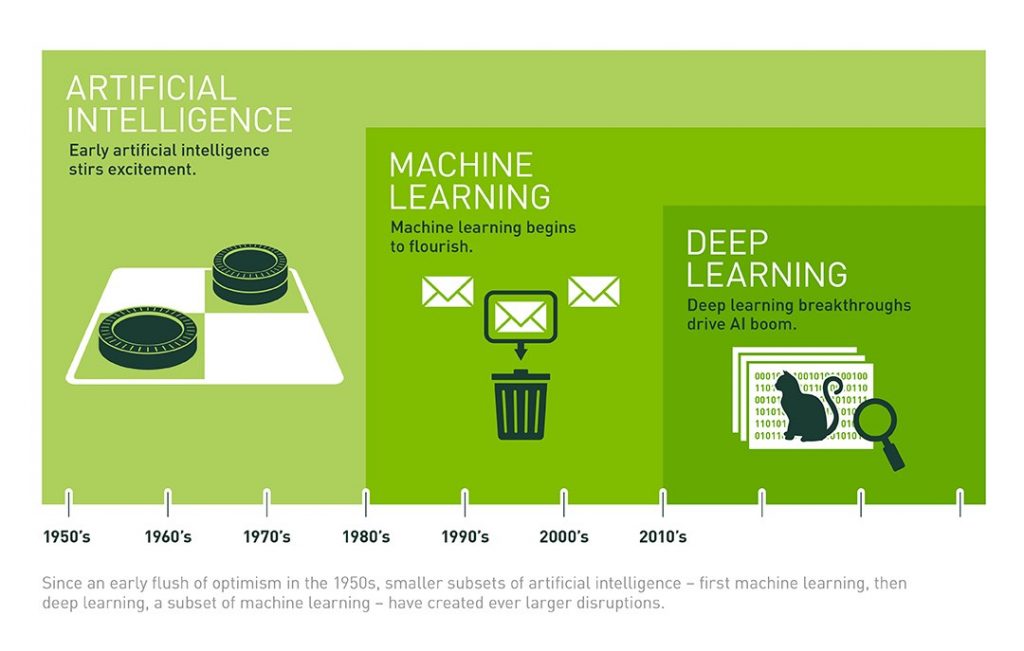

Negli ultimi cinque anni, NVIDIA ha accresciuto il proprio business dei data center in una potenza da mille miliardi di dollari senza dover affrontare un singolo concorrente credibile. Questo è un fatto incredibile, che non ha eguali nel mondo della tecnologia di oggi, per il mio ricordo. La maggior parte di questa crescita meteorica è stata guidata dalla richiesta di chip GPU veloci per Artificial Intelligence (AI) e High-Performance Computing (HPC). Il CEO di NVIDIA, Jensen Huang, ama parlare del “Cambrian Explosion” in deep learning, riferendosi specificamente al ritmo rapido dell’innovazione negli algoritmi di rete neurale. Toccheremo ciò che questo significa per NVIDIA nella parte 3, ma ho scelto di prendere in prestito il concetto per il titolo di questa serie. Siamo alla soglia di un’esplosione nel silicio specializzato in intelligenza artificiale, da molte grandi e piccole aziende in tutto il mondo. Tre anni fa, era quasi impossibile ottenere finanziamenti di rischio per una startup di silicio. Ora, ci sono dozzine di sfidanti ben finanziati che costruiscono chip per l’IA.

ha raggiunto l’apice del computing con l’annuncio che stavano alimentando il super computer più veloce del mondo , ORNL’s Summit (che deve il 95% delle sue prestazioni alle GPU Volta di NVIDIA). Mentre questo è un risultato incredibile, molti stanno cominciando a chiedersi se questa intera fiaba possa durare per NVIDIA.

Nell’ultimo trimestre riportato, i ricavi del data center di NVIDIA sono cresciuti del 58% rispetto all’anno precedente a $ 792 milioni, quasi il 25% dei ricavi totali dell’azienda. Questo ammonta a un totale di $ 2,86 miliardi negli ultimi 4 trimestri. Se la società è in grado di sostenere questa crescita, nel 2019 potrebbe generare circa $ 4,5 miliardi di entrate nel data center. Sembra il paradiso, o almeno il paradiso in terra, giusto?

L’ARTICOLO CONTINUA DOPO LA PUBBLICITÀ

Senza dubbio, NVIDIA crea grandi prodotti guidati dalla sua potente visione di un’architettura estensibile. NVIDIA ora gode di un ecosistema robusto e autosufficiente di software, università, startup e partner che gli hanno permesso di diventare il padrone del proprio universo appena creato. Mentre alcuni sostengono che questo ecosistema crea un fossato difensivo impenetrabile, le nuvole temporalesche stanno comparendo all’orizzonte. Le potenziali minacce provengono da Intel, Google, AMD e decine di startup statunitensi e cinesi, tutte attirate dalla frenesia alimentare dell’IA.

Finora, a mio parere, la competizione è stata per lo più fumo con pochissimo fuoco. Dozzine di annunci sono stati fatti dai concorrenti, ma sono abbastanza fiducioso che nessuno di loro abbia effettivamente ricavato alcun profitto dalle casse di NVIDIA, al di fuori di Google. Diamo un’occhiata al panorama competitivo attuale, guardando a cosa si preannuncia essere un 2019 molto interessante.

I grandi sfidanti

Mentre il New York Times contava più di 40 startup che entravano in questo spazio, siamo realistici: c’è solo spazio per una manciata di aziende per avere un vero successo in questo mercato (ad esempio ricavi superiori a $ 1B). Per la formazione di reti neurali profonde (DNN), NVIDIA sarà molto difficile da battere, data la forza dei suoi prodotti, la sua base installata e il suo ecosistema pervasivo. Tuttavia, il mercato dell’inferenza, che al momento è piuttosto ridotto, supererà il mercato della formazione in termini di entrate totali. A differenza della formazione, l’inferenza non è un mercato monolitico. È composto da una miriade di tipi di dati e algoritmi di deep learning ottimizzati associati nel cloud e al limite, ciascuno con requisiti specifici di prestazioni, potenza e latenza. Inoltre, non c’è un gorilla incumbent da 800 libbre in inferenza, nemmeno nel mercato automobilistico dove NVIDIA ha rivendicato la leadership. Per questi motivi, l’inferenza è dove la maggior parte dei nuovi partecipanti si concentrerà inizialmente o inizialmente. Diamo un’occhiata ai grandi giocatori che gareggiano per un posto al tavolo.

Una delle prime aziende a dimostrare che un chip specializzato (noto come ASIC o Circuito integrato specifico per applicazioni) può contrastare la GPU più profonda e programmabile (non posso credere di averlo appena detto!) Per Deep Learning era Google -Chi, per coincidenza, è probabilmente uno dei più grandi clienti di NVIDIA. Come ho già copertoGoogle ha ora rilasciato quattro “Tensor Processing Units” (TPU) -chips e schede che accelerano il training di deep learning e l’elaborazione delle inferenze nel cloud e, più recentemente, al limite. Le prestazioni di un TPU di Google per la formazione e l’elaborazione di un DNN sono piuttosto solide, offrendo fino a 45 trilioni di operazioni al secondo o TOPS per chip. Questo è paragonabile al Volta di NVIDIA, che ha un picco a 125 TOP. Il primo paio di TPU erano davvero per uso interno e diritti di vanteria, ma Google li rende ora disponibili come servizio per i propri clienti cloud su Google Compute Cloud.

Mentre i TPU hanno sicuramente dato un calcio al passo dell’IA di Google, il mercato che servono al di fuori dei casi di utilizzo interni di Google (che, è scontato, è un mercato abbastanza ampio) è intenzionalmente limitato. Le TPU possono essere utilizzate solo per la formazione e l’esecuzione del framework TensorFlow AI di Google; non puoi usarli per allenare o eseguire AI costruiti con Apache MxNet o PyTorch, il framework IA in rapida crescita supportato da FB Facebook + 0,98% e Microsoft MSFT -0,48%. Né puoi usarli per applicazioni HPC non AI, in cui le GPU regnano sovrane. Inoltre, non è possibile acquistare TPU per l’elaborazione locale in data center o server aziendali o governativi. Ma Google è ok con tutto ciò, dal momento che considera TPU e TensorFlow strategici per la sua leadership AI su tutti i fronti. Il software ottimizzato per il suo hardware ottimizzato per il suo software può creare una piattaforma potente e duratura.

L’impatto più immediato del TPU potrebbe essere quello di convalidare il concetto ASIC come alternativa a una GPU, almeno per i potenziali investitori. Il CEO di una startup di Deep Learning ha condiviso con me che il venture capital ha iniziato a fluire liberamente una volta che Google ha annunciato il suo TPU. In seguito ha raccolto centinaia di milioni di dollari.

Google è stato abile nel rubare un po ‘di ribalta agli annunci prevedibili di NVIDIA alla GPU Technology Conference (di solito a marzo) e non sarei sorpreso di vedere la compagnia ancora quest’anno, forse con un prodotto TPU da 7nm con impressionanti numeri di prestazioni.

Non essere da meno, Servizi Web Amazon – + 0%ha annunciato lo scorso autunno che anche lui stava costruendo un ASIC personalizzato per l’elaborazione dell’inferenza. Tuttavia, il chip è ancora in fase di sviluppo e la società non ha condiviso alcun dettaglio sul design o sulla disponibilità.

Questo diventa un po ‘più complicato dal momento che Intel è un giocatore così grande e ha almeno un ferro in ogni fuoco. Mentre la compagnia intende competere per la formazione e l’inferenza con i chip Nervana nel “2019”, si rende conto che l’inferenza diventerà un mercato più ampio e avrà una mano molto forte da giocare. Oltre alle CPU Xeon (che sono state recentemente aggiornate con prestazioni di inferenza significativamente migliorate), la società ha acquisito MobileEye e Movidius, rispettivamente per il settore automobilistico e l’elaborazione dell’inferenza incorporata. Ho visto demo di entrambi i dispositivi e sono davvero impressionanti. Intel ha anche investito in uno stack software run-anywhere, chiamato OpenVino , che consente agli sviluppatori di allenarsi ovunque e quindi di ottimizzare ed eseguire su qualsiasi processore Intel. Inteligente.

In una rivelazione al CES di Las Vegas, Intel ha rivelato che sta lavorando a stretto contatto con Facebook sulla versione di inferenza del Nervana Neural Network Processor (NNP-I) – sorprendente perché molti avevano predetto che Facebook stava lavorando sul proprio acceleratore di inferenza. Nel frattempo, Naveen Rao, VP di Intel e GM dei prodotti di intelligenza artificiale, ha condiviso Twitter TWTR + 2,07%che l’NNP-I sarà un SOC (System-On-a-Chip), costruito nel 10nm Fab di Intel e includerà i core x86 di IceLake. Rao ha indicato che questo sarebbe un tema comune in futuro per Intel, forse un riferimento alle future X86 / GPU per chip desktop e laptop simili alle APU di AMD.

Per la formazione, il piano originale di Intel era quello di annunciare una “Nervatura al lago” Nervana NNP nel 2017, un anno dopo l’acquisizione di Nervana. Poi è scivolato fino al 2018, e poi, beh, la compagnia ha deciso di ricominciare. Questo probabilmente non perché la prima parte di Nervana non era buona; piuttosto, la società ha realizzato che il dispositivo non era abbastanza buono da superare sostanzialmente NVIDIA e i TensorCores aggiunti a Volta e alle successive GPU. Vedremo questo film suonare di nuovo, sospetto, quando NVIDIA svelerà le sorprese che sta preparando per la sua parte da 7nm, ma mi sto anticipando.

Qualcomm e Apple

Includo queste due società per completezza, poiché entrambe offrono incredibili funzionalità di IA focalizzate su dispositivi mobili (e, nel caso di Qualcomm, dispositivi IOT e veicoli autonomi). Apple, ovviamente, si concentra sulle CPU della serie A per iPhone e sul supporto del sistema operativo IOS per l’IA in-phone. Man mano che il mobile diventa una piattaforma dominante per l’inferenza di intelligenza artificiale nell’elaborazione della voce e dell’immagine, questi due giocatori hanno un sacco di IP che possono usare per stabilire la leadership (sebbene Huawei sta anche spingendo molto sull’IA, come vedremo nella Parte 2).

Negli ultimi tre anni, AMD ha lavorato duramente per far funzionare la sua software house per l’intelligenza artificiale. Quando ho lavorato lì nel 2015, non potevi nemmeno eseguire le sue GPU su un server Linux senza avviare Windows. La società ha fatto molta strada da allora, con il software ROCm e i compilatori per semplificare la migrazione da CUDA e MlOpen (da non confondere con OpenML) per accelerare le librerie matematiche sui suoi chip. Attualmente, tuttavia, le GPU di AMD rimangono almeno una generazione di NVIDIA V100 per AI e la V100 si avvicina ai due anni. Resta da vedere quanto AMD possa competere con NVIDIA TensorCores su 7nm. AMD potrebbe decidere di concentrarsi maggiormente sul mercato delle inferenze più ampio, magari con una piattaforma di silicio semi-personalizzata per veicoli autonomi, simile a NVIDIA Xavier SOC . Il tempo lo dirà.

Non fare errori, Xilinx XLNX + 18,45%, il principale fornitore di dispositivi a logica programmabile (FPGA), ha avuto un fantastico 2018. Oltre ad annunciare la sua architettura di prossima generazione per 7nm, ha ottenuto importanti successi di progettazione in Microsoft , Baidu BIDU -0,22%, Amazon, Alibaba , Daimler Benz , e altri. Nell’elaborazione dell’inferenza IA, gli FPGA hanno un netto vantaggio rispetto agli ASIC perché possono essere riconfigurati al volo per un lavoro specifico a portata di mano. Questo è molto importante quando la tecnologia di base sta cambiando rapidamente, come nel caso dell’IA. Microsoft, ad esempio, ha mostrato come i suoi FPGA ( ora da Xilinx e Intel ) possono utilizzare matematica a 1 bit, a 3 bit o praticamente qualsiasi precisione per strati specifici in una rete neurale profonda. Questo può anche sembrare un nerd da nerd, ma questo può velocizzare enormemente l’elaborazione e ridurre le latenze, tutto usando molta meno energia. Inoltre, l’imminente chip 7nm di Xilinx, chiamato Versal, ha motori AI e DSP per accelerare l’elaborazione specifica dell’applicazione insieme agli array di logica adattabili. Versal quest’anno inizierà la spedizione, e penso che potrebbe essere un punto di svolta per l’elaborazione dell’inferenza.

Nel secondo blog di questa serie in tre parti, esplorerò alcune delle startup in occidente e in Cina che si stanno allineando per giocare un ruolo importante nel mondo dell’hardware di intelligenza artificiale. Grazie per aver letto e rimanete sintonizzati!