In che modo l’intelligenza artificiale complica la gestione del rischio aziendale

Nonostante i vantaggi che l’intelligenza artificiale ha già portato all’impresa, c’è ancora molta tensione sul suo potenziale di conseguenze indesiderate. Mentre i titoli tendono a concentrarsi sull’intelligenza artificiale che impazzisce e distrugge tutta l’umanità, la realtà pratica è che le attuali generazioni di intelligenza artificiale hanno maggiori probabilità di provocare il caos sui processi aziendali – e sui profitti – se non gestite correttamente.

Ma come si può controllare qualcosa che, per sua natura, dovrebbe agire in modo autonomo? E così facendo, l’azienda non ostacolerà proprio ciò che rende l’intelligenza artificiale una risorsa così preziosa sul posto di lavoro?

L’intelligenza artificiale è andata storta

Il CEO di OnCorps, Bob Suh, offre una buona panoramica dei danni che l’intelligenza artificiale può causare, anche se impiegata con le migliori intenzioni. Le esperienze delle piattaforme di social media illustrano come algoritmi mal progettati possono produrre un insieme di risultati positivi (più condivisione) e allo stesso tempo promulgare risultati negativi (disinformazione e manipolazione). È giusto dire che i dirigenti di Facebook e Twitter non intendevano che le loro piattaforme fomentassero conflitti e animosità in tutta la società, ma hanno concentrato i loro sforzi sulla massimizzazione dei profitti, quindi è ciò che hanno fatto i loro agenti di apprendimento per rinforzo (RLA).

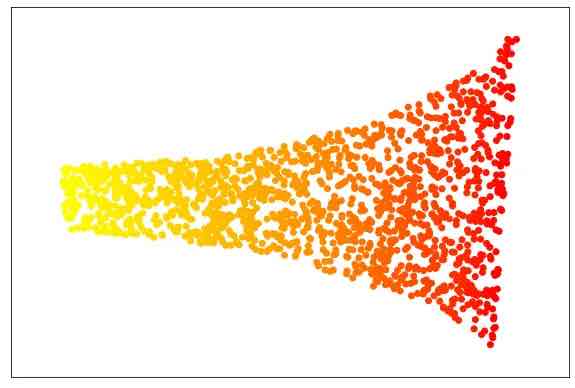

Gli RLA si basano su semplici funzioni di ricompensa in cui i risultati positivi spingono l’agente ad espandere e perfezionare le sue azioni. Senza un meccanismo di ricompensa compensativa, l’agente continuerà a migliorare in ciò che fa anche se non produce più un risultato desiderabile. In questo modo, i bot dei social media hanno avuto molto successo nel raggiungere i loro obiettivi programmati anche se venivano manipolati da alcuni nella comunità degli utenti per armare l’opinione pubblica e seminare discordia tra la popolazione.

Questi stessi problemi possono emergere nelle vendite, nel marketing e in altre funzioni. E sfortunatamente, poche organizzazioni sono attrezzate per identificare e correggere gli algoritmi che stanno portando a risultati indesiderati fino a quando il danno non viene fatto. Questo può assumere la forma di tutto, dalla perdita di entrate e opportunità di mercato perse, a violazioni della sicurezza e danni alle strutture e ai processi interni.

Fondamentalmente, implementare i controlli adeguati sull’IA è una forma di gestione del rischio . A causa della sua natura autonoma, tuttavia, l’IA richiede un po’ più di attenzione rispetto all’IT standard, affermano i partner di McKinsey Juan Aristi Baquero, Roger Burkhardt, Arvind Govindarajan e Thomas Wallace . Per prima cosa, l’intelligenza artificiale introduce una serie di rischi sconosciuti in più discipline, tra cui conformità, operazioni, legali e normative. Le banche, ad esempio, si preoccupano da tempo dei pregiudizi dei loro dipendenti umani, ma se quei dipendenti iniziano a formulare raccomandazioni basate su ciò che un’IA distorta dice loro, ora l’istituzione ha sistematizzato tale pregiudizio nel suo processo decisionale.

Un altro problema è il modo in cui l’intelligenza artificiale si sta rapidamente decentralizzando in tutta l’azienda, il che rende difficile il monitoraggio e il monitoraggio. E poiché le varie implementazioni di intelligenza artificiale di più fornitori, partner e altre entità iniziano a comunicare tra loro, aumenta il potenziale per introdurre nuovi rischi. Un nuovo strumento all’interno della piattaforma CRM di un fornitore, ad esempio, potrebbe creare rischi per la privacy e la conformità dei dati in più aree geografiche.

Gestione anticipata

Il modo migliore per gestire questi rischi è implementare i controlli adeguati prima che l’intelligenza artificiale si integri nel tessuto dell’impresa, secondo Todd Bialick, responsabile della sicurezza digitale e della trasparenza presso PwC . Per fare ciò, dovrai condurre una revisione completa di tutto ciò che l’IA tocca mentre cerca di adempiere al suo mandato. Ciò include politiche a livello di dati che regolano l’input e la selezione dei set, la supervisione e la trasparenza nello sviluppo di algoritmi e modelli, la revisione continua dell’output e delle decisioni e il pieno controllo sulla sicurezza logica, le operazioni di calcolo e lo sviluppo e la modifica del programma.

Anche la formazione dell’IA a comportarsi in modo etico è un campo emergente, ma estremamente nascente, che ha attirato l’interesse di organizzazioni sia private che pubbliche. Una delle difficoltà principali è che l’etica è una disciplina molto soggettiva, in cui le azioni etiche in una serie di circostanze possono essere non etiche in un’altra. Ma come James Kobielus, direttore senior della ricerca per la gestione dei dati presso TDWI, sottolinea, la responsabilità etica ultima deve rimanere con gli esseri umani, non con gli oggetti inanimati, non importa quanto intelligenti sembrino. Per evitare che l’intelligenza artificiale “diventi canaglia”, dovrebbe sempre incorporare gli interessi umani come elemento centrale, e questo può manifestarsi in tutto, dalle decisioni che prende al modo in cui appare. Inoltre, la trasparenza nel lignaggio dell’inferenza dell’IA potrebbe essere necessaria per garantire che ci sia una traccia di controllo per gli umani che l’hanno creata.

Alla fine, ovviamente, la gestione dell’IA è una questione di fiducia. Le organizzazioni farebbero bene a trattare l’IA come qualsiasi altro dipendente: assegnargli una serie limitata di responsabilità, vedere come si comporta e quindi promuoverla a livelli di autorità più elevati dopo che si è dimostrata capace e degna. Proprio come non nominerai un neolaureato come nuovo CIO, non metti l’intelligenza artificiale a capo della gestione delle vendite di livello C o delle risorse umane.

Sebbene il rischio di conseguenze indesiderate non possa mai essere ridotto a zero, le probabilità sono buone che in qualche modo, in qualche modo, gli esseri umani e l’intelligenza artificiale troveranno un modo per lavorare insieme. E poiché entrambe le forme di intelligenza forniscono punti di forza che compensano le debolezze dell’altro, è più che probabile che la loro relazione sia reciprocamente vantaggiosa, non ostile.