Nell’intelligenza artificiale, emerge una scoperta tanto sorprendente quanto rivelatrice: i modelli linguistici di grandi dimensioni possono modificare le loro risposte a seconda del registro e dello stile con cui vengono interrogati. Questo fenomeno, recentemente analizzato in uno studio riportato da Unite.ai, mette in luce quanto sia sottile il confine tra la comprensione semantica e l’influenza del tono umano sull’output di un sistema AI.

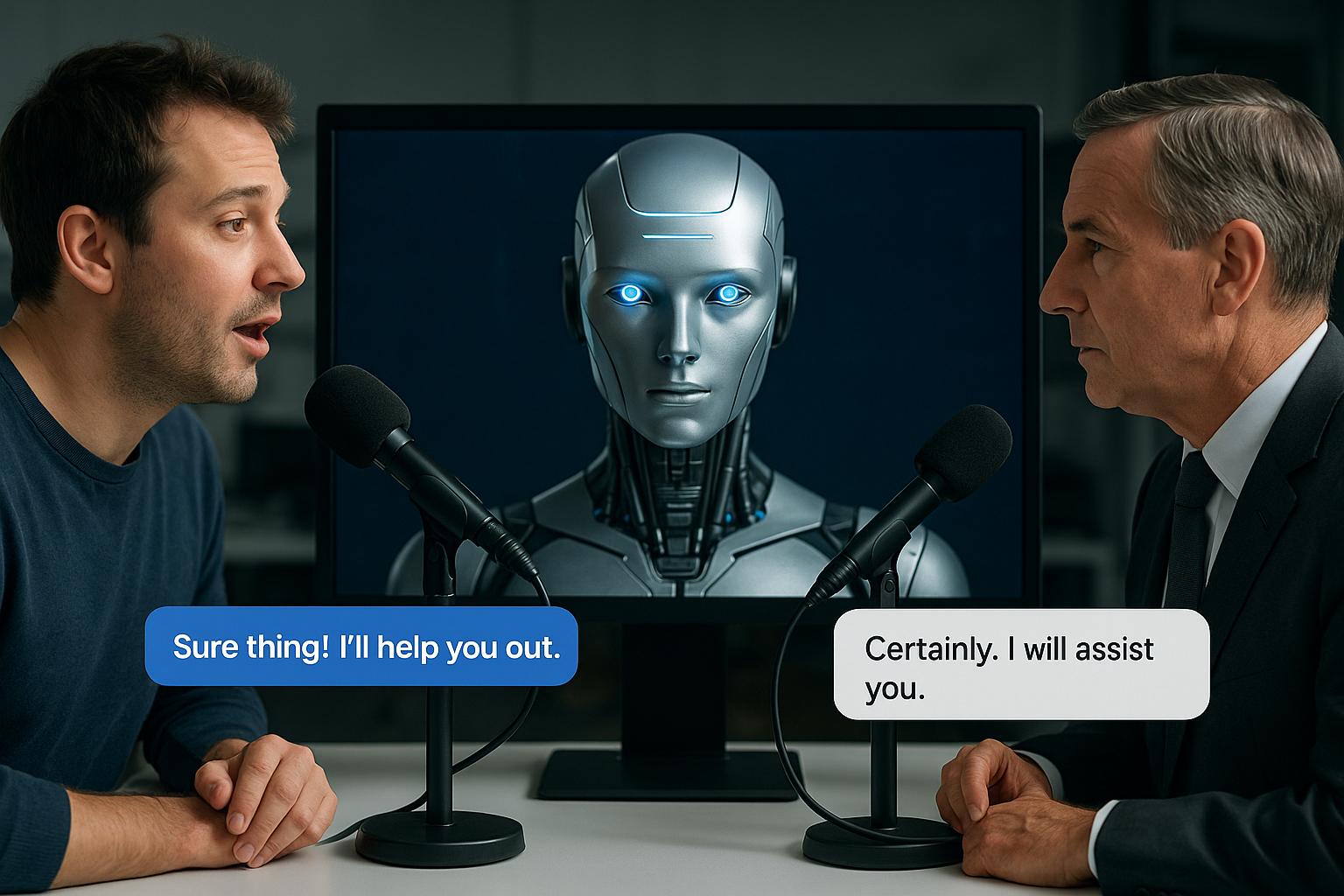

Immaginate di rivolgervi a un modello come ChatGPT con una domanda semplice: «Che cosa causa l’effetto serra?». Se la stessa questione viene posta in modo colloquiale, adattando un registro più informale e colloquiale, il modello offre una risposta più discorsiva, ricca di esempi e di un’impostazione divulgativa.

Cambiate invece il tono in qualcosa di più tecnico e formale, ed ecco che l’AI adotta un gergo specialistico, citando dettagli più puntuali e approfonditi. Non si tratta solo di variazioni stilistiche: a volte cambiano persino alcuni dettagli, enfatizzando aspetti diversi del fenomeno.

Questa mediazione del linguaggio umano sull’intelligenza artificiale pone interrogativi fondamentali. Da un lato, dimostra la flessibilità sorprendente di questi sistemi, capaci di adattarsi a registri diversi quasi come un redattore esperto. Dall’altro, solleva dubbi sull’obiettività e la coerenza delle risposte. In ambiti delicati come la medicina o il diritto, dove precisione e uniformità sono essenziali, questa variabilità potrebbe tradursi in informazioni contrastanti.

I ricercatori suggeriscono che la ragione di questo fenomeno risieda nei dataset su cui i modelli sono stati addestrati. Tali dataset includono testi di stili eterogenei: articoli scientifici, post sui social, manuali tecnici, dialoghi informali. Quando un prompt richiama un certo registro, il modello attinge alle porzioni di dati più affini, modulando non solo il tono, ma anche il livello di approfondimento.

Per mitigare questo effetto, gli sviluppatori propongono tecniche di fine-tuning mirato e l’introduzione di meccanismi di controllo più stringenti sui prompt. Un controllo di qualità interno, basato su metriche standardizzate, potrebbe fungere da filtro, assicurando che le risposte mantengano coerenza informativa a prescindere dal registro adottato. In prospettiva futura, la sfida sarà trovare l’equilibrio tra la naturalezza del dialogo umano e la rigida affidabilità richiesta in contesti professionali e specialistici.