NeRF: Facebook Co-Research sviluppa una sintesi video statica / dinamica mista

Una collaborazione tra il Virginia Polytechnic Institute e la State University e Facebook ha risolto una delle principali sfide nella sintesi video NeRF: mescolare liberamente immagini statiche e dinamiche e video nell’output Neural Radiance Fields (NeRF).

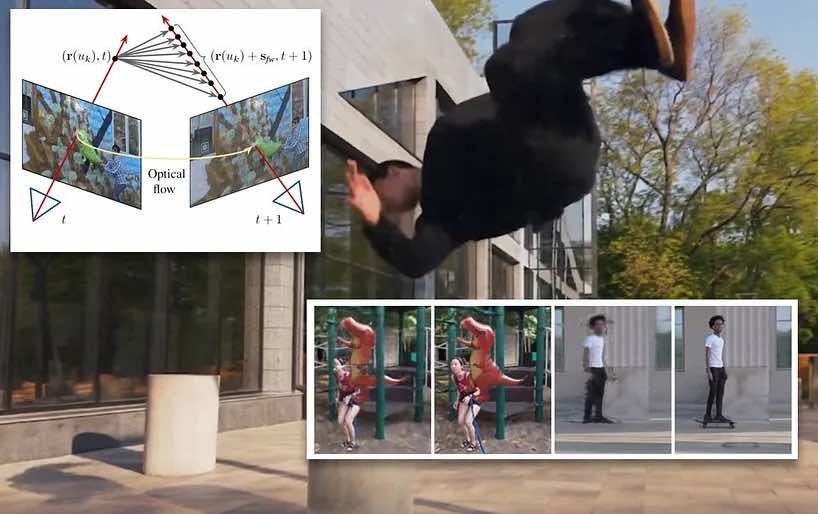

Il sistema può generare scene navigabili che presentano sia elementi video dinamici che ambienti statici, ciascuno registrato sul posto, ma separato in sfaccettature controllabili di un ambiente virtuale:

Sintesi vista dinamica da video monoculare dinamico

Inoltre, ottiene ciò da un unico punto di vista, senza la necessità del tipo di array multi-camera che può legare iniziative come questa a un ambiente di studio.

Il documento , intitolato Dynamic View Synthesis from Dynamic Monocular Video , non è il primo a sviluppare un flusso di lavoro NeRF monoculare , ma sembra essere il primo ad addestrare simultaneamente un modello variabile nel tempo e uno statico nel tempo dallo stesso input e a generare un framework che consente al video in movimento di esistere all’interno di un locale NeRF “pre-mappato”, simile al tipo di ambienti virtuali che spesso incapsulano gli attori in uscite di fantascienza ad alto budget.

Oltre D-NeRF

I ricercatori hanno dovuto essenzialmente ricreare la versatilità di Dynamic NeRF ( D-NeRF ) con un solo punto di vista e non la molteplicità di telecamere che D-NeRF utilizza. Per risolvere questo problema, hanno previsto il flusso della scena in avanti e all’indietro e hanno utilizzato queste informazioni per sviluppare un campo di radianza deformato che è temporalmente coerente.

Con un solo POV, è stato necessario utilizzare l’analisi del flusso ottico 2D per ottenere punti 3D nei frame di riferimento. Il punto 3D calcolato viene quindi reinserito nella telecamera virtuale per stabilire un “flusso di scena” che corrisponda al flusso ottico calcolato con il flusso ottico stimato.

Al momento dell’addestramento, gli elementi dinamici e gli elementi statici vengono riconciliati in un modello completo come sfaccettature accessibili separatamente.

Includendo un calcolo della perdita dell’ordine di profondità, il modello e applicando una rigorosa regolarizzazione della previsione del flusso di scena in D-NeRF, il problema del motion blur è notevolmente mitigato.

Sebbene la ricerca abbia molto da offrire in termini di regolarizzazione del calcolo del NeRF e migliori notevolmente la destrezza e la facilità di esplorazione per l’output da un singolo POV, di almeno uguale nota è la nuova separazione e reintegrazione di elementi NeRF dinamici e statici .

Affidandosi a una sola telecamera, un tale sistema non può replicare la vista panopticon delle configurazioni NeRF di array multi-camera, ma può andare ovunque e senza un camion.

NeRF – Statico o video?

Recentemente abbiamo esaminato alcune nuove impressionanti ricerche NeRF dalla Cina che sono in grado di separare gli elementi in una scena NeRF dinamica catturata con 16 telecamere.

ST-NeRF (sopra) consente allo spettatore di riposizionare gli elementi individuati in una scena catturata e persino di ridimensionarli, modificare la velocità di riproduzione, bloccarli o eseguirli all’indietro. Inoltre, ST-NeRF consente all’utente di “scorrere” qualsiasi parte dell’arco di 180 gradi catturato dalle 16 telecamere.

Tuttavia, i ricercatori della ST-nerf carta concedere in chiusura che il tempo è sempre in esecuzione in alcuni o altra direzione in questo sistema, e che è difficile cambiare l’illuminazione e applicare effetti ad ambienti che sono in realtà il video, piuttosto che ‘staticamente -mappato ‘ambienti NeRF che di per sé non contengono componenti mobili e non devono essere catturati come video.

Ambienti NeRF statici altamente modificabili

Una scena Neural Radiance Field statica, ora isolata da qualsiasi segmento video in movimento, è più facile da trattare e aumentare in diversi modi, inclusa la riaccensione, come proposto all’inizio di quest’anno da NeRV (Neural Reflectance and Visibility Fields for Relighting and View Synthesis), che offre un primo passo per cambiare l’illuminazione e / o la texture di un ambiente o oggetto NeRF: