Verso esseri umani con intelligenza artificiale in tempo reale con rendering del lumigrafo neurale

Rendering lumigrafo neurale

Nonostante l’attuale ondata di interesse per Neural Radiance Fields ( NeRF ), una tecnologia in grado di creare ambienti e oggetti 3D generati dall’intelligenza artificiale, questo nuovo approccio alla tecnologia di sintesi delle immagini richiede ancora molto tempo di addestramento e manca di un’implementazione che lo consenta interfacce in tempo reale e altamente reattive.

Tuttavia, una collaborazione tra alcuni nomi di spicco dell’industria e del mondo accademico offre un nuovo approccio a questa sfida (genericamente nota come Novel View Synthesis o NVS).

Il documento di ricerca , intitolato Neural Lumigraph Rendering , afferma un miglioramento dello stato dell’arte di circa due ordini di grandezza, che rappresenta diversi passaggi verso il rendering CG in tempo reale tramite pipeline di apprendimento automatico .

Sebbene i crediti per il documento citino solo la Stanford University e la società di tecnologia di visualizzazione olografica Raxium (attualmente operante in modalità invisibile ), i contributori includono un principale architetto di apprendimento automatico di Google, uno scienziato informatico di Adobe e il CTO di StoryFile (che ha fatto notizia di recente con una versione AI di William Shatner).

Per quanto riguarda il recente blitz pubblicitario di Shatner, StoryFile sembra impiegare NLR nel suo nuovo processo per la creazione di entità interattive generate dall’intelligenza artificiale basate sulle caratteristiche e le narrazioni delle singole persone.

William Shatner per preservare la sua vita attraverso l’intelligenza artificiale

StoryFile prevede l’uso di questa tecnologia nelle esposizioni dei musei, nelle narrazioni interattive online, nei display olografici, nella realtà aumentata (AR) e nella documentazione del patrimonio – e sembra anche osservare potenziali nuove applicazioni di NLR nelle interviste di reclutamento e nelle applicazioni di appuntamenti virtuali:

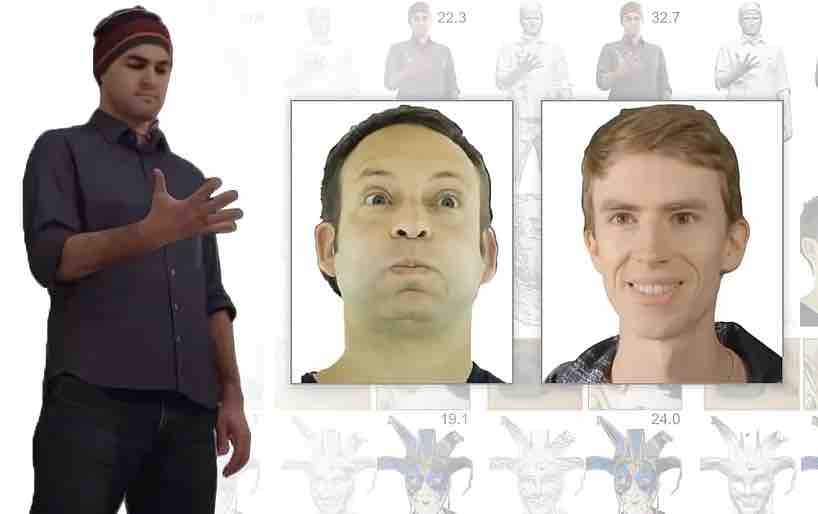

Acquisizione volumetrica per interfacce e video di sintesi di nuove viste

Il principio della cattura volumetrica, attraverso la gamma di documenti che si stanno accumulando sull’argomento, è l’idea di scattare immagini fisse o video di un soggetto e utilizzare l’apprendimento automatico per “ riempire ” i punti di vista che non erano coperti dall’originale serie di telecamere.

Nell’immagine sopra, tratta dalla ricerca AI 2019 AI di Facebook (vedi sotto), vediamo le quattro fasi dell’acquisizione volumetrica: più telecamere ottengono immagini / filmati; l’architettura del codificatore / decodificatore (o altre architetture) calcola e concatena la relatività delle viste; gli algoritmi di ray-marching calcolano i voxel (o altre unità geometriche spaziali XYZ) di ogni punto nello spazio volumetrico; e (negli articoli più recenti) la formazione avviene per sintetizzare un’entità completa che può essere manipolata in tempo reale.

È questa fase di addestramento spesso ampia e ricca di dati che, fino ad oggi, ha mantenuto la nuova sintesi della vista fuori dal regno dell’acquisizione in tempo reale o altamente reattiva.

Il fatto che Novel View Synthesis crei una mappa 3D completa di uno spazio volumetrico significa che è relativamente banale unire questi punti insieme in una mesh tradizionale generata al computer, catturando e articolando efficacemente un umano CGI (o qualsiasi altro oggetto relativamente delimitato) su- La mosca.

Gli approcci che utilizzano NeRF si basano su nuvole di punti e mappe di profondità per generare le interpolazioni tra i punti di vista sparsi dei dispositivi di acquisizione:

Sebbene NeRF sia in grado di calcolare le mesh, la maggior parte delle implementazioni non lo utilizza per generare scene volumetriche.

Al contrario, l’ approccio Implicit Differentiable Renderer ( IDR ), pubblicato dal Weizmann Institute of Science nell’ottobre 2020, si basa sullo sfruttamento delle informazioni sulla mesh 3D generate automaticamente dagli array di acquisizione:

Sebbene NeRF non abbia la capacità di IDR per la stima della forma, IDR non può eguagliare la qualità dell’immagine di NeRF ed entrambi richiedono ampie risorse per l’addestramento e la raccolta (sebbene le recenti innovazioni in NeRF stiano iniziando a risolvere questo problema ).

Invece, Neural Lumigraph Rendering utilizza SIREN (Sinusoidal Representation Networks) per incorporare i punti di forza di ogni approccio nel proprio framework, che ha lo scopo di generare output che è direttamente utilizzabile nelle pipeline grafiche in tempo reale esistenti.

SIREN è stato utilizzato per implementazioni simili nell’ultimo anno e ora rappresenta un popolare appello API per Colabs hobbisti nelle comunità di sintesi di immagini; tuttavia, l’innovazione di NLR consiste nell’applicare le SIREN alla supervisione di immagini bidimensionali multi-vista, il che è problematico a causa della misura in cui SIREN produce un output sovradimensionato piuttosto che generalizzato.

Dopo che la mesh CG è stata estratta dalle immagini dell’array, la mesh viene rasterizzata tramite OpenGL e le posizioni dei vertici della mesh mappate ai pixel appropriati, dopodiché viene calcolata la fusione delle varie mappe che contribuiscono.

La mesh risultante è più generalizzata e rappresentativa di NeRF (vedi immagine sotto), richiede meno calcoli e non applica dettagli eccessivi alle aree (come la pelle liscia del viso) che non possono trarne beneficio:

Sul lato negativo, NLR non ha ancora alcuna capacità di illuminazione dinamica o riaccensione e l’output è limitato alle mappe delle ombre e ad altre considerazioni sull’illuminazione ottenute al momento dell’acquisizione. I ricercatori intendono affrontare questo problema nel lavoro futuro.

Inoltre, il documento ammette che le forme generate da NLR non sono accurate come alcuni approcci alternativi, come Pixelwise View Selection for Unstructured Multi-View Stereo , o la ricerca del Weizmann Institute menzionata in precedenza.

The Rise Of Volumetric Image Synthesis

L’idea di creare entità 3D da una serie limitata di foto con reti neurali precede NeRF, con documenti visionari che risalgono al 2007 o prima. Nel 2019 il dipartimento di ricerca sull’intelligenza artificiale di Facebook ha prodotto un documento di ricerca fondamentale , Neural Volumes: Learning Dynamic Renderable Volumes from Images , che ha prima abilitato interfacce reattive per esseri umani sintetici generati dall’acquisizione volumetrica basata sull’apprendimento automatico.