Negli ultimi mesi, l’intelligenza artificiale conversazionale è diventata non solo uno strumento per lavoro, studio o intrattenimento, ma anche uno spazio in cui alcuni individui cercano ascolto, conforto o consigli personali. È un territorio delicato, soprattutto quando a usarla sono adolescenti vulnerabili. La tragica morte di un ragazzo in California, che secondo una causa legale avrebbe avuto interazioni prolungate con ChatGPT su temi di autolesionismo, ha acceso un dibattito acceso sul dovere delle aziende AI di proteggere i più giovani. In risposta, OpenAI ha annunciato una serie di novità: controlli parentali, routing sicuro delle conversazioni sensibili, e una serie di limitazioni attivabili dagli account dei genitori.

La scintilla di questo cambiamento è stata una causa legale promossa da Matthew e Maria Raine, i genitori del diciassettenne Adam, che è morto suicida nell’aprile del 2025. Nella loro denuncia sostengono che durante mesi di conversazioni con ChatGPT il ragazzo avrebbe ottenuto risposte che assecondavano ideazioni legate al suicidio, suggerimenti su metodi e persino come nascondere le proprie azioni.

Secondo OpenAI stessa, il caso ha messo in evidenza una criticità: nel corso di lunghi dialoghi, i meccanismi di sicurezza del modello possono degradarsi, lasciando spazio a risposte meno controllate.

La notizia ha fatto rapidamente il giro del mondo. Media autorevoli hanno riportato che OpenAI, già sotto pressione, ha deciso che era tempo di misure concrete per evitare che simili tragedie si ripetano.

Le novità si inseriscono in un quadro più ampio: in un blog ufficiale, OpenAI ha dichiarato che considera la protezione dei più vulnerabili una delle sue responsabilità, e che il sistema di rilevamento dei segnali emotivi è parte di una “stack a più livelli” concepita per intervenire quando qualcuno mostra disagio interiore.

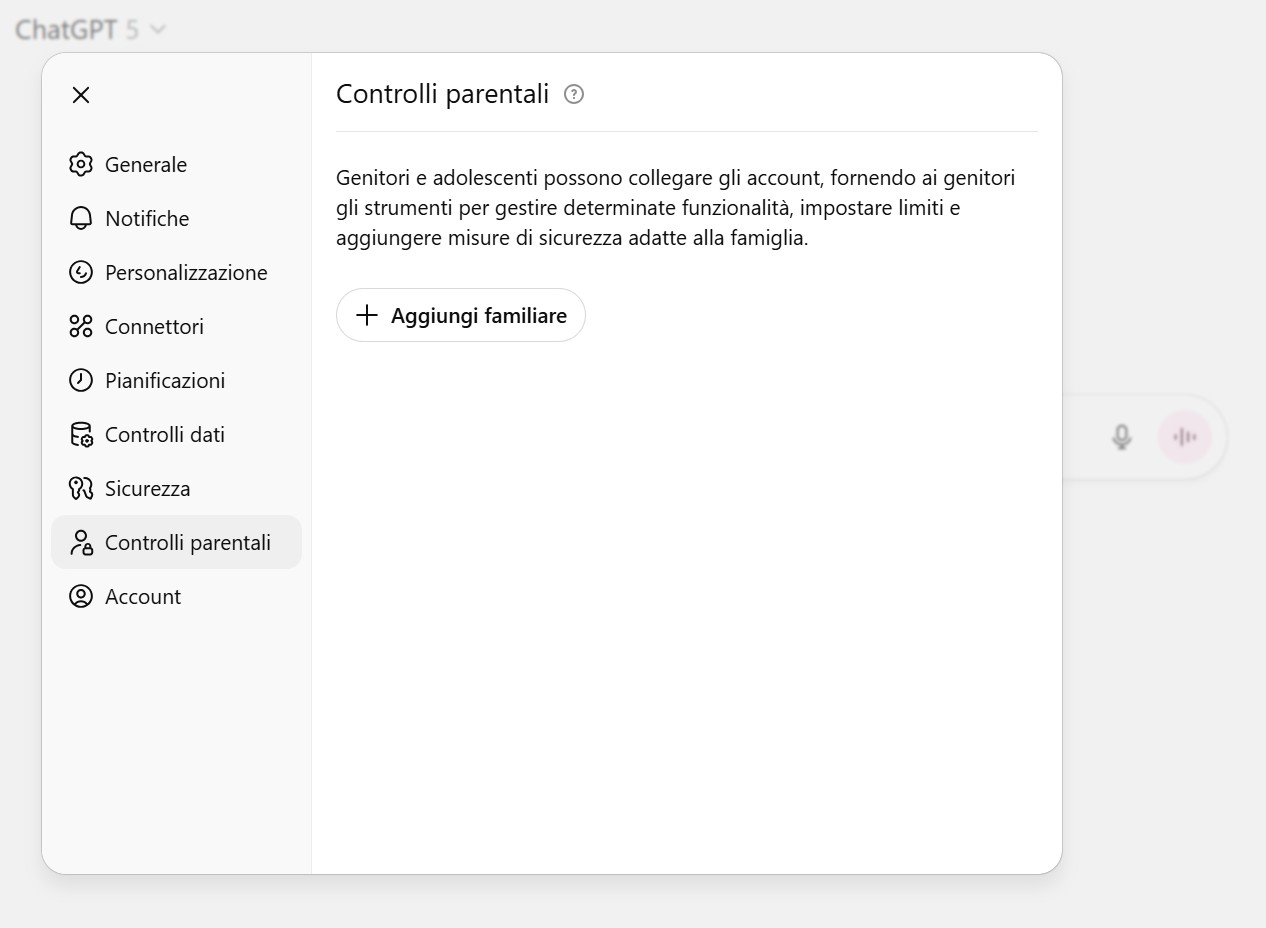

Le nuove modifiche annunciate introdurranno strumenti che mettono i genitori — con il consenso del ragazzo — in una posizione di controllo più attiva, senza però violare la privacy dei ragazzi. Ecco le linee principali: Gli account dei genitori e quelli degli adolescenti possono essere collegati, tramite invito via email. Solo se il legame è accettato, si attivano le restrizioni. Con questo collegamento, i genitori potranno gestire quali funzioni disattivare: la memoria delle chat (ossia la capacità del modello di ricordare conversazioni passate), la cronologia, l’uso delle modalità vocali o la generazione/modifica di immagini.

I genitori possono impostare “quiet hours” (ore di silenzio) durante le quali l’uso dell’app da parte dell’adolescente è limitato o disattivato.

Se il sistema rileva segnali di rischio elevato — come ideazioni suicide, autolesionismo o contenuti emotivamente critici — si prevede che un revisore umano intervenga e che ai genitori possa essere inviata una notifica (via email, SMS o push).

Nel routing delle conversazioni, le interazioni che appaiono emotivamente sensibili verranno automaticamente dirottate su un modello più “sicuro”, come GPT-5, che è stato addestrato con “completamenti sicuri” per rispondere con maggiore cautela quando la situazione lo richiede.

Alcuni contenuti protetti per l’uso dei ragazzi verranno filtrati: violenza eccessiva, idealizzazione dell’aspetto, o contenuti esplicitamente sensibili potranno essere limitati.

Importante: i genitori non avranno accesso diretto ai contenuti delle chat del ragazzo — la privacy individuale resta preservata.

OpenAI ha precisato che molte di queste misure saranno messe in opera nel corso dei prossimi 120 giorni, in collaborazione con esperti di salute mentale e psicologia adolescenziale.

Una novità tecnologica particolarmente interessante è il meccanismo del routing sicuro: il sistema analizza ogni messaggio in tempo reale e, se rileva segnali emotivi critici o tematiche delicate, passa automaticamente la conversazione a un modello “reasoning” più protettivo (come GPT-5), che è stato addestrato con strategie di risposta pensate per scaffaldare i rischi.

Questo cambio avviene messaggio per messaggio, senza che l’utente debba cambiare app o modalità. In altre parole: se stai parlando di compiti o ricette, rimani su GPT-4o; se inizi a toccare argomenti emotivamente sensibili, l’IA potrà richiudere su un approccio più cauto, cercando di offrire risorse utili, non soluzioni avventate.

Con queste misure, OpenAI cerca di rafforzare l’equilibrio tra libertà, privacy e protezione. L’introduzione dei controlli parentali segna una trasformazione culturale: non si vede più ChatGPT solo come strumento neutro, ma come piattaforma che ha impatti sociali e psicologici reali.

Se funzioneranno come promesso, questi controlli potranno diventare modello per altre aziende AI che offrono strumenti conversazionali. E se il routing sensibile dimostrerà di guidare meglio le conversazioni critiche, potrebbe diventare standard nel settore.