DALL.E 2 è molto più versatile e in grado di sfornare immagini a risoluzione più elevata.

All’inizio dello scorso anno, la società di intelligenza artificiale OpenAI con sede a San Francisco ha lanciato un sistema di intelligenza artificiale in grado di generare un’immagine realistica dalla descrizione della scena o dell’oggetto e lo ha chiamato DALL.E. Il nome del generatore da testo a immagine era un portmanteau coniato dopo aver combinato l’artista Salvador Dali e il robot WALL.E del film Pixar con lo stesso nome. OpenAI ha quindi descritto DALL.E come il “GPT-3 per le immagini”. Come GPT-3 , DALL.E è anche un modello di linguaggio trasformatore . Nonostante il fatto che il modello stesse apparentemente realizzando immagini dal nulla, i risultati prodotti non erano esattamente degni di una cornice.

La scorsa settimana, OpenAI ha annunciato una versione più avanzata chiamata DALL.E 2 . La reazione alle immagini sfornate dalla modella ha provocato un mini trambusto su Twitter. Il CEO Sam Altman ha iniziato a invitare commentatori casuali a suggerire le idee più creative a cui potevano pensare per il modello da cui ricavare immagini. DALL.E 2 più che obbligato a creare immagini dal nulla.

DALL.E era un modello di parametri da 12 miliardi che funzionava utilizzando un set di dati di coppie testo-immagine. Come input, ha ricevuto sia l’immagine che il testo come un unico flusso di dati. Ogni flusso di dati conteneva fino a 1280 token ed è stato addestrato utilizzando la massima probabilità per generare tutti i token, uno dopo l’altro. Ciò ha consentito a DALL.E di produrre un’immagine nuova da zero. Potrebbe anche rigenerare qualsiasi regione rettangolare di un’immagine esistente che si estendesse fino all’angolo in basso a destra, in modo che fosse coerente con le istruzioni di testo.

DALL.E 2 essenzialmente fa la stessa cosa che fa DALL.E, ovvero prendere un prompt complesso come “Un dipinto ispirato all’arte di Banksy che mostra un’interazione macchina-uomo”, e poi trasformarlo in centinaia di immagini. Alla fine, sceglie l’immagine più adatta da tutte le uscite a quella che soddisfi gli standard dell’utente. Tuttavia, DALL.E 2 è molto più versatile e in grado di produrre immagini con una risoluzione più elevata.

Più efficiente: DALL.E 2 funziona su un modello di parametri da 3,5 miliardi mentre utilizza un altro modello di parametri da 1,5 miliardi per migliorare la risoluzione delle sue immagini prodotte digitalmente. Il modello è anche più veloce nell’elaborazione delle immagini rispetto a DALL.E. Il grande salto di prestazioni è dovuto a un nuovo modello di diffusione , più piccolo e più efficiente di quello utilizzato da DALL.E. Il modello di diffusione inizia con un’immagine che è interamente rumore e poi si trasforma gradualmente per farla sembrare il più vicino possibile al prompt.

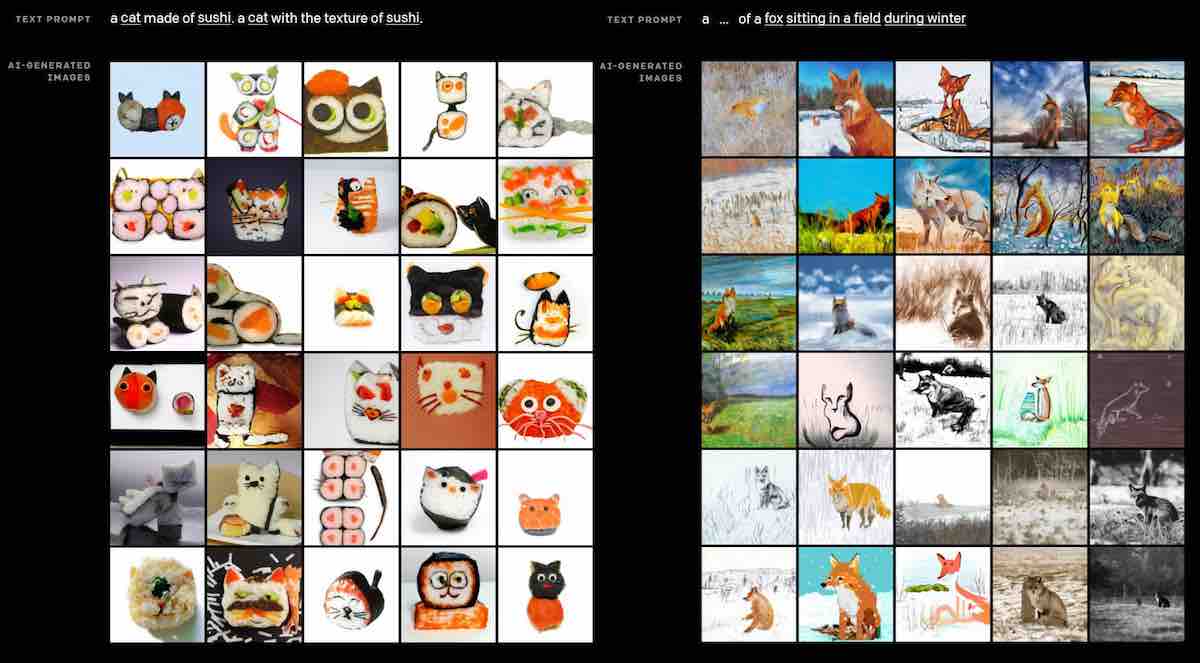

Più realistico: le immagini prodotte dalla versione più recente sono più a tutto tondo, con sfondi complessi, illuminazione e riflessi realistici. Il prodotto finale è molto diverso dalle immagini prodotte da DALL.E che erano da cartone animato e, il più delle volte, avevano uno sfondo semplice.

Modifica: un’altra importante aggiunta a DALL.E 2 è che può modificare un’immagine usando ciò che chiama “inpainting”. Un utente può inserire il prompt che richiede la modifica che desidera apportare e selezionare l’area dell’immagine che desidera modificare. In pochi secondi, il modello produce una manciata di opzioni tra cui l’utente può scegliere. Ad esempio, l’utente può selezionare un’area su un tavolo che contiene i piatti e richiederne la rimozione, se lo desidera. Il modello è anche in grado di rendere le luci e le ombre appropriate nelle immagini oltre a utilizzare anche i materiali più adatti per gli oggetti.

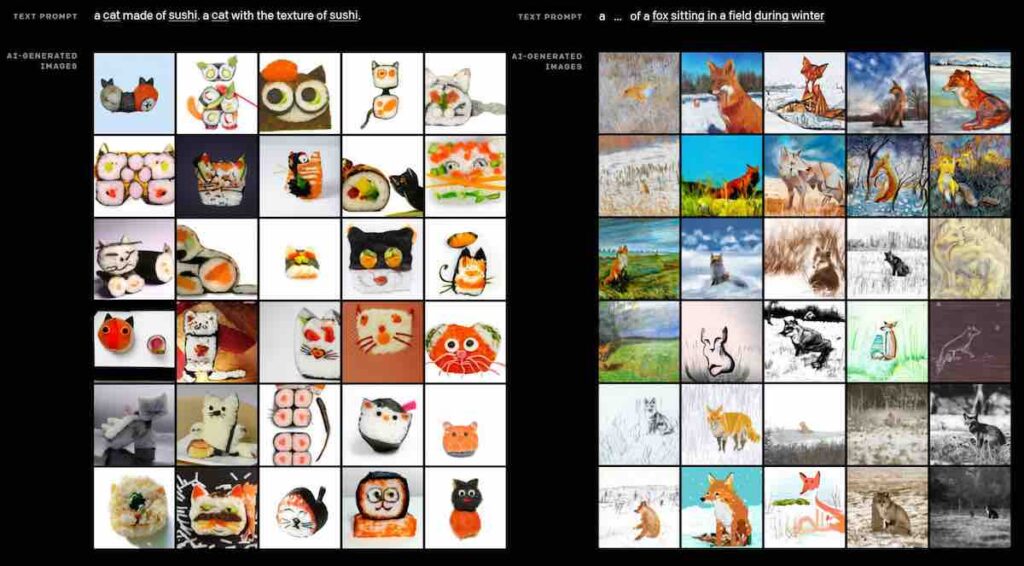

Variazioni multiple: DALL.E 2 è anche in grado di produrre variazioni multiple di una singola immagine. Queste variazioni potrebbero essere una versione impressionistica dell’immagine o una sua stretta somiglianza. L’utente può anche dare al modello una seconda immagine e DALL.E 2 può combinare le caratteristiche più vitali di entrambe le immagini per formarne una finale.

Secondo i test condotti da OpenAI , la classificazione delle immagini e le didascalie di DALL.E 2 sono più accurate. Nell’ultimo anno, è stato riscontrato che gli algoritmi erano più vulnerabili a essere indotti con l’inganno a etichettare erroneamente un elemento. Ad esempio, se il sistema fosse stato addestrato utilizzando l’immagine di una mela etichettata come “arancione”, il sistema sarebbe stato indotto con l’inganno a credere che fosse un’arancia. Tuttavia, DALL.E 2 non commette lo stesso errore.

Limitazioni

OpenAI ha affermato di essere consapevole del potenziale impatto negativo che DALL.E 2 potrebbe avere nelle mani sbagliate. Nel mondo odierno di deep fake, il modello potrebbe essere facilmente utilizzato per produrre disinformazione o immagini razziste, motivo per cui OpenAI ha consentito a DALL.2 di essere utilizzato dagli sviluppatori esclusivamente su invito. Tutti i suggerimenti ricevuti dal modello devono aderire a una rigorosa politica dei contenuti. Per escludere completamente la possibilità che DALL.E 2 produca immagini odiose o violente, il set di dati stesso ha omesso l’inclusione di armi pericolose. Sebbene OpenAI abbia affermato che intende trasformarla alla fine in un’API, è pronta a procedere con cautela nel caso di DALL.E 2.