Gli strumenti del browser AI mirano a riconoscere i deepfake e altri media falsi

Gli sforzi delle aziende tecnologiche per contrastare la disinformazione e i contenuti falsi stanno prendendo piede negli ultimi tempi poiché le sofisticate tecnologie di generazione di contenuti falsi come DeepFakes diventano più facili da usare e più raffinate. Un tentativo imminente per aiutare le persone a rilevare e combattere i deepfake è RealityDefender, prodotto dalla AI Foundation , che si è impegnata a sviluppare agenti e assistenti di IA etici che gli utenti possono addestrare per completare varie attività.

Il progetto più importante della AI Foundation è una piattaforma che consente alle persone di creare i propri personaggi digitali che assomigliano a loro e li rappresentano in spazi di ritrovo virtuali. La AI Foundation è supervisionata dal Global AI Council e come parte del suo mandato deve anticipare i possibili impatti negativi delle piattaforme AI, quindi cercare di superare questi problemi. Come riportato da VentureBeat, Uno degli strumenti che la AI Foundation ha creato per assistere nel rilevamento dei deepfake è soprannominato Reality Defender. Reality Defender è uno strumento che una persona può utilizzare nel proprio browser web (controllare), che analizzerà video, immagini e altri tipi di media per rilevare i segni che i media sono stati falsificati o alterati in qualche modo. Si spera che lo strumento aiuti a contrastare il crescente flusso di deepfake su Internet, che secondo alcune stime è più o meno raddoppiato nel corso degli ultimi sei mesi.

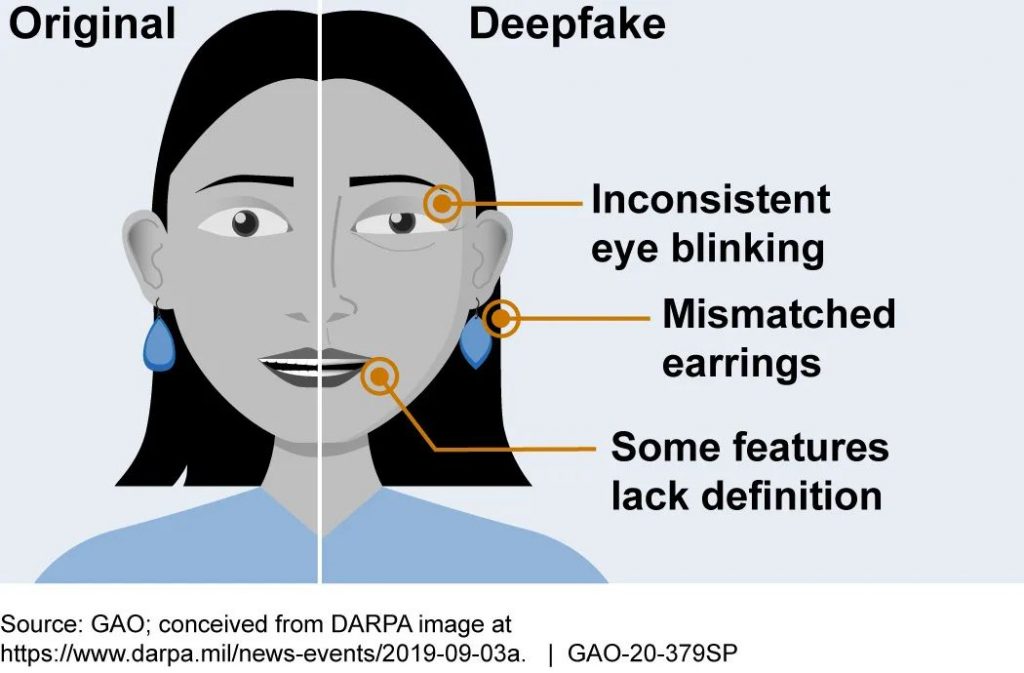

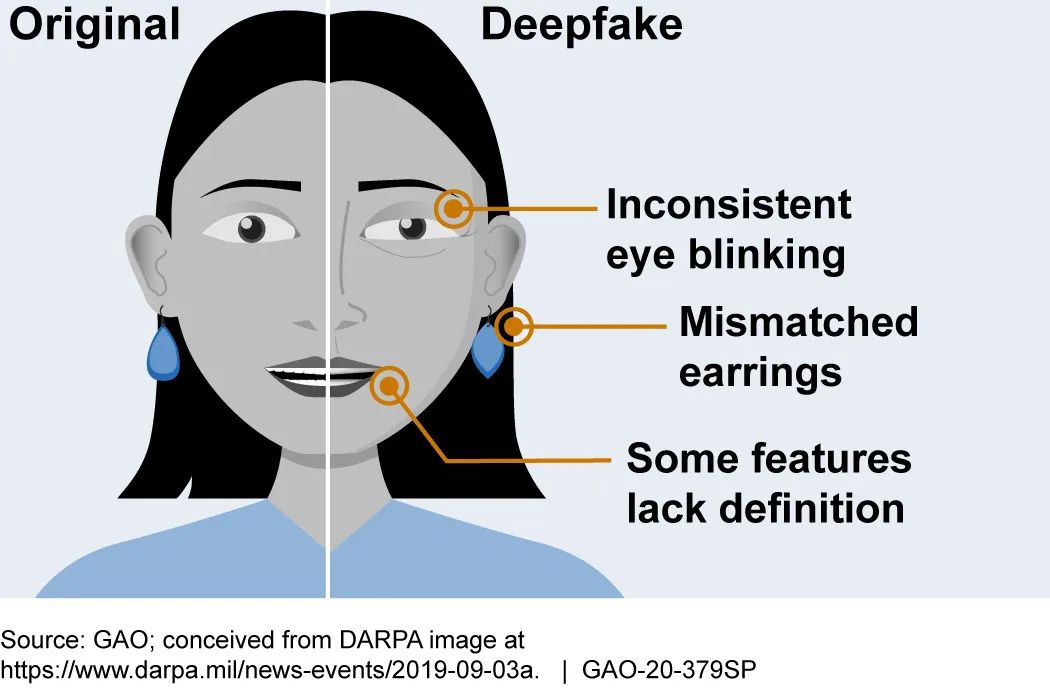

Reality Defender funziona utilizzando una varietà di algoritmi basati sull’intelligenza artificiale in grado di rilevare indizi che suggeriscono che un’immagine o un video potrebbero essere stati falsificati. I modelli di intelligenza artificiale rilevano sottili segni di inganno e manipolazione e i falsi positivi rilevati dal modello vengono etichettati come errati dagli utenti dello strumento. I dati vengono quindi utilizzati per riqualificare il modello. Le aziende di intelligenza artificiale che creano deepfake non ingannevoli hanno i loro contenuti contrassegnati con un tag o una filigrana di “IA onesta” che consente alle persone di identificare prontamente i falsi generati dall’intelligenza artificiale.

Reality Defender è solo uno di una suite di strumenti e un’intera piattaforma di responsabilità dell’IA che AI Foundation sta tentando di creare. AI Foundation sta perseguendo la creazione di Guardian AI, una piattaforma di responsabilità basata sul precetto che gli individui dovrebbero avere accesso ad agenti personali di IA che lavorano per loro e che possono aiutare a proteggersi dal loro sfruttamento da parte di cattivi attori. In sostanza, AI Foundation mira sia ad espandere la portata dell’IA nella società, portandola a più persone, proteggendosi anche dai rischi dell’IA.

Reality Defender non è l’unico nuovo prodotto basato sull’intelligenza artificiale che mira a ridurre la disinformazione negli Stati Uniti. Un prodotto simile si chiama SurfSafe, che è stato creato da due studenti universitari della UC Berkeley, Rohan Phadte e Ash Bhat. Secondo The Verge , SurfSafe opera consentendo ai suoi utenti di fare clic su un supporto di cui sono curiosi e il programma eseguirà una ricerca inversa di immagini e proverà a trovare contenuti simili da varie fonti attendibili su Internet, contrassegnando le immagini che sono noti per essere manipolati.

Non è chiaro quanto saranno efficaci queste soluzioni a lungo termine. Il professore del Dartmouth College ed esperto di medicina legale Hany Farid è stato citato da The Verge per aver affermato di essere “estremamente scettico” sul fatto che sistemi di piani come Reality Defender funzioneranno in modo significativo. Farid ha spiegato che una delle sfide principali nel rilevamento di contenuti falsi è che i media non sono puramente falsi o reali. Farid ha spiegato:

“C’è un continuum; una gamma incredibilmente complessa di problemi da affrontare. Alcuni cambiamenti sono privi di significato e alcuni alterano fondamentalmente la natura di un’immagine. Fingere di poter addestrare un’intelligenza artificiale per individuare la differenza è incredibilmente ingenuo. E fingere di poter fare crowdsourcing lo è ancora di più “.

Inoltre, è difficile includere elementi di crowdsourcing, come taggare falsi positivi, perché gli esseri umani in genere sono piuttosto scarsi nell’identificare le immagini false. Gli esseri umani spesso commettono errori e perdono dettagli sottili che contrassegnano un’immagine come falsa. Inoltre, non è chiaro come trattare gli attori in malafede che troll quando segnalano il contenuto.

Sembra probabile che, per essere la massima efficacia, gli strumenti di rilevamento dei falsi debbano essere combinati con sforzi di alfabetizzazione digitale che insegnino alle persone come ragionare sui contenuti con cui interagiscono online.