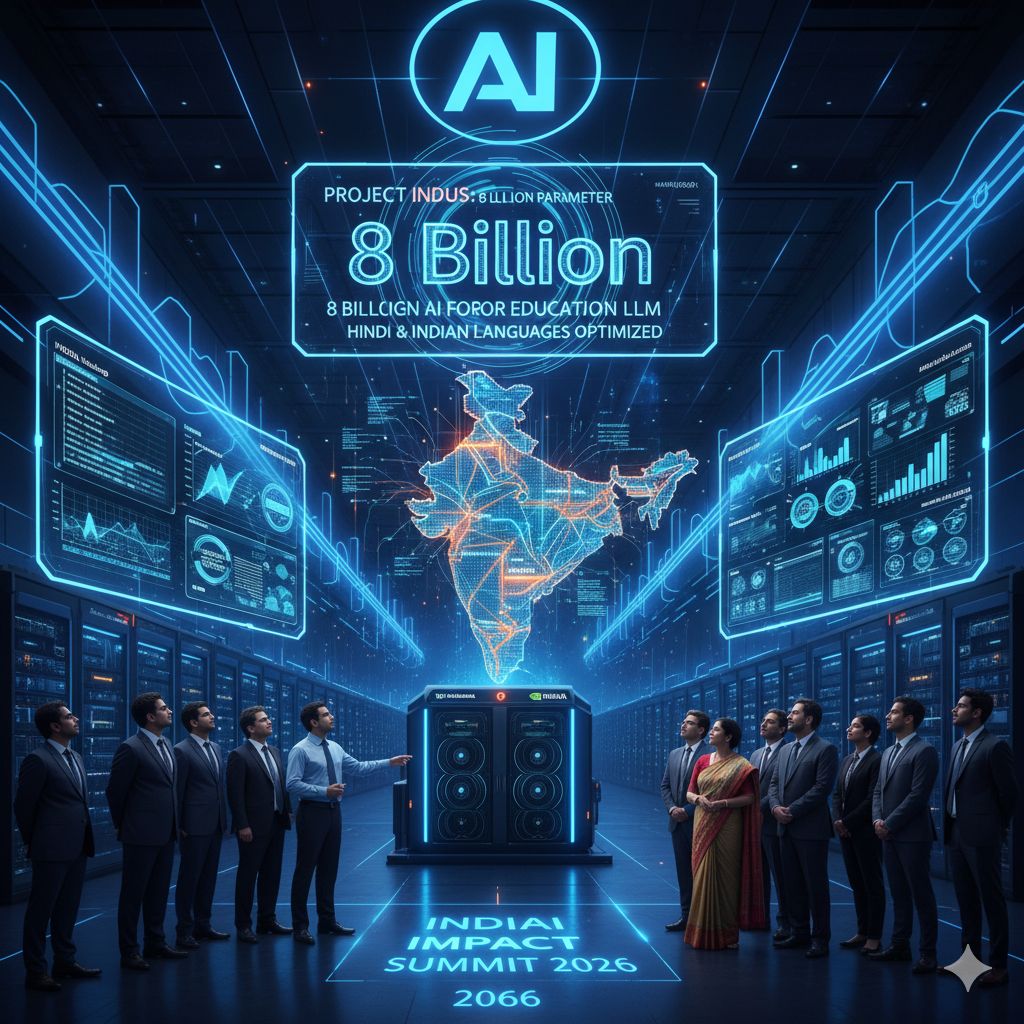

Tech Mahindra ha svelato al India AI Impact Summit 2026 un importante progresso nel panorama dell’AI “sovrana” indiana con il lancio di un nuovo Large Language Model (LLM) di 8 miliardi di parametri progettato specificamente per applicazioni educative e ottimizzato per l’hindi e altre lingue indiane. Questo modello rappresenta un’evoluzione significativa del suo progetto di AI nazionale denominato Project Indus, passando da un’architettura base da circa 1,2 miliardi di parametri a un sistema molto più grande e complesso pensato per affrontare sfide concrete nel campo dell’apprendimento digitale e della formazione linguistica locale.

L’obiettivo dichiarato dall’azienda è quello di democratizzare l’accesso a contenuti educativi di alta qualità attraverso l’intelligenza artificiale, colmando un vuoto che le tecnologie generative globali finora non sono riuscite a riempire efficacemente nei contesti plurilingue come quello indiano. Mentre i modelli AI internazionali più diffusi sono generalmente progettati attorno a lingue ad alta risorsa come l’inglese, il modello lanciato da Tech Mahindra mette al centro l’hindi come lingua primaria, con un’interpretazione contestuale profonda che tiene conto di sfumature culturali e linguistiche proprie del subcontinente.

Dal punto di vista tecnico, l’architettura da 8 miliardi di parametri impiegata in questo LLM consente capacità di generazione e comprensione testuale molto più sofisticate rispetto alle versioni precedenti, permettendo al sistema di rispondere a richieste complesse di studenti e docenti con maggiore precisione e coerenza. Questa capacità ampliata si traduce in un miglior supporto per l’elaborazione di concetti scientifici articolati, come quelli della fisica o di altre materie STEM, nell’hindi naturale, andando oltre le semplici traduzioni e fornendo spiegazioni che si conformano al linguaggio e agli stili cognitivi di chi apprende.

Un elemento fondamentale nello sviluppo di questo modello è stata la collaborazione con NVIDIA, che ha fornito non soltanto infrastrutture di calcolo ma anche strumenti specifici per la creazione, l’ottimizzazione e la scalabilità del modello. Tech Mahindra ha utilizzato la suite di strumenti NVIDIA, inclusi NeMo per la costruzione del modello base e NIM microservices per abilitare un’architettura distribuita e pronta per l’uso produttivo. Per compensare la scarsità di dati di alta qualità in alcune lingue locali, è stata generata una grande quantità di token sintetici (circa mezzo miliardo) utilizzando NVIDIA NeMo Data Designer, permettendo al modello di apprendere pattern linguistici e semantici più ricchi nel dominio educativo.

Oltre ad essere focalizzato sull’elaborazione del linguaggio naturale, il nuovo LLM supporta anche capabilities agentiche AI che permettono la costruzione di agenti autonomi capaci di interagire, assistere e guidare gli utenti in hindi in maniera conversazionale. Questo amplia le possibilità di impiego pratico, consentendo non solo risposte testuali statiche ma anche interazioni dinamiche che possono assistere gli studenti nel processo di apprendimento con continuità, ad esempio attraverso tutor AI personalizzati.

L’iniziativa si inserisce nel più ampio quadro strategico dell’IndiaAI Mission, un programma governativo volto a promuovere lo sviluppo di modelli fondazionali “sovrani” e specifici per il contesto indiano che rispondano alle esigenze linguistiche, culturali e sociali della popolazione. In questo contesto, il modello di Tech Mahindra è tra i pochi esempi di LLM costruiti da una grande società di servizi IT e non da startup dedicate all’AI pura, indicativo dell’interesse crescente verso soluzioni AI scalabili e integrate nei sistemi educativi nazionali.

La spinta verso la sovranità digitale, sottolineata anche dalle dichiarazioni interne all’azienda e dai partner tecnologici, riflette una tendenza più ampia all’interno dell’ecosistema AI indiano: sviluppare modelli e infrastrutture che non dipendano esclusivamente dalle tecnologie occidentali e che possano essere adattati alle specificità linguistiche e pedagogiche locali. In questo senso, l’LLM da 8 miliardi di parametri rappresenta non solo un salto tecnologico ma anche un passo verso un’intelligenza artificiale educativa contestualizzata, capace di supportare milioni di studenti nella loro lingua madre con strumenti adattivi e culturalmente rilevanti.

La realizzazione di un large language model così grande con un focus educativo e linguistico specifico richiede competenze avanzate in ingegneria dell’AI, formazione su set di dati diversificati e infrastrutture di calcolo performanti. L’uso di token sintetici aiuta ad affrontare la penuria di dati effettivi di alta qualità nei domini meno rappresentati, ma pone anche la sfida di garantire che tali dati sintetici non introducano bias o imprecisioni nei risultati. La collaborazione con NVIDIA, nota per i suoi strumenti AI enterprise, ha permesso di adottare tecniche avanzate sia di pre-training che di deployment, assicurando che il modello sia non soltanto performante, ma anche pronto per applicazioni su larga scala.