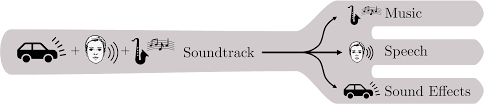

Una nuova collaborazione di ricerca guidata da Mitsubishi indaga la possibilità di estrarre tre colonne sonore separate da una sorgente audio originale, scomponendo la traccia audio in voce, musica ed effetti sonori (cioè rumore ambientale).

Poiché si tratta di un framework di elaborazione post-fatto, offre il potenziale per le generazioni successive di piattaforme di visualizzazione multimediale, comprese le apparecchiature di consumo, per offrire controlli del volume a tre punti, consentendo all’utente di aumentare il volume del dialogo o abbassare il volume di una colonna sonora .

Nella breve clip qui sotto dal video di accompagnamento per la ricerca (vedi la fine dell’articolo per il video completo), vediamo diverse sfaccettature della colonna sonora enfatizzate mentre l’utente trascina un controllo su un triangolo con ciascuno dei tre componenti audio in un angolo :

Il documento si intitola The Cocktail Fork Problem: Three-Stem Audio Separation for Real-World Soundtracks e proviene da ricercatori dei Mitsubishi Electric Research Laboratories (MERL) di Cambridge, MA, e del Department of Intelligent Systems Engineering dell’Indiana University in Illinois. .

Separare le sfaccettature di una colonna sonora

I ricercatori hanno soprannominato la sfida “The Cocktail Party Problem” perché comporta l’isolamento di elementi di una colonna sonora fortemente intrecciati, che crea una tabella di marcia simile a una forchetta (vedi immagine sotto). In pratica, le colonne sonore multicanale (ad es. stereo e altro) possono avere quantità diverse di tipi di contenuto, come dialoghi, musica e ambiente, soprattutto perché i dialoghi tendono a dominare il canale centrale nei mix Dolby 5.1. Al momento, però. il campo di ricerca molto attivo della separazione audio si sta concentrando sulla cattura di questi fili da un’unica colonna sonora cotta, come fa la ricerca attuale.

La ricerca recente si è concentrata sull’estrazione del parlato in vari ambienti, spesso allo scopo di denoising l’audio del parlato per il successivo coinvolgimento con i sistemi di elaborazione del linguaggio naturale (NLP), ma anche sull’isolamento delle voci di canto d’archivio, sia per creare versioni sintetiche di suoni reali ( anche morti ) cantanti, o per facilitare l’ isolamento musicale in stile Karaoke .

Un set di dati per ogni aspetto

Ad oggi, è stata data poca considerazione all’utilizzo di questo tipo di tecnologia AI per dare agli utenti un maggiore controllo sul mix di una colonna sonora. Pertanto i ricercatori hanno formalizzato il problema e generato un nuovo set di dati come ausilio alla ricerca in corso sulla separazione delle colonne sonore multi-tipo, oltre a testarlo su vari framework di separazione audio esistenti.

Il nuovo set di dati che gli autori hanno sviluppato si chiama Divide and Remaster (DnR) e deriva dai precedenti set di dati LibriSpeech , Free Music Archive e Freesound Dataset 50k (FSD50K). Per coloro che desiderano lavorare con DnR da zero, il set di dati deve essere ricostruito dalle tre fonti; altrimenti sarà presto disponibile su Zenodo, affermano gli autori. Tuttavia, al momento della scrittura, il collegamento GitHub fornito per le utilità di estrazione dei sorgenti non è attualmente attivo, quindi chi è interessato potrebbe dover attendere un po’.

Gli autori affermano che i loro modelli di estrazione dell’apprendimento automatico funzionano bene sulle colonne sonore di YouTube, sebbene le valutazioni presentate nel documento si basino su dati sintetici e il video di supporto principale fornito (incorporato di seguito) sia attualmente l’unico che sembra essere disponibile.

I tre set di dati utilizzati comprendono ciascuno una raccolta del tipo di output che deve essere separato da una colonna sonora: FSD50K è occupato da effetti sonori e presenta 50.000 clip audio mono a 44,1 kHz etichettate con 200 etichette di classe dall’ontologia AudioSet di Google ; il Free Music Archive contiene 100.000 brani stereo che coprono 161 generi musicali, sebbene gli autori abbiano utilizzato un sottoinsieme contenente 25.000 brani, per la parità con FSD50K; e LibriSpeech fornisce a DnR 100 ore di campioni di audiolibri come file audio mp3 a 44,1 kHz.

Lavoro futuro

Gli autori anticipano un ulteriore lavoro sul set di dati e una combinazione dei modelli separati sviluppati per ulteriori ricerche sul riconoscimento vocale e sui quadri di classificazione del suono, con la generazione automatica di didascalie per suoni vocali e non vocali. Intendono anche valutare le possibilità di remixare approcci in grado di ridurre gli artefatti percettivi, che rimane il problema centrale quando si divide una colonna sonora audio unita nei suoi componenti costitutivi.

Questo tipo di separazione potrebbe essere disponibile in futuro come merce di consumo nelle smart TV che incorporano reti di inferenza altamente ottimizzate, anche se sembra probabile che le prime implementazioni richiedano un certo livello di tempo di pre-elaborazione e spazio di archiviazione. Samsung utilizza già le reti neurali locali per l’upscaling, mentre il processore cognitivo XR di Sony , utilizzato nella gamma Bravia dell’azienda, analizza e reinterpreta le colonne sonore dal vivo tramite una leggera intelligenza artificiale integrata.

Le richieste di un maggiore controllo sul mix di una colonna sonora si ripetono periodicamente e la maggior parte delle soluzioni offerte devono fare i conti con il fatto che la colonna sonora è già stata rimbalzata secondo gli standard attuali (e le presunzioni su ciò che gli spettatori vogliono) nel film e industrie televisive.

Uno spettatore, irritato dalla scioccante disparità dei livelli di volume tra i vari elementi delle colonne sonore dei film, è diventato abbastanza disperato da sviluppare un regolatore automatico del volume basato su hardware in grado di equalizzare il volume per film e TV.

Sebbene le smart TV offrano una vasta gamma di metodi per tentare di aumentare il volume dei dialoghi rispetto a livelli di volume grandiosi per la musica, stanno tutti lottando contro le decisioni prese al momento del missaggio e, probabilmente, le visioni dei produttori di contenuti che desiderano che il pubblico sperimenti le loro colonne sonore esattamente come sono state impostate.

I produttori di contenuti sembrano irritarsi contro questa potenziale aggiunta alla “cultura del remix”, dal momento che diversi luminari del settore hanno già espresso malcontento nei confronti degli algoritmi TV di post-elaborazione predefiniti come il livellamento del movimento .