Appello ai ricercatori ML: dai una possibilità alla cura dei dati

La cura dei dati è l’organizzazione e l’integrazione dei dati raccolti da più fonti.

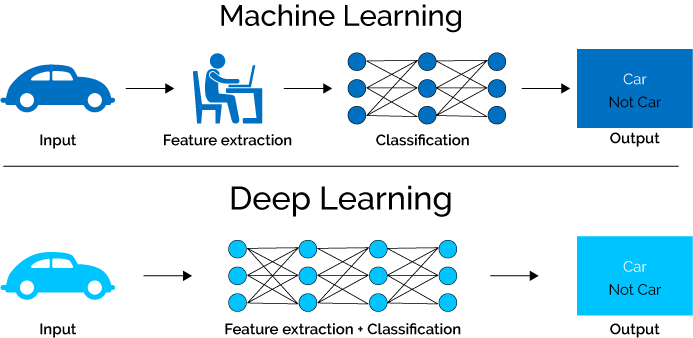

La maggior parte dei ricercatori in PNL dà la priorità allo sviluppo di modelli di deep learning rispetto alla qualità dei dati di formazione. La relativa mancanza di attenzione fa sì che i dati di addestramento raccolgano modelli spuri, pregiudizi sociali e artefatti di annotazione.

Anna Rogers del Center of Social Data Science, Università di Copenhagen, ha recentemente presentato un documento che sottolinea l’importanza di prendersi cura dei dati come primo passo verso la costruzione di modelli di PNL di successo.

La cura dei dati è l’organizzazione e l’integrazione dei dati raccolti da più fonti. Il processo prevede l’autenticazione, l’archiviazione, la gestione, la conservazione per il recupero e la rappresentazione.

Il suo articolo esponeva gli argomenti a favore e contro la cura dei dati.

Perché la cura dei dati è importante

Nel suo articolo, Rogers fornisce i seguenti argomenti a sostegno della cura dei dati:

Pregiudizi sociali : il testo scritto può contenere tutti i tipi di pregiudizi sociali basati su razza, genere, stato sociale, età e abilità. I modelli possono apprendere questi pregiudizi e, quando utilizzati in scenari del mondo reale, possono propagarli e amplificarli ulteriormente. Ciò pone i gruppi di minoranza in uno svantaggio significativo. È imperativo selezionare i dati tenendo conto delle caratteristiche socioculturali e promuovere un’equa rappresentanza di tutti i gruppi sociali.

Privacy : l’utilizzo di informazioni di identificazione personale nei dati di formazione può dar luogo a problemi di privacy e sicurezza. Ad esempio, uno studio ha mostrato che GPT-2 memorizzava le informazioni di contatto personali anche quando apparivano solo su poche pagine web. “Decidere cosa non dovrebbe essere ricordato è chiaramente un problema di cura dei dati”, scrive Rogers.

Sicurezza : il contraddittorio universale fa scattare i modelli di forza per produrre una certa previsione. Fenomeno scoperto di recente, questo effetto incide sui dati di training, compromettendo anche i modelli robusti. La cura dei dati può aiutare a evitare questo attacco.

Metodologia di valutazione : per le attività di PNL , il campione di test proviene dalla stessa distribuzione dei campioni di formazione. C’è la possibilità che i campioni si sovrappongano. La cura è necessaria per garantire che non si verifichino sovrapposizioni.

Progressi verso NLU : con il ridimensionamento rapido, spesso perdiamo traccia dei dati su cui viene addestrato un modello. Senza la cura dei dati, i modelli possono soffrire di uno dei seguenti problemi:

Cadere in preda alle comuni perturbazioni. Ad esempio, fenomeni linguistici come le negazioni.

Apprendimento di schemi spuri nei dati.

Lottando per imparare eventi rari.

Argomenti contro la cura dei dati

Molti esperti ritengono che i dati debbano essere utilizzati nella loro forma naturale per fornire un risultato non verniciato. Sebbene non ci siano problemi con questo argomento, ha detto Rogers, ha bisogno di ulteriori elaborazioni. “In tal caso, la distribuzione “naturale” potrebbe non essere nemmeno quella che vogliamo: ad esempio, se l’obiettivo è un sistema di risposta alle domande, allora la distribuzione “naturale” delle domande poste nella vita quotidiana (con la maggior parte delle domande su tempo e tempo) non essere d’aiuto”, ha scritto Rogers. Ha inoltre aggiunto che c’è ancora molto lavoro di ricerca che deve essere fatto prima che gli sviluppatori possano studiare il mondo così com’è.

Alcuni sviluppatori ritengono che i loro dati siano abbastanza grandi da consentire al loro set di addestramento di comprendere “l’intero universo dei dati”. Rogers ha affermato che la raccolta di tutti i dati è impossibile in quanto porrà sfide legali, etiche e pratiche

Nel frattempo, molti sono favorevoli allo sviluppo di alternative algoritmiche alla cura dei dati. Secondo Rogers, questa è una buona possibilità; tuttavia, disporre di tali soluzioni, nello scenario attuale, potrebbe essere un approccio complementare alla cura dei dati piuttosto che sostituirlo completamente.

Alcuni esperti ritengono che la cura dei dati sia parte del processo e non dovrebbe diventare un compito abbastanza grande da dimenticare lo scopo originale di sviluppare un modello. Anche se gli attuali sistemi di deep learning sono migliori, devono comunque allenarsi all’interno della gamma dei dati di allenamento, ha affermato Rogers.

“Un set di dati perfetto fornirebbe un segnale forte per ogni fenomeno che dovrebbe essere appreso. Non è così che funziona il linguaggio, quindi potremmo non essere mai in grado di creare qualcosa del genere”, ha detto. Sebbene possa essere difficile ottenere soluzioni perfette, è sempre possibile migliorare i modelli.

Curare significa prendere una decisione su cosa includere e cosa escludere. Questo può essere un compito arduo e richiede molta esperienza interdisciplinare, ha detto Rogers.

Avvolgendo

“Vogliamo modelli più robusti e linguisticamente capaci, e vogliamo modelli che non perdano dati sensibili o diffondano stereotipi dannosi. Sia che questi obiettivi possano essere raggiunti in definitiva curando grandi corpora o con soluzioni più algoritmiche, in entrambi i casi dobbiamo fare molto più lavoro sui dati”, scrive Rogers. Per raggiungere questo obiettivo, gli sviluppatori devono superare le tensioni interdisciplinari e promuovere spazi veramente collaborativi.