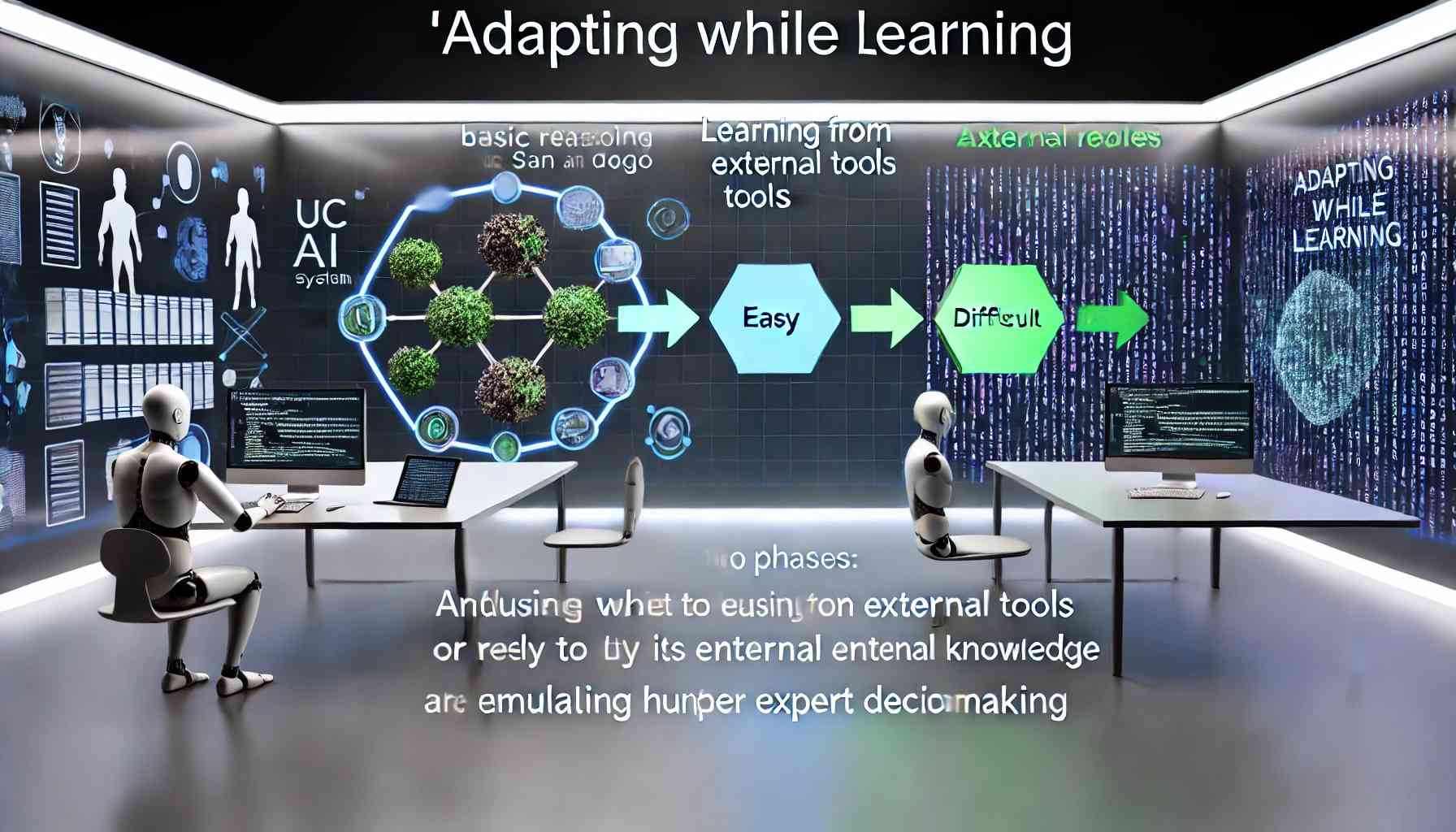

Un team di ricercatori dell’Università della California, San Diego, e dell’Università Tsinghua ha sviluppato un metodo innovativo che migliora significativamente la capacità dell’intelligenza artificiale (IA) di decidere quando utilizzare strumenti esterni rispetto alle proprie conoscenze interne. Questo approccio, denominato “Adapting While Learning”, mira a emulare il processo decisionale degli esperti umani, che valutano la complessità di un problema prima di scegliere la strategia di soluzione più appropriata.

Tradizionalmente, i modelli di linguaggio di grandi dimensioni (LLM) integrano strumenti esterni per aumentare l’affidabilità delle risposte. Tuttavia, questa integrazione può portare a un’eccessiva dipendenza dagli strumenti, riducendo la capacità del modello di risolvere problemi semplici attraverso il ragionamento di base. I ricercatori hanno affrontato questa sfida implementando un processo di apprendimento in due fasi:

- Apprendimento dalle soluzioni generate con strumenti esterni: In questa fase, il modello assimila conoscenze specifiche del dominio attraverso l’uso di strumenti esterni, migliorando la sua comprensione e competenza in aree specializzate.

- Classificazione dei problemi in “facili” o “difficili”: Successivamente, il modello impara a valutare la complessità di un problema e decide se affrontarlo utilizzando le proprie conoscenze interne o ricorrendo a strumenti esterni.

Questo approccio ha portato a risultati notevoli. Utilizzando un modello linguistico con soli 8 miliardi di parametri, significativamente più piccolo rispetto a modelli come GPT-4, i ricercatori hanno ottenuto un miglioramento del 28,18% nell’accuratezza delle risposte e un incremento del 13,89% nella precisione dell’uso degli strumenti su vari set di dati di test. In particolare, il modello ha dimostrato una competenza superiore in compiti scientifici specializzati, superando modelli più grandi in domini specifici.

Questa ricerca mette in discussione l’assunto comune secondo cui modelli di dimensioni maggiori producono risultati migliori. I risultati suggeriscono che insegnare all’IA a discernere quando utilizzare strumenti esterni rispetto alle proprie conoscenze interne può essere più efficace dell’aumento delle dimensioni del modello. Questo approccio non solo migliora l’efficienza computazionale, ma apre anche nuove prospettive per l’applicazione dell’IA in campi scientifici e tecnici, dove la capacità di valutare la complessità dei problemi e scegliere la strategia di soluzione appropriata è fondamentale.

In conclusione, l’integrazione di strategie di apprendimento che emulano il processo decisionale umano rappresenta un passo significativo verso lo sviluppo di sistemi IA più intelligenti e adattabili, capaci di affrontare una gamma più ampia di problemi con maggiore efficacia.