Unity avanza nel settore della robotica con nuove versioni

Unity è una delle piattaforme leader per lo sviluppo e l’utilizzo di contenuti 3D in tempo reale o RT3D. L’azienda ha recentemente annunciato il suo Object Pose Estimation, che mira a migliorare l’industria della robotica, in particolare in ambito industriale, attraverso l’uso di tecnologie di visione artificiale e simulazione.

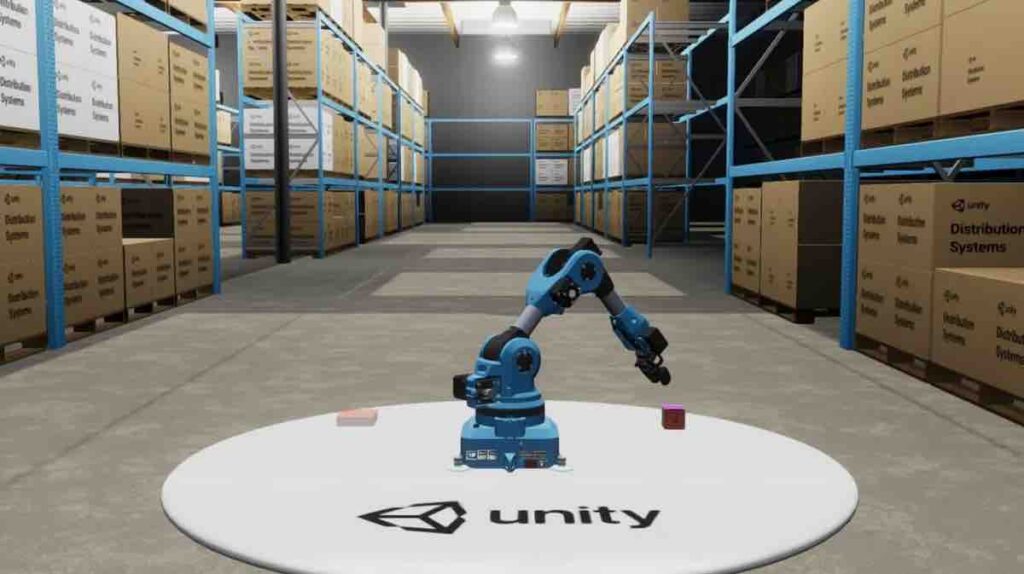

Dimostrazione di posa dell’oggetto

La dimostrazione della posa degli oggetti si è svolta parallelamente a una dimostrazione corrispondente, mostrando come i robot possono apprendere attraverso dati sintetici .

Il dottor Danny Lange è vicepresidente senior dell’intelligenza artificiale presso Unity.

“Questo è un potente esempio di un sistema che impara invece di essere programmato e, poiché apprende dai dati sintetici, è in grado di catturare schemi molto più sfumati di quanto qualsiasi programmatore potrebbe mai fare”, ha detto. “Stratificare le nostre tecnologie insieme mostra come stiamo oltrepassando un limite e stiamo iniziando a occuparci di qualcosa che è veramente AI e, in questo caso, dimostrando le efficienze possibili nell’addestramento dei robot”.

Quando il Dr. Lange si riferisce alla stratificazione delle tecnologie dell’azienda, si riferisce in parte alle recenti versioni di Unity che supportano il Robot Operating System (ROS), che è un framework flessibile per lo sviluppo di software per robot.

Randomizza l’illuminazione in una scena | Unità

Prima del rilascio della demo Object Pose Estimation, Unity ha rilasciato l’URDF Importer dell’azienda, un pacchetto Unity open source, insieme al ROS-TCP-Connector, che mira a ridurre drasticamente la latenza dei messaggi tra i nodi ROS e Unity. Ciò consente al robot che opera in un ambiente simulato di agire quasi in tempo reale.

Spesso si fa affidamento sulla tecnologia di simulazione quando si testano le applicazioni in situazioni pericolose, costose o rare. Utilizzando la simulazione, le applicazioni possono essere convalidate prima di essere distribuite al robot, il che consente il rilevamento precoce di potenziali problemi. Combinando il motore fisico integrato di Unity e Unity Editor, può esserci un numero infinito di ambienti virtuali.

Con la combinazione di questi strumenti, la dimostrazione ha mostrato come è possibile creare grandi quantità di dati di formazione sintetici ed etichettati. È stato quindi utilizzato per addestrare un semplice modello di apprendimento profondo per prevedere la posizione di un cubo. La demo ha fornito un tutorial per coloro che desiderano ricreare il progetto.

“Con Unity, non abbiamo solo democratizzato la creazione di dati, ma abbiamo anche fornito l’accesso a un sistema interattivo per la simulazione di interazioni avanzate in un ambiente virtuale”, ha continuato Lange.

“È possibile sviluppare i sistemi di controllo per un veicolo autonomo, ad esempio, o qui per bracci robotici molto costosi, senza il rischio di danneggiare le apparecchiature o aumentare drasticamente i costi delle installazioni industriali. Essere in grado di dimostrare il rischio delle applicazioni previste in un ambiente virtuale ad alta fedeltà farà risparmiare tempo e denaro a molti settori pronti a essere trasformati dalla robotica combinata con AI e Machine Learning “.