Wu Dao 2.0: la risposta della Cina al GPT-3. Solo meglio

Wu Dao 2.0 mira a consentire alle “macchine” di pensare come “umani” e di raggiungere capacità cognitive oltre il test di Turing.

La Beijing Academy of Artificial Intelligence ( BAAI ), sostenuta dal governo cinese, ha introdotto Wu Dao 2.0, il più grande modello linguistico fino ad oggi, con 1.75 trilioni di parametri. Ha superato in dimensioni GPT-3 di OpenAI e Switch Transformer di Google . HuggingFace DistilBERT e Google GShard sono altri modelli linguistici popolari. Wu Dao significa “illuminazione” in inglese.

“Wu Dao 2.0 mira a consentire alle ‘macchine’ di pensare come ‘umani’ e di raggiungere capacità cognitive oltre il test di Turing”, ha affermato Tang Jie, il ricercatore capo di Wu Dao 2.0. Il test di Turing è un metodo per verificare se un computer può pensare o meno come gli umani.

Il produttore di smartphone Xiaomi, il gigante dei video brevi Kuaishou, il fornitore di servizi on-demand Meituan, oltre 100 scienziati e più organizzazioni hanno collaborato con BAAI a questo progetto.

Il Wu Dao 2.0 è un modello di intelligenza artificiale pre-addestrato che utilizza 1,75 trilioni di parametri per simulare il parlato, scrivere poesie, comprendere immagini e persino generare ricette. Il modello Wu Dao di nuova generazione può anche prevedere le strutture 3D delle proteine, in modo simile ad AlphaFol d di DeepMind e potenziare gli idoli virtuali. Recentemente, il primo studente virtuale della Cina, Hua Zhibing, è stato costruito su Wu Dao 2.0.

Il modello linguistico Wu Dao 2.0 è stato addestrato con FastMoE , un sistema di formazione Fast Mixture-of-Expert (MoE) simile al Mixture of Experts di Google . A differenza del MoE di Google, FastMoE è un sistema open source basato su Pytorch ( il framework open source di Facebook) con acceleratori comuni. Fornisce un’interfaccia gerarchica per la progettazione flessibile del modello e un facile adattamento a varie applicazioni come Transformer-XL e Megatron-LM . Il codice sorgente di FastMoE è disponibile qui .

“[FastMoE] è semplice da usare, ad alte prestazioni, flessibile e supporta la formazione parallela su larga scala”, ha scritto BAAI nel suo blog ufficiale WeChat.

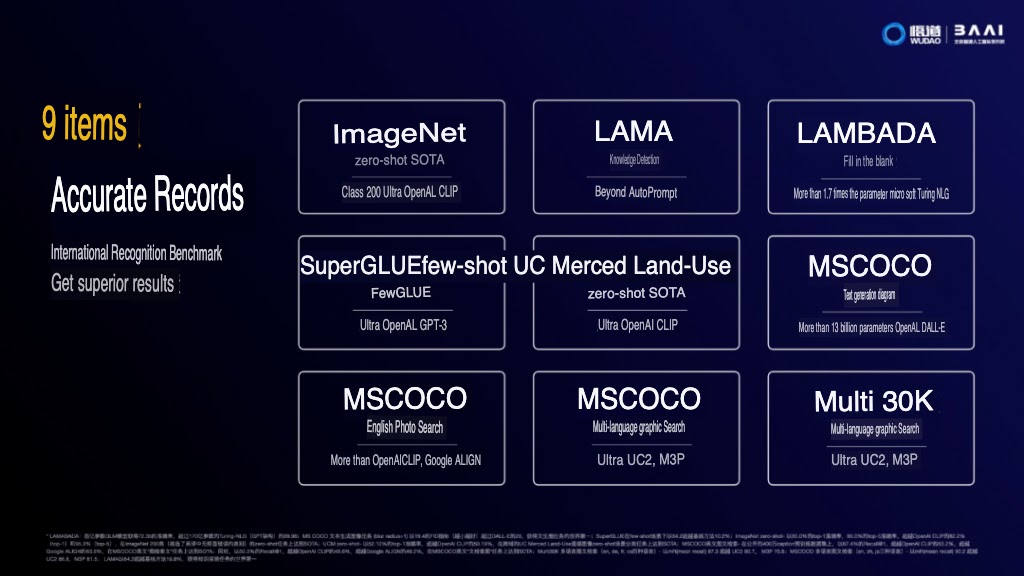

Per quanto riguarda i risultati, Wu Dao 2.0 ha superato i livelli SOTA in nove attività di benchmark, tra cui:

ImageNet (zero-shot) SOTA, supera OpenAI CLIP .

Rilevamento della conoscenza LAMA, più di AutoPrompt

LAMBADA Cloze (a livello di abilità), supera Microsoft Turing NLG

SuperGLUE (pochi brevi), supera OpenAI GPT-3

UC Merced Land-Use (zero-shot) SOTA, supera OpenAI CLIP

MS COCO (diagramma di generazione del testo), supera OpenAI DALL-E

MS COCO (recupero grafico inglese), più di Google ALIGN e OpenAI CLIP

MS COCO (recupero grafico multilingue), supera (l’attuale miglior modello multilingue e multimodale) UC2 , M3P

Multi 30K (recupero grafico multilingue), supera UC2 , M3P

Mostrando attività di benchmark in cui Wu Dao 2.0 supera altri modelli SOTA (Fonte: BAAI)

Verso il modello multimodale

Attualmente, i sistemi di intelligenza artificiale si stanno muovendo verso modelli multimodali e multitasking simili a GPT per ottenere l’intelligenza artificiale generale (AGI). Gli esperti ritengono che nei prossimi mesi ci sarà un aumento dei modelli multimodali. Nel frattempo, alcuni fanno il tifo per l’intelligenza artificiale incorporata , rifiutando del tutto i modelli tradizionali senza corpo, come le reti neurali.

A differenza di GPT-3 , Wu Dao 2.0 copre sia il cinese che l’inglese con competenze acquisite studiando 4,9 terabyte di testi e immagini, inclusi 1,2 terabyte di testi cinesi e inglesi.

Apprendimento automatico VS Apprendimento profondo. Fine del gioco?

Google ha anche lavorato allo sviluppo di un modello multimodale simile a Wu Dao. Al Google I/O 2021, il gigante della ricerca ha presentato modelli linguistici come LaMDA (addestrato su 2,6 miliardi di parametri) e MUM (modello unificato multitasking) addestrato in 75 lingue diverse e 1000 volte più potente di BERT. All’epoca, il CEO di Google Sundar Pichai ha affermato che LaMDA, addestrato solo sul testo, passerà presto a un modello multimodale per integrare testo, immagini, audio e video.

I dati di allenamento di Wu Dao 2.0 includono:

1.2 terabyte di dati di testo in inglese nel set di dati Pile

1,2 terabyte di testo cinese in Wu Dao Corpora

2,5 terabyte di dati grafici cinesi

Blake Yan, un ricercatore di intelligenza artificiale di Pechino, ha dichiarato al South China Morning Post che questi modelli avanzati, addestrati su enormi set di dati, sono bravi a trasferire l’apprendimento, proprio come gli umani. “I ‘modelli pre-addestrati’ su larga scala sono una delle migliori scorciatoie odierne per l’AGI”, ha affermato Yan.

“Nessuno sa quale sia il passo giusto”, ha affermato OpenAI nel suo post sul blog dimostrativo GPT-3 , “Anche se ‘modelli pre-addestrati’ più grandi sono la tendenza logica oggi, potremmo perdere la foresta per gli alberi e noi potrebbe finire per raggiungere in futuro un massimale meno determinato. L’unico aspetto chiaro è che se il mondo deve subire ” danni ambientali ” , ” pregiudizi dannosi ” o ” costi economici elevati “, non varrebbe nemmeno la pena di raggiungere l’AGI”.