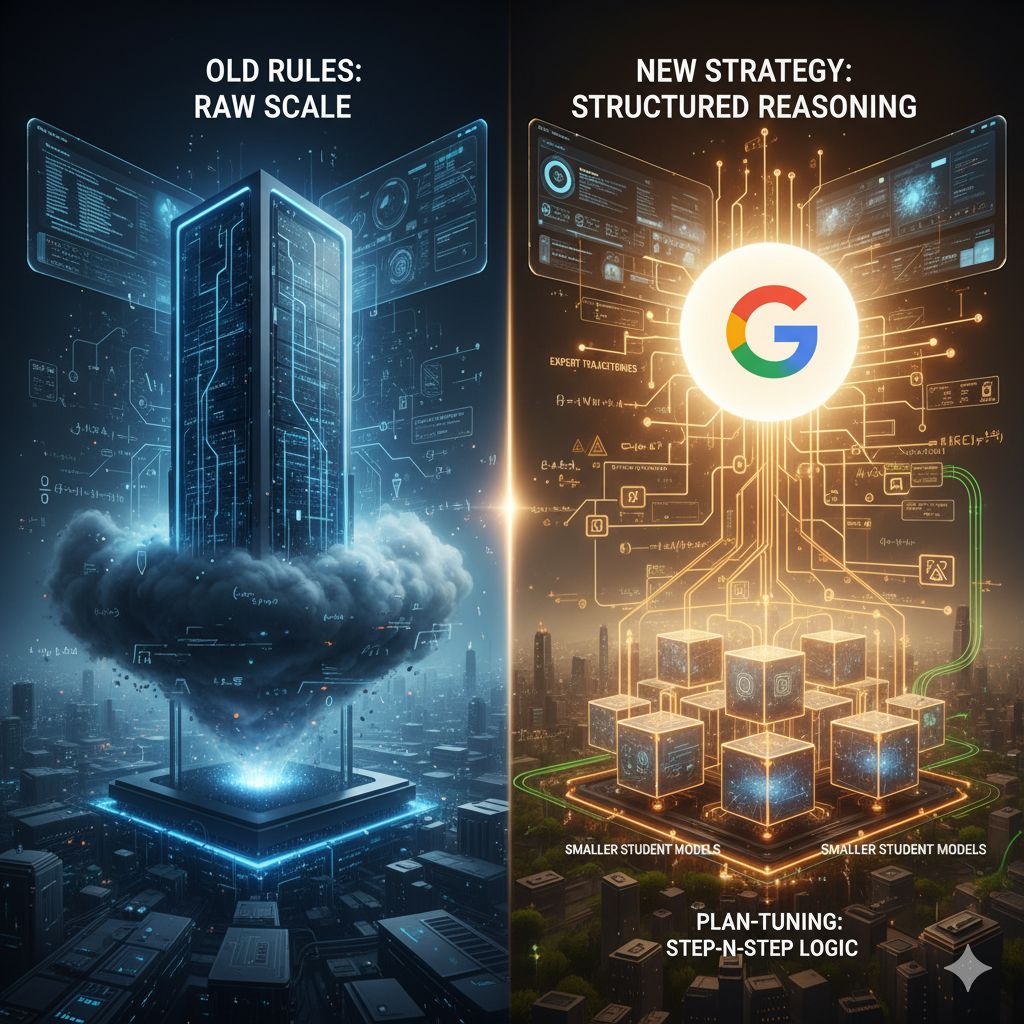

Per anni, l’evoluzione dell’Intelligenza Artificiale Generativa è stata dominata da un paradigma quasi monolitico: per ottenere capacità di ragionamento avanzate, risolvere problemi complessi e gestire compiti in più fasi, la risposta sembrava essere una sola: scalare. La corsa ai miliardi di parametri ha prodotto modelli linguistici giganteschi, veri e propri titani computazionali capaci di meraviglie, ma vincolati da un’enorme impronta energetica e da costi di addestramento e inferenza proibitivi. Questi “giganti” dell’IA hanno alzato l’asticella delle prestazioni, ma hanno anche creato un imbuto, riservando le capacità più sofisticate, come il ragionamento chain-of-thought, a chi disponeva di risorse illimitate.

Google, in collaborazione con istituti accademici, sta ora proponendo un cambio di rotta concettuale che mira a democratizzare il ragionamento complesso, dimostrando che l’intelligenza non è esclusivamente una funzione della dimensione bruta. Il cuore di questa nuova strategia risiede in una metodologia di addestramento innovativa, che potremmo definire come “Addestramento Strutturato al Ragionamento” (conosciuto in diverse formulazioni come Supervised Reinforcement Learning o Plan-Tuning), ideata per insegnare ai modelli più piccoli a pensare per gradi, proprio come farebbe un umano.

La sfida fondamentale per i modelli compatti è sempre stata quella di mancare della profondità e del volume di parametri necessari per emulare i processi di ragionamento multi-step. Mentre un modello immenso può, in virtù della sua scala, internalizzare complessi schemi logici, un modello ridotto tende ad affidarsi a una risposta immediata, spesso inefficace per problemi che richiedono una scomposizione logica.

La nuova metodologia di Google supera questa limitazione ridefinendo il processo di apprendimento. Invece di limitarsi a esporre il modello “studente” a una massa di dati non strutturati o a risposte finali, si introduce un modello “insegnante” di grandi dimensioni, che agisce come mentore. Questo modello più potente viene incaricato di scomporre problemi complessi — che spaziano dalla matematica avanzata all’ingegneria del software agente — in una sequenza chiara e logica di passaggi intermedi, note come “traiettorie esperte”.

Queste traiettorie, che rappresentano un ragionamento passo-passo, vengono poi filtrate e curate per eliminare le inesattezze. Sono queste sequenze di azioni logiche, e non solo la risposta finale, a diventare il curriculum didattico per il modello più piccolo. L’addestramento avviene in un ciclo virtuoso che combina l’apprendimento supervisionato (imitando i passaggi dell’insegnante) e l’apprendimento per rinforzo (premiando ogni singolo passo logico corretto), fornendo un segnale di apprendimento denso e granulare. In sostanza, il modello piccolo non impara solo la risposta, ma impara il processo che porta alla risposta.

Questa focalizzazione sulla struttura del ragionamento ha implicazioni profonde. In primo luogo, permette ai modelli con un numero significativamente inferiore di parametri di affrontare benchmark di ragionamento che in precedenza erano appannaggio esclusivo dei loro cugini giganti. Le dimostrazioni sperimentali, specialmente nei test di matematica e logica, mostrano miglioramenti sostanziali e una marcata riduzione degli errori comuni, come l’uso errato di formule. Il modello piccolo acquisisce un’abilità di pianificazione sistematica anziché affidarsi a una mera predizione statistica.

In secondo luogo, e forse ancora più importante per l’adozione su larga scala, questa efficienza introduce il concetto di sostenibilità nell’IA avanzata. Modelli più piccoli significano minori costi computazionali, un’esecuzione più rapida e la possibilità di implementazione su dispositivi con risorse limitate o in ambienti edge. Questo non solo rende l’IA avanzata più accessibile a startup e aziende con budget contenuti, ma riduce anche l’impatto ambientale complessivo del ciclo di vita dell’IA.

Infine, l’approccio Plan-Tuning dimostra una migliore generalizzazione. Insegnando ai modelli i principi strutturali del ragionamento, si fornisce loro un toolkit logico che può essere applicato a problemi out-of-distribution, ossia a compiti che non sono strettamente rappresentati nei dati di addestramento iniziali. Questa resilienza e adattabilità sono vitali per gli agenti autonomi che devono operare in contesti dinamici e inaspettati.