Negli ultimi anni, con l’adozione sempre più massiccia dei modelli di linguaggio di grandi dimensioni (LLM) nelle applicazioni di intelligenza artificiale, molte aziende si sono trovate di fronte a una sorpresa poco gradita: pur senza un aumento proporzionale del traffico utente, il conto mensile delle API per gli LLM continuava a crescere in modo sostenuto, arrivando a cifre inaspettate e difficili da giustificare nel bilancio operativo. Questo fenomeno è stato osservato dal team tecnico che ha scritto un recente approfondimento per VentureBeat, in cui si spiega come la vera causa di quei costi esorbitanti non fosse tanto il volume di richieste, ma piuttosto la natura delle richieste stesse e la loro ripetitività.

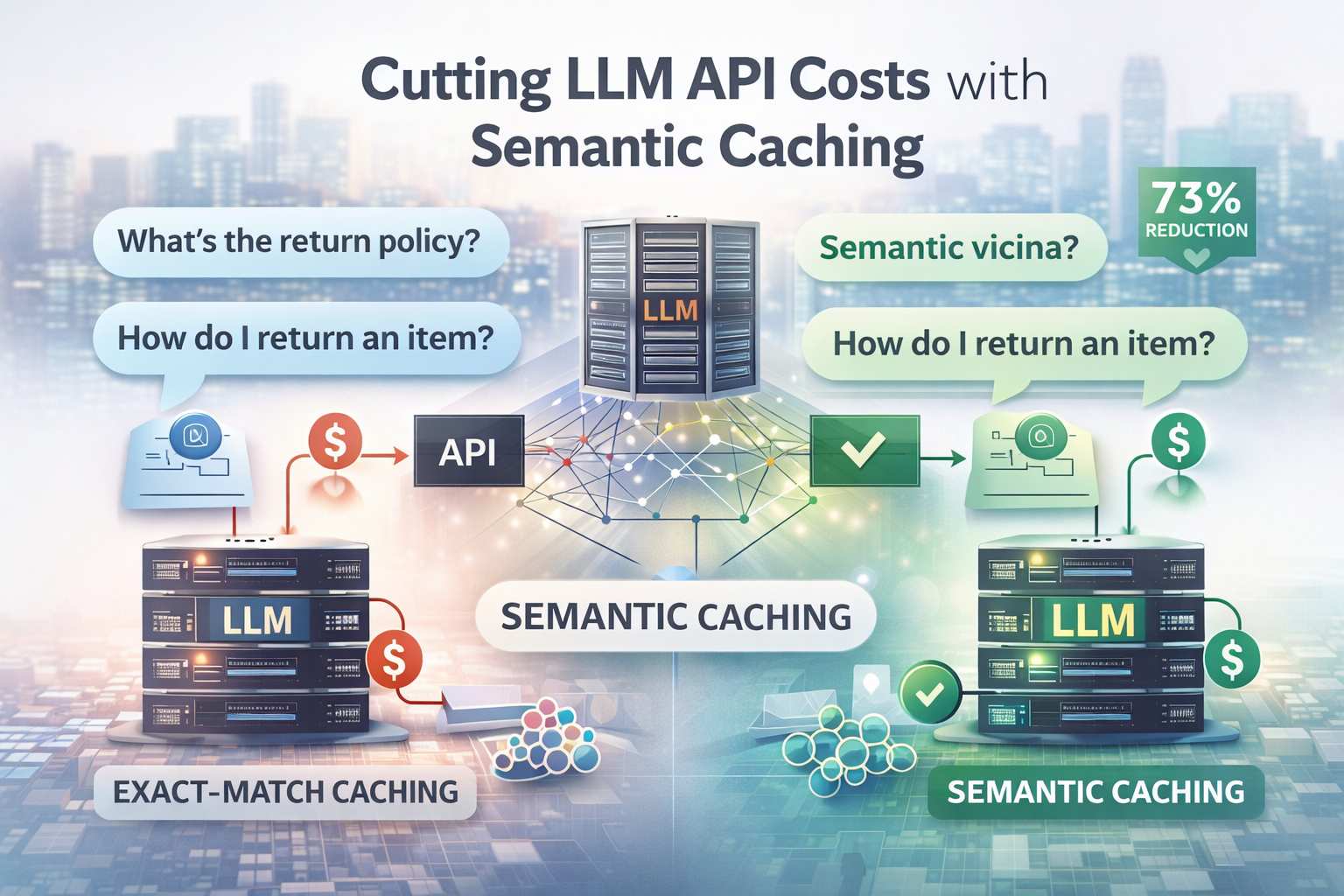

Il problema nasce dal modo in cui i sistemi tradizionali gestiscono le richieste agli LLM. La prima idea di ottimizzazione, che molte aziende implementano istintivamente, è quella del caching exact-match: si memorizzano le risposte già generate per richieste identiche in modo da poterle servire nuovamente senza dover ri-chiamare il modello. Tuttavia, questo approccio si rivela ben presto insufficiente perché nella pratica le richieste degli utenti raramente sono identiche nella forma. Due domande che hanno lo stesso significato, come “Qual è la politica di reso?” e “Come posso restituire un articolo?”, verranno considerate completamente differenti da una cache tradizionale, e quindi genereranno due chiamate distinte al modello, con costi pienamente applicati.

Analizzando i log di query, infatti, gli sviluppatori hanno constatato che solo una piccola percentuale delle richieste era esattamente identica a precedenti, mentre una quota significativa – quasi la metà – era semanticamente simile, cioè esprimeva lo stesso intento con parole diverse. Questo tipo di ripetizione “mascherata” dalla differenza di formulazione è stato responsabile della maggior parte delle chiamate ridondanti ai modelli, che hanno drenato budget senza produrre un reale valore aggiunto rispetto alle risposte già note.

La soluzione proposta per affrontare questa inefficienza è il caching semantico, una tecnica più sofisticata di gestione della cache che si basa non sul testo esatto della richiesta, ma sul suo significato. In pratica, ogni nuova query viene trasformata in un vettore numerico mediante un modello di embedding, e la cache non memorizza più semplici stringhe testuali ma queste rappresentazioni semantiche. Quando arriva una nuova richiesta, il sistema confronta il vettore della query con quelli già presenti nella cache per verificare se esiste una richiesta semanticamente vicina, ovvero con significato molto simile. Se viene trovata una corrispondenza oltre una certa soglia di somiglianza, la risposta precedentemente generata può essere riutilizzata, evitando così una nuova chiamata all’LLM.

Questa semplice ma potente variazione di paradigma ha un impatto enorme sui costi operativi. Nel caso descritto nell’articolo di VentureBeat, l’adozione del caching semantico ha portato il tasso di cache hit – cioè la percentuale di richieste soddisfatte direttamente dalla cache senza accedere al modello – a circa il 67%. Questo si è tradotto in una riduzione dei costi API per gli LLM di circa il 73%, una cifra sorprendente soprattutto alla scala di grandi applicazioni in produzione.

È importante notare che implementare correttamente il caching semantico comporta alcune sfide. La definizione della soglia di somiglianza “giusta” tra vettori è cruciale: se è troppo alta, si perdono potenziali risparmi perché poche richieste vengono considerate simili; se è troppo bassa, si rischia di servire risposte inappropriate perché associ troppo liberamente query diverse. Per questo gli ingegneri dedicano tempo all’analisi di precisione e richiamo sui loro dati per calibrare queste soglie in base alla tipologia di richiesta e al livello di accuratezza desiderato.

Oltre alla componente semantica, è altrettanto importante considerare come e quando invalidare le risposte memorizzate: certi contenuti cambiano nel tempo e rispondere con informazioni obsolete può essere dannoso per l’esperienza utente. Strategie di invalidazione basate su tempo di vita (TTL), eventi di aggiornamento dei dati o rilevamento di “staleness” sono tutte tecniche che aiutano a mantenere in cache solo risposte pertinenti e affidabili.

Dal punto di vista dell’esperienza utente, il caching semantico non solo riduce i costi, ma spesso migliora anche le prestazioni percepite: servire una risposta direttamente dalla cache è di gran lunga più veloce rispetto all’attesa di una nuova generazione da parte dell’LLM, che può richiedere tempo di elaborazione aggiuntivo. Questo doppio beneficio di efficienza economica e reattività operativa rende la tecnica particolarmente attraente per team e aziende che gestiscono alta intensità di richieste o applicazioni in tempo reale.