Quando si tratta di diagnosticare il cancro al cervello, le biopsie sono spesso il primo punto di riferimento. I chirurghi iniziano rimuovendo un sottile strato di tessuto dal tumore ed esaminandolo al microscopio, cercando da vicino i segni della malattia. Tuttavia, non solo le biopsie sono altamente invasive, ma i campioni ottenuti rappresentano solo una frazione del sito complessivo del tumore. La risonanza magnetica offre un approccio meno intrusivo, ma i radiologi devono delineare manualmente l’area del tumore dalla scansione prima di poterla classificare, il che richiede molto tempo.

Recentemente, scienziati statunitensi hanno sviluppato un modello in grado di classificare numerosi tipi di tumore intracranico senza la necessità di un bisturi. Il modello, chiamato rete neurale convoluzionale (CNN), utilizza il deep learning, un tipo di algoritmo di apprendimento automatico presente nei software di riconoscimento delle immagini, per riconoscere questi tumori nelle immagini RM, in base a caratteristiche gerarchiche come la posizione e la morfologia. La CNN del team potrebbe classificare con precisione diversi tumori cerebrali senza interazione manuale.

“Questa rete è il primo passo verso lo sviluppo di un flusso di lavoro di radiologia potenziato dall’intelligenza artificiale in grado di supportare l’interpretazione delle immagini fornendo informazioni quantitative e statistiche”, afferma il primo autore Satrajit Chakrabarty.

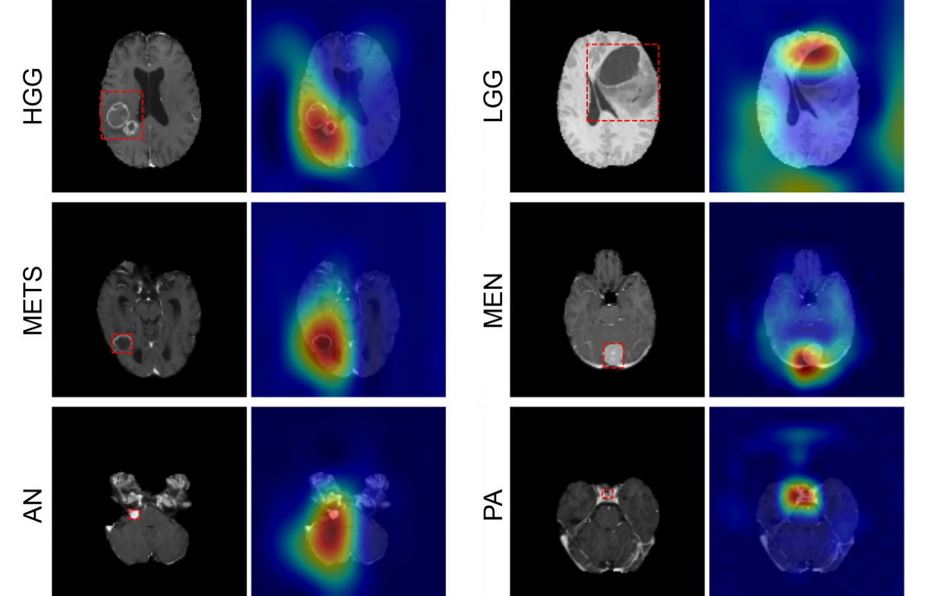

La CNN è in grado di rilevare sei tipi comuni di tumore intracranico: gliomi di alto e basso grado, meningioma, adenoma ipofisario, neuroma acustico e metastasi cerebrali. Scrivendo in Radiology: Artificial Intelligence, il team – guidato da Aristeidis Sotiras e Daniel Marcus della Washington University School of Medicine (WUSM) – afferma che questa rete neurale è la prima a determinare direttamente la classe del tumore, oltre a rilevare l’assenza di un tumore , da un volume di risonanza magnetica 3D.

Per accertare l’accuratezza della loro CNN, i ricercatori hanno creato due set di dati multi-istituzionali di scansioni MRI pre-operatorie e post-contrasto da quattro database disponibili pubblicamente, insieme ai dati ottenuti presso il WUSM.

Il primo, il set di dati interno, conteneva 1757 scansioni in sette classi di imaging: le sei classi tumorali e una classe sana. Di queste scansioni, 1396 erano dati di addestramento, che il team ha usato per insegnare alla CNN come discriminare tra ogni classe. I restanti 361 sono stati successivamente utilizzati per testare le prestazioni del modello (dati di test interni).

La CNN ha identificato correttamente il tipo di tumore con una precisione del 93,35%, come confermato dai referti radiologici associati a ciascuna scansione. Inoltre, la probabilità che un paziente avesse effettivamente il cancro specifico rilevato dalla CNN (piuttosto che essere sano o avere qualsiasi altro tipo di tumore) era dell’85-100%.

Sono stati osservati pochi falsi negativi in tutte le classi di imaging; la probabilità che i pazienti risultati negativi per una data classe non avessero quella malattia (o non fossero sani) era del 98-100%.

Successivamente, i ricercatori hanno testato il loro modello rispetto a un secondo set di dati esterno contenente solo gliomi di alto e basso grado. Queste scansioni sono state ottenute separatamente da quelle nel set di dati interno.

“Poiché i modelli di deep learning sono molto sensibili ai dati, è diventato standard convalidare le loro prestazioni su un set di dati indipendente, ottenuto da una fonte completamente diversa, per vedere quanto bene generalizzano [reagiscono ai dati non visti]”, spiega Chakrabarty.

La CNN ha dimostrato una buona capacità di generalizzazione, segnando un’accuratezza del 91,95% sui dati dei test esterni. I risultati suggeriscono che il modello potrebbe aiutare i medici a diagnosticare i pazienti con i sei tipi di tumore studiati. Tuttavia, i ricercatori notano diverse limitazioni al loro modello, inclusa la classificazione errata del tipo e del grado di tumore a causa del contrasto dell’immagine scarso. Queste carenze possono essere causate da incongruenze nei protocolli di imaging utilizzati nelle cinque istituzioni.

Guardando al futuro, il team spera di formare ulteriormente la CNN incorporando ulteriori tipi di tumore e modalità di imaging.