Andrew Ng, una delle voci più influenti nel machine learning dell’ultimo decennio, sta attualmente esprimendo preoccupazioni sulla misura in cui il settore enfatizza le innovazioni nell’architettura del modello rispetto ai dati e, in particolare, la misura in cui consente ai risultati “ overfitting ” di essere rappresentato come soluzioni o progressi generalizzati.

Si tratta di critiche radicali all’attuale cultura dell’apprendimento automatico, emanate da una delle sue più alte autorità, e hanno implicazioni per la fiducia in un settore afflitto dai timori per un terzo crollo della fiducia delle imprese nello sviluppo dell’IA in uno spazio di sessant’anni.

Ng, professore all’università di Stanford, è anche uno dei fondatori di deeplearning.ai, ea marzo ha pubblicato una missiva sul sito dell’organizzazione che riassumeva un suo discorso recente fino a un paio di raccomandazioni fondamentali:

In primo luogo, la comunità di ricerca dovrebbe smetterla di lamentarsi del fatto che la pulizia dei dati rappresenta l’80% delle sfide nell’apprendimento automatico e andare avanti con il lavoro di sviluppo di metodologie e pratiche MLOps robuste.

In secondo luogo, dovrebbe allontanarsi dalle “vittorie facili” che possono essere ottenute adattando eccessivamente i dati a un modello di apprendimento automatico, in modo che funzioni bene su quel modello ma non riesca a generalizzare o a produrre un modello ampiamente distribuibile.

Accettare la sfida dell’architettura e della cura dei dati

“Il mio punto di vista”, ha scritto Ng. “è che se l’80% del nostro lavoro è la preparazione dei dati, garantire la qualità dei dati è il lavoro importante di un team di machine learning.”

Lui continua:

“Piuttosto che contare sugli ingegneri per cercare il modo migliore per migliorare un set di dati, spero che possiamo sviluppare strumenti MLOps che aiutano a rendere la creazione di sistemi di intelligenza artificiale, inclusa la creazione di set di dati di alta qualità, più ripetibili e sistematici.

‘MLOps è un campo nascente e persone diverse lo definiscono in modo diverso. Ma penso che il principio organizzativo più importante dei team e degli strumenti di MLOps dovrebbe essere quello di garantire un flusso di dati coerente e di alta qualità in tutte le fasi di un progetto. Questo aiuterà molti progetti ad andare più agevolmente. ‘

Intervenendo su Zoom in una sessione di domande e risposte in streaming alla fine di aprile, Ng ha affrontato la carenza di applicabilità nei sistemi di analisi dell’apprendimento automatico per la radiologia:

“Si scopre che quando raccogliamo dati dallo Stanford Hospital, poi ci alleniamo e testiamo sui dati dello stesso ospedale, infatti, possiamo pubblicare articoli che dimostrano che [gli algoritmi] sono paragonabili ai radiologi umani nell’individuare determinate condizioni.

“… [Quando] porti lo stesso modello, lo stesso sistema di intelligenza artificiale, in un vecchio ospedale in fondo alla strada, con una macchina più vecchia, e il tecnico usa un protocollo di imaging leggermente diverso, i dati vanno alla deriva per degradare in modo significativo. Al contrario, qualsiasi radiologo umano può camminare per strada fino all’ospedale più vecchio e stare bene “.

La sotto-specifica non è una soluzione

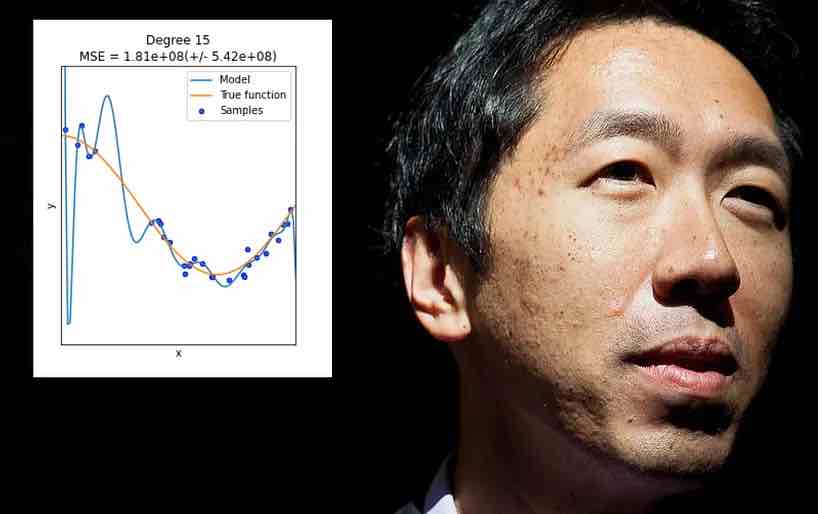

L’overfitting si verifica quando un modello di apprendimento automatico è progettato specificamente per adattarsi alle eccentricità di un particolare set di dati (o al modo in cui i dati vengono formattati). Ciò può comportare, ad esempio, la specifica di pesi che produrranno buoni risultati da quel set di dati, ma non “generalizzeranno” su altri dati.

In molti casi, tali parametri sono definiti su aspetti “non dati” del set di addestramento, come la risoluzione specifica delle informazioni raccolte o altre idiosincrasie che non è garantito che si ripetano in altri set di dati successivi.

Anche se sarebbe bello, l’overfitting non è un problema che può essere risolto ampliando ciecamente l’ambito o la flessibilità dell’architettura dei dati o della progettazione del modello, quando ciò che è effettivamente necessario sono caratteristiche ampiamente applicabili e altamente salienti che funzioneranno bene su una vasta gamma di dati ambienti – una sfida più spinosa.

In generale, questo tipo di “sotto-specifica” porta solo agli stessi problemi che Ng ha recentemente delineato, in cui un modello di apprendimento automatico fallisce su dati invisibili. La differenza in questo caso è che il modello non riesce non perché i dati o la formattazione dei dati sono diversi dal set di addestramento originale sovradimensionato, ma perché il modello è troppo flessibile piuttosto che troppo fragile.

Verso la fine del 2020 il documento Underspecification Presents Challenges for Credibility in Modern Machine Learning ha sollevato intense critiche contro questa pratica e portava i nomi di non meno di quaranta ricercatori e scienziati di machine learning di Google e MIT, tra le altre istituzioni.

Il documento critica “l’apprendimento con scorciatoie” e osserva il modo in cui i modelli sotto specificati possono decollare a tangenti selvagge in base al punto di partenza casuale in cui inizia l’addestramento del modello. I contributori osservano:

“Abbiamo visto che la sottospecificazione è onnipresente nelle pratiche pipeline di machine learning in molti domini. In effetti, grazie alla sottospecificazione, aspetti sostanzialmente importanti delle decisioni sono determinati da scelte arbitrarie come il seme casuale utilizzato per l’inizializzazione dei parametri. “

Ramificazioni economiche del cambiamento della cultura

Nonostante le sue credenziali accademiche, Ng non è un accademico arioso, ma ha una profonda esperienza nel settore di alto livello come co-fondatore di Google Brain e Coursera, come ex capo scienziato per Big Data e AI a Baidu e come fondatore di Landing AI , che amministra $ 175 milioni di dollari per le nuove startup del settore.

Quando afferma che “Tutta l’IA, non solo l’assistenza sanitaria, ha un divario tra la prova del concetto e la produzione”, è inteso come un campanello d’allarme per un settore il cui attuale livello di campagna pubblicitaria e un investimento imprenditoriale incerto a lungo termine, afflitto da problemi di definizione e portata.

Tuttavia, i sistemi di apprendimento automatico proprietari che funzionano bene in situ e falliscono in altri ambienti rappresentano il tipo di cattura del mercato che potrebbe premiare gli investimenti del settore. Presentare il “problema dell’overfitting” nel contesto di un rischio professionale offre un modo falso per monetizzare gli investimenti aziendali nella ricerca open source e per produrre sistemi proprietari (efficacemente) in cui la replica da parte dei concorrenti è possibile, ma problematica.

Se questo approccio funzionerà o meno a lungo termine dipende dalla misura in cui i progressi reali nell’apprendimento automatico continuano a richiedere livelli di investimento sempre maggiori e se tutte le iniziative produttive migreranno inevitabilmente a FAANG in una certa misura, a causa di le colossali risorse necessarie per l’hosting e le operazioni.