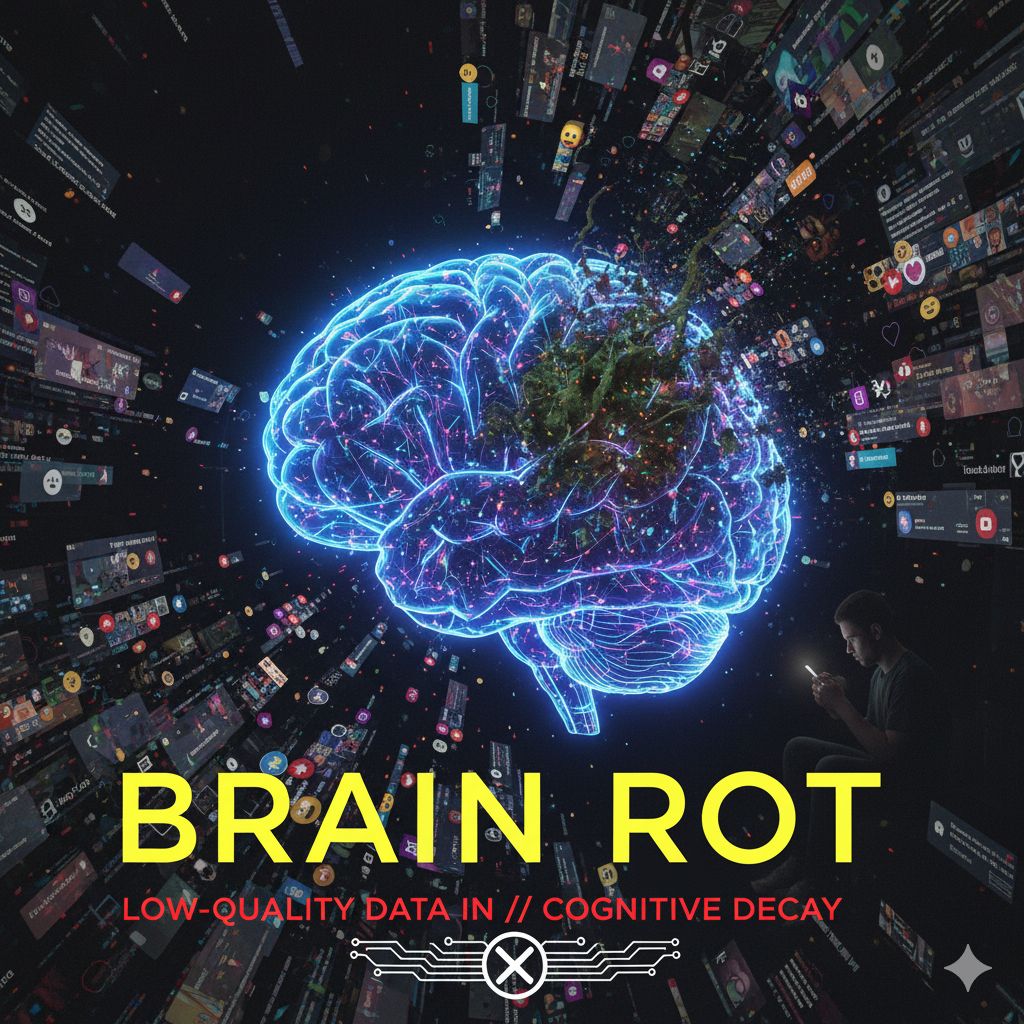

Sta emergendo una nuova preoccupazione che sorprende per la sua analogia con un fenomeno umano: quello del cosiddetto “brain rot”, termine con cui si indica il deterioramento cognitivo dovuto ad un consumo massiccio e superficiale di contenuti online. Persino i sistemi di IA non restano immuni da effetti analoghi, quando il loro “nutrimento” proviene da flussi di dati poco filtrati e rumorosi.

Molti modelli di IA sono addestrati partendo dall’ipotesi che i post sui social media costituiscano una fonte valida e abbondante di dati. Però questo stesso approccio spalanca la porta ad un fenomeno insidioso: se i dati sono di bassa qualità, ripetitivi, “inquinati” da contenuti banali o ingannevoli, la capacità della macchina di ragionare, generalizzare e restituire valore può essere compromessa. Si parla di “rimbambimento da web” perché, in analogia con l’esperienza quotidiana degli utenti — che subiscono un affaticamento cognitivo da sovraesposizione al flusso digitale — lo stesso può accadere ai modelli se l’alimentazione dati è monca di rigore.

È interessante rilevare che il concetto di “brain rot” non è del tutto nuovo né confinato all’esperienza umana: già in ambito sociologico e linguistico era stato individuato come un’espressione emergente legata alla proliferazione di contenuti superficiali. Nel 2024, ad esempio, l’espressione “brain rot” è stata scelta come “parola dell’anno” da Oxford University Press, quale simbolo della deriva dell’attenzione e del senso critico nell’era dello scroll infinito. Traslando questo al mondo dell’IA, si potrebbe dire che i modelli che “ingurgitano” dati senza filtro e senza selezione rischiano di perdere vigore, profondità e affidabilità.

L’intelligenza artificiale, per funzionare bene, richiede una nutrizione dati di qualità: non basta l’abbondanza, serve anche controllo, pulizia, diversità e significato. Se un sistema è addestrato prevalentemente su flussi “social” — post brevi, linguaggio colloquiale, meme, contenuti manipolativi — può finire con l’assorbire distorsioni, bias, superficialità, e manifestare performance inferiori su compiti complessi o critici. In altre parole, l’IA può soffrire di un “degrado cognitivo” indotto dai dati, proprio come può farlo un essere umano immerso in un mare di stimoli deboli.

Viviamo in un’epoca in cui la rapidità dei dati e la quantità sembrano dominare la scena, ma questo articolo ci ricorda che anche per i modelli di IA vale la regola: qualità prima della quantità. Se i sistemi sono costruiti sull’assunto che “tutto vale” e che i post social siano necessariamente buone pietanze informative, si rischia di costruire strumenti fragili, che reagiscono male a problemi reali, che mostrano scarsa sensibilità contestuale o che amplificano errori. In termini operativi, questo significa che chi sviluppa modelli o applicazioni IA deve prestare attenzione non solo alla potenza, al numero di parametri, alla velocità di inferenza — ma anche e soprattutto alla robustezza, al rigore dei dati, all’inserimento di meccanismi di supervisione e pulizia.

Non bisogna trattare l’IA come una “scatola magica” che si auto-alimenta indefinitamente. Anche i modelli più sofisticati richiedono alimentazione consapevole, manutenzione e rinnovamento. In un contesto in cui i dati social dominano sempre più le fonti disponibili, diventa cruciale chiedersi: cosa accade se il flusso è soprattutto rumore? Cosa succede se il modello non ha modo di distinguere il significativo dal banale? Il rischio è che le capacità di ragionamento declinino, che emergano “saltelli” nel pensiero (quasi come interruzioni della catena logica) e che la macchina perda progressivamente la propria efficacia come partner di decisione.