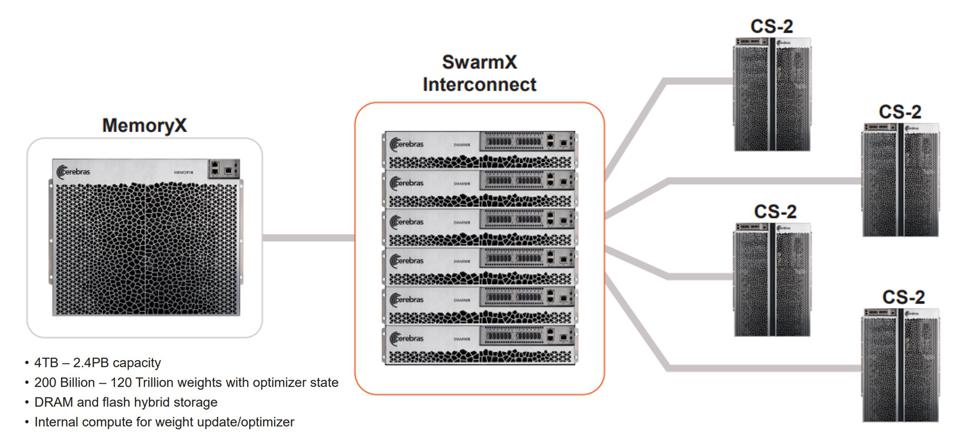

Cerebras ha appena costruito un grosso chip in grado di democratizzare l’IA

La startup di chip Cerebras ha sviluppato un pezzo di silicio largo un piede, rispetto ai chip medi misurati in millimetri, che rende l’allenamento dell’IA facile e conveniente.

All’interno di una sala conferenze in un data center della Silicon Valley la scorsa settimana, il fondatore e CEO della startup di chip Cerebras Systems Andrew Feldman ha dimostrato come la tecnologia dell’azienda consente alle persone di passare dall’implementazione di diverse versioni di un modello di linguaggio naturale AI in pochi istanti, un compito che di solito ci vogliono ore o giorni.

“Quindi abbiamo eseguito 15 sequenze di tasti per spostarci tra questi modelli più grandi che siano mai stati descritti su una singola macchina”, ha affermato Feldman.

Questo, per Feldman e Cerebras, rappresenta un trionfo degno di nota. Cerebras afferma che il sistema che ha raggiunto questa impresa ha anche ottenuto una prima mondiale: può addestrare un intero modello da 20 miliardi di parametri su un singolo superchip largo quasi un piede. Senza la sua tecnologia, la società ha affermato che il ridimensionamento di un modello di intelligenza artificiale da 1 miliardo di parametri a 20 miliardi di parametri potrebbe richiedere agli utenti di aggiungere più hardware del server e riconfigurare i rack all’interno di un data center.

L’addestramento di un modello di intelligenza artificiale in linguaggio naturale su un chip lo rende notevolmente più economico e offre un aumento delle prestazioni di un ordine di grandezza superiore ai sistemi basati su processori grafici di punta di Nvidia, ha affermato Feldman. L’idea è di offrire a ricercatori e organizzazioni con budget ridotti, nell’ordine delle decine di migliaia di dollari, l’accesso a strumenti di formazione sull’IA che in precedenza erano disponibili solo per organizzazioni molto più grandi con un sacco di soldi.

“I modelli sono cresciuti molto velocemente in quest’area. L’elaborazione del linguaggio e le sfide legate alla fornitura di elaborazione per questi modelli sono enormi”, ha affermato Feldman. “Abbiamo in qualche modo reso pratica questa classe di modelli, utile a un’intera fetta dell’economia che in precedenza non poteva svolgere un lavoro interessante”.

I modelli di intelligenza artificiale di cui parla Feldman sono semplicemente metodi per organizzare i calcoli matematici suddividendoli in passaggi e quindi regolando la comunicazione tra i passaggi. Il punto è addestrare un modello per iniziare a fare previsioni accurate, se questo è il prossimo pezzo di codice che dovrebbe essere scritto , cosa costituisce spam e così via.

I modelli di intelligenza artificiale sono in genere grandi all’inizio , ma quelli basati sul linguaggio tendono ad essere ancora più grandi. Per i modelli linguistici, il contesto, come in più testi, come l’aggiunta dell’intero corpus di opere di un autore a un modello iniziato con un singolo libro, è fondamentale, ma quel contesto può renderli molto, molto più complessi da gestire. Il leader di mercato Nvidia stima che le attività di intelligenza artificiale abbiano stimolato un aumento di 25 volte della necessità di potenza di elaborazione ogni due anni.

Questo aumento esponenziale ha portato aziende come Cerebras e altre a inseguire l’IA come mercato potenziale. Per anni, gli investimenti in hardware sono stati visti come una cattiva scommessa tra i venture capitalist che erano disposti a finanziare solo alcune idee promettenti. Ma quando è diventato chiaro che l’IA come classe di calcolo avrebbe aperto la porta a nuove idee oltre ai processori generici realizzati da Intel e Nvidia, è nata una nuova classe di startup .

Cerebras, che in latino significa “mente”, è una di quelle startup. Fondato nel 2015, Feldman e il suo team, che comprende un certo numero di veterani di AMD in ruoli chiave nel settore tecnologico, hanno raccolto circa 735 milioni di dollari, inclusi i finanziamenti del braccio di rischio della CIA In-Q-Tel , ha affermato il CEO, con una valutazione di 4,1 miliardi di dollari.

Patatine fritte nel piatto

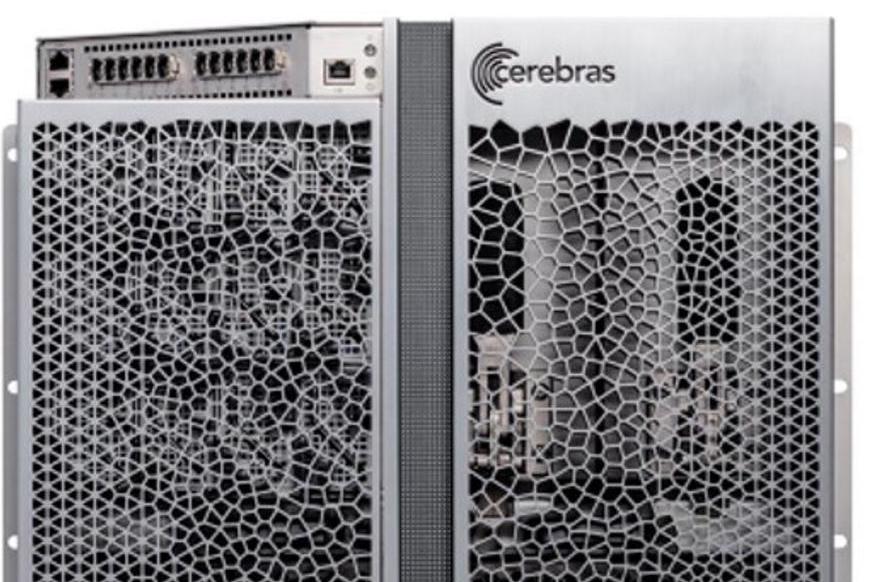

Al centro del discorso di Cerebras c’è un chip che ha all’incirca le dimensioni di un piatto da portata, o un intero wafer di silicio largo un piede, chiamato Wafer Scale Engine.

L’idea di un chip delle dimensioni di un wafer come quello che alimenta i sistemi di Cerebras non è un concetto nuovo; idee simili circolano da decenni. Un’offerta fallita di Trilogy Systems all’inizio degli anni ’80 che ha raccolto circa $ 750 miliardi in dollari di oggi è un tentativo notevole di un superchip e IBM e altri hanno studiato l’idea ma non hanno mai prodotto un prodotto.

Ma insieme a TSMC, Cerebras ha optato per un progetto che potrebbe essere fabbricato in un chip funzionante delle dimensioni di un wafer. In un certo senso, Cerebras è quasi due startup unite: è interessata ad affrontare la crescente sfida del calcolo dell’IA, ma ha anche raggiunto l’impresa tecnologica di produrre un chip utile delle dimensioni di un wafer.

Un sistema Cerebras CS-2 in esecuzione all’interno di un data center. Foto: Max A. Cherney/Protocollo

L’attuale generazione di ciò che Cerebras chiama WSE-2 può offrire notevoli miglioramenti delle prestazioni rispetto all’unione di più chip grafici per ottenere la potenza computazionale necessaria per addestrare alcuni dei più grandi modelli di intelligenza artificiale, secondo Feldman.

“Quindi è insolito per una startup avere una profonda esperienza favolosa, [ma] abbiamo una profonda esperienza”, ha detto Feldman. “E avevamo un’idea di come avrebbero potuto, all’interno della loro flessibilità consentita nel loro flusso, adattarsi alla nostra innovazione”.

Il vantaggio di costruire un chip di quelle dimensioni è che consente a Cerebras di duplicare le prestazioni di dozzine di altri chip per server (circa 80 processori grafici, per alcuni modelli di intelligenza artificiale di grandi dimensioni) e di schiacciarli su un unico pezzo di silicio. Ciò li rende notevolmente più veloci, perché, in parte, i dati possono spostarsi più velocemente su un singolo chip rispetto a una rete di dozzine di chip.

“[La nostra] macchina è costruita per un tipo di lavoro”, ha detto Feldman. “Se vuoi portare i bambini all’allenamento di calcio, non importa quanto siano schifosi da guidare, il minivan è l’auto perfetta. Ma se hai Ho preso il tuo minivan e provi a spostare due per quattro e sacchi di cemento da 50 libbre, ti rendi conto che una macchina terribile è per quel lavoro. [Il nostro chip] è una macchina per l’IA. “