Google rilascia Tensorflow 3D. Che cos’è esattamente?

TensorFlow fornisce una serie di operazioni, funzione di perdita, strumenti di elaborazione dati, metriche e altri modelli per lo sviluppo, l’addestramento e l’implementazione di modelli di comprensione della scena 3D all’avanguardia.

L’apprendimento per rinforzo profondo funziona davvero per la robotica?

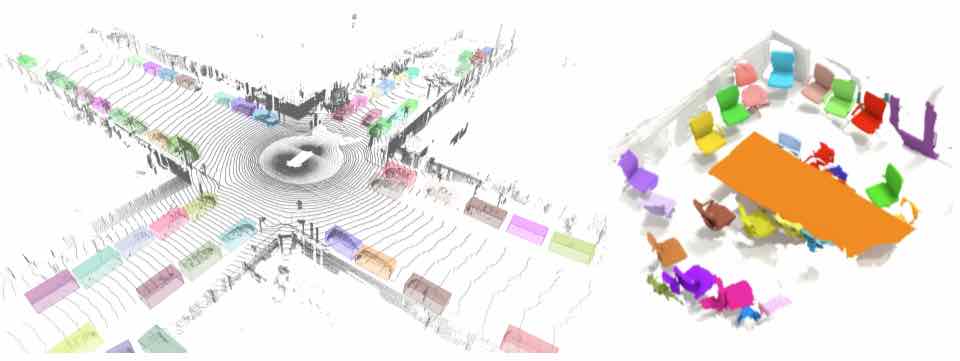

Veicoli autonomi, robot e altri sistemi di apprendimento ML devono controllare l’ambiente circostante per navigare e operare nel mondo reale. Sono spesso guidati da sensori 3D come Lidar, radar e telecamere di rilevamento della profondità e utilizzano la tecnologia di comprensione della scena per elaborare i dati acquisiti da questi dispositivi.

La comprensione della scena 3D è fondamentale per il rilevamento di oggetti, la comprensione incentrata sull’uomo e la grafica. Sebbene la visione artificiale abbia compiuto progressi significativi attraverso il rilevamento di oggetti 3D mobili e il rilevamento di oggetti trasparenti, il numero di strumenti che possono essere applicati ai dati 3D è ancora limitato.

Per migliorare la comprensione delle scene 3D, Google ha ora sviluppato TensorFlow 3D, una libreria altamente modulare per portare funzionalità di deep learning 3D a TensorFlow.

Che cos’è la comprensione della scena 3D?

Gli attuali sistemi di visione artificiale raccontano solo un po ‘della posizione di un oggetto in uno spazio 3D e di come interagiscono agenti come i robot. Questo non è sufficiente per comprendere completamente l’ambiente. Ricerche recenti si sono concentrate sull’ottenimento di una comprensione geometrica della scena per superare questa lacuna. Al contrario di catturare una rappresentazione sul piano dell’immagine degli oggetti, la loro rappresentazione così come esistono nel mondo 3D aiuta in applicazioni come la comprensione incentrata sull’uomo, la grafica e il rilevamento di oggetti.

La nuova libreria di TensorFlow fornisce una serie di operazioni, funzioni di perdita, strumenti di elaborazione dati, metriche e altri modelli per lo sviluppo, l’addestramento e la distribuzione di modelli di comprensione della scena 3D all’avanguardia.

Evidenziare:

Per l’addestramento e la valutazione di set di dati per la comprensione di scene 3D standard, TF 3D offre specifiche e configurazione di set di dati unificati.

Supporta set di dati come Waymo Open, ScanNet e Rio. Gli utenti possono anche convertire altri set di dati come Kitti e NuScenes e utilizzarli come al solito.

TF 3D può essere utilizzato per diversi tipi di ricerca di apprendimento profondo 3D come la prototipazione rapida e la distribuzione di sistemi di inferenza in tempo reale.

Attualmente, TF 3D supporta tre pipeline:

Segmentazione semantica 3D: i dati 3D acquisiti contengono spazio aperto a parte l’insieme di oggetti di interesse. Poiché la maggior parte dei dati 3D sono scarsi, l’applicazione dell’implementazione standard delle convoluzioni è impegnativa dal punto di vista computazionale e richiede un ampio spazio di memoria.

Per ovviare a questo problema, TF 3D utilizza la convoluzione sparsa di sottovarietà per elaborare i dati sparsi 3D in modo più efficiente. Utilizza l’architettura U-Net per estrarre le funzionalità da ogni voxel. La rete U-Net contiene blocchi di convoluzione sparsi con operazioni di pooling e un-pooling. Inoltre, il modello utilizza varie tecniche CUDA per velocizzare i calcoli come hashing, partizionamento e operazioni sui bit.

Le reti convoluzionali sparse della sottovarietà vengono applicate su un modello di segmentazione semantica 3D , che genera una base di punteggio semantico per voxel. I punteggi possono essere mappati per prevedere l’etichetta semantica per punto.

Segmentazione dell’istanza 3D : oltre a prevedere la semantica, è fondamentale raggruppare i voxel che appartengono allo stesso oggetto. Qui i vettori di incorporamento dell’istanza mappano i voxel a uno spazio di incorporamento. In questo spazio, i voxel della stessa istanza di oggetto vengono posizionati insieme, mentre quelli corrispondenti a oggetti diversi vengono tenuti distanti. Durante il processo di inferenza, il modello utilizza l’algoritmo greedy per selezionare un’istanza alla volta per raggrupparli in segmenti in base alla distanza tra gli incorporamenti voxel.

Rilevamento di oggetti 3D: il modello per il rilevamento di oggetti 3D determina parametri quali dimensione del voxel, centro, matrici di rotazione e punteggi semantici degli oggetti. Inoltre, per comprimere centinaia di migliaia di previsioni box per voxel in poche proposte box, viene utilizzato un meccanismo di proposta box. Al momento dell’addestramento, la previsione della scatola e le perdite di classificazione vengono applicate alle previsioni per voxel. In particolare, viene utilizzata una perdita di classificazione dinamica della scatola che classifica una scatola che si sovrappone alla verità fondamentale come positiva e altre come negative.