Secondo quanto riportato, è emerso un nuovo concetto di classifica LLM, dove gli esseri umani identificano e classificano direttamente le prestazioni dei modelli linguistici di grandi dimensioni, a differenza dei tradizionali benchmark.

La NBC ha riferito che la classifica LLM chiamata “Chatbot Arena” ha recentemente guadagnato popolarità. Questa classifica è stata creata dal gruppo di ricerca universitario aperto chiamato “Large Model Systems Organization” ed è un metodo per valutare direttamente i modelli di intelligenza artificiale attraverso il voto umano.

Il metodo è semplice: sulla pagina di votazione compaiono i modelli A e B senza rivelare i loro nomi. Quando viene posta una domanda tramite un prompt, entrambi i modelli danno le risposte contemporaneamente. Gli utenti confrontano i risultati e votano per quello che considerano migliore. Questo metodo è un tipo di “crowd sourcing” in stile “blind test”.

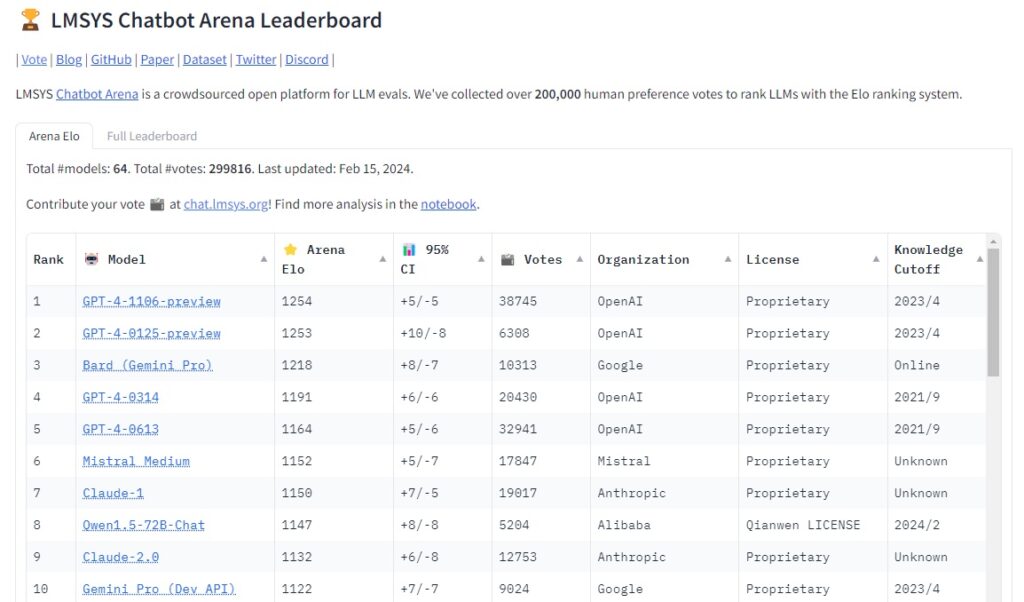

Dal lancio l’anno scorso, il numero di voti ha superato i 300.000 e attualmente il modello al primo posto è il “GPT-4 Turbo” di OpenAI. Le prime posizioni sono state occupate principalmente da varianti di “GPT-4”, con l’eccezione del “Gemini Pro (3° posto)” di Google.

Anche modelli open source come Mistral, Claude, Q1 e Yi-34B sono stati inclusi tra i primi 20. Rispetto alla classifica Hugging Face, che considerava solo i modelli open source, in questa classifica sono stati inclusi molti più modelli popolari. Tuttavia, la classifica Hugging Face aveva caricato 64 modelli entro il 12° posto, con “Solar” di Upstage al 32° posto.

Questa classifica è stata creata per affrontare le limitazioni della classifica Hugging Face, che spesso si basa su set di dati pubblici datati, facilitando agli sviluppatori LLM il raggiungimento di punteggi elevati al momento del rilascio.

Inoltre, non esisteva un metodo generale per valutare se un chatbot rispecchiasse effettivamente le esigenze degli utenti umani, al di là dei sette elementi valutati dai benchmark tradizionali.

Secondo il creatore di Chatbot Arena, il traffico verso il sito è aumentato significativamente in meno di un anno dall’inizio della classifica, con migliaia di voti espressi al giorno e richieste di aggiungere nuovi modelli alla piattaforma.

Tuttavia, ci sono ancora alcuni problemi da risolvere. Ying Xing, co-creatore del sito e studente di dottorato presso la School of Computer Science della Stanford University, ha notato che le classifiche dell’Arena non sono cambiate molto e che c’è spazio per migliorare il metodo di classificazione. Weilin Xiang, dottorando in informatica presso l’UC Berkeley, ha menzionato l’implementazione di un algoritmo per rilevare comportamenti dannosi durante la scrittura dei prompt.

Gli esperti sottolineano che i benchmark, sia tradizionali che umani, non sono un metodo completo di valutazione delle prestazioni, ma sono utili per stimolare l’innovazione nell’intelligenza artificiale e mantenere alti standard di prestazione.