NeRF si avvicina di un altro passo alla sostituzione della CGI

I ricercatori del MIT e di Google hanno compiuto un grande passo avanti nella risoluzione di uno degli ostacoli più fondamentali per una tecnologia emergente basata sull’intelligenza artificiale che potrebbe eventualmente sostituire la CGI, separando le immagini del campo di radianza neurale (NeRF) nelle sue componenti visive costitutive, in modo che le immagini possano essere nuovamente strutturato e riacceso.

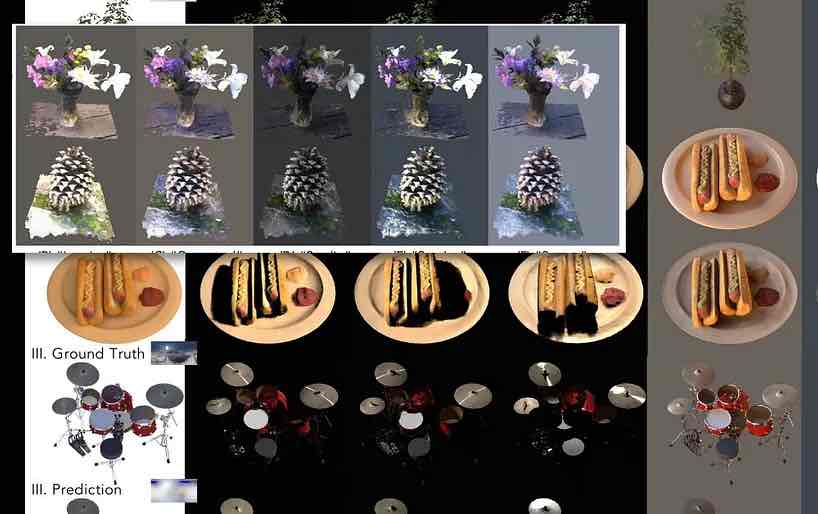

Il nuovo approccio, chiamato NeRFactor , divide efficacemente le immagini catturate in normali per oggetto (su cui è possibile assegnare le trame), visibilità della luce, albedo (la proporzione di luce accidentale che viene riflessa da una superficie) e funzioni di distribuzione della riflettanza bidirezionale (BRDF) .

Con queste sfaccettature isolate, è possibile non solo cambiare trame per singoli oggetti o gruppi di oggetti, ma anche aggiungere nuove e uniche fonti di illuminazione e implementazioni di ombre, escludendo quelle catturate dagli array multi-camera che generano input per le immagini NeRF.

Il modello supporta ombre morbide o dure da fonti di illuminazione arbitrarie definite dall’utente e separa i quattro aspetti del video acquisito in modo programmatico, utilizzando una perdita di ricostruzione, dati da calcoli precedenti di BRDF e una semplice regolarizzazione di uniformità di base.

NeRFactor utilizza una sonda di luce HDR, un approccio consolidato che ha pervaso la scena visiva industriale e artistica sin dalla sua introduzione nel 1998, per valutare i possibili percorsi dei raggi, che consente un’illuminazione arbitraria. Poiché questo genera un numero ingovernabile di possibili parametri, la sonda luminosa viene filtrata attraverso un percettrone multistrato (MLP), che mappa la geometria percepita sulla sonda senza tentare di calcolare una mappa completa del volume di illuminazione per lo spazio modello.

Due modelli di campo di radianza neurale vengono utilizzati per dimostrare cinque modelli di illuminazione possibili in NeRFactor. Fare clic sull’immagine per una risoluzione maggiore.

Motivo di riflessione

La nuova ricerca è forse la più significativa nel separare gli strati di immagini catturate che controllano la riflessione. Questa rimane una delle maggiori sfide per le immagini del campo di radianza neurale, dal momento che un sistema NeRF veramente nuovo e flessibile dovrà non solo essere in grado di sostituire le trame, ma soprattutto avrà bisogno di un modo per riflettere gli oggetti in movimento (oltre solo all’ambiente fisso generale) che normalmente verrebbe preso in considerazione in un flusso di lavoro CGI.

Questo problema è stato notato di recente in relazione alla nuova impressionante ricerca di Intel sulla trasformazione di filmati di videogiochi in video fotorealistici tramite reti neurali convoluzionali. In tali flussi di lavoro, molti aspetti “cotti” del materiale sorgente dovrebbero diventare discreti e intercambiabili, e questo è probabilmente più facile da risolvere per la riilluminazione (che è una funzione della geometria che viene resa in NeRF) che per le riflessioni (che utilizzano ‘ geometria “fuori campo” che è completamente al di fuori dell’ambito del modello).

Pertanto, isolare gli strati nel video NeRF che facilitano la riflessione porta NeRF un passo più vicino alla risoluzione della sua “sfida di riflessione”.

NeRFactor: fattorizzazione neurale di forma e riflettanza sotto un’illuminazione sconosciuta

L’uso di un ambiente HDR risolve già il problema della generazione di riflessioni ambientali del mondo (cioè cieli, paesaggi e altri fattori ambientali “fissi”), ma saranno necessari nuovi approcci per introdurre riflessioni in movimento e dinamiche.

Fotogrammetria con NeRF

Le immagini di Neural Radiance Field utilizzano l’ analisi dell’apprendimento automatico per sviluppare uno spazio completamente volumetrico da una scena o da un oggetto che è stato catturato da diverse angolazioni.

Vari schemi basati su NeRF emersi nell’ultimo anno hanno utilizzato un numero diversificato di dispositivi fotocamera contribuenti; alcuni usano 16 o più fotocamere, altri solo una o due. In tutti i casi, i punti di vista intermedi sono “riempiti” (cioè interpretati) in modo che la scena o l’oggetto possano essere navigati in modo fluido.

L’entità risultante è uno spazio completamente volumetrico, con una comprensione 3D intrinseca che può essere sfruttata in molti modi, inclusa la capacità di generare mesh CG tradizionali dalla somma analizzata in 3D delle immagini di input.

NeRF nel contesto di una “nuova CGI”

Le immagini del campo di radianza neurale sono tratte direttamente dalle immagini del mondo reale, comprese le immagini in movimento di persone, oggetti e scene. Al contrario, una metodologia CGI “studia” e interpreta il mondo, richiedendo a lavoratori qualificati di costruire reti, rig e trame che fanno uso di immagini del mondo reale (es. acquisizioni facciali e ambientali). Rimane un approccio essenzialmente interpretativo e artigianale, costoso e laborioso.

Inoltre, la CGI ha avuto problemi in corso con l’effetto “valle perturbante” nei suoi sforzi per ricreare le sembianze umane, che non presenta alcun vincolo a un approccio basato su NeRF, che cattura semplicemente video o immagini di persone reali e lo manipola.

Inoltre, NeRF può generare la tradizionale geometria mesh in stile CGI direttamente dalle foto, se necessario, e in effetti soppiantare molte delle procedure manuali che sono sempre state necessarie nelle immagini generate al computer.

Sfide per NeRF

Quest’ultima ricerca del MIT e di Google arriva nel contesto di una vera e propria ondata di documenti NeRF nell’ultimo anno, molti dei quali hanno offerto soluzioni alle varie sfide lanciate dal documento iniziale del 2020.

Ad aprile, l’innovazione di un consorzio di ricerca cinese ha fornito un modo per isolare in modo discreto le singole linee temporali delle sfaccettature in una scena NeRF, comprese le persone.

La ricerca cinese consente agli utenti finali di copiare, incollare e ridimensionare gli elementi catturati, districandoli dalla linea temporale lineare del video sorgente originale. Fonte: https://www.youtube.com/watch?v=Wp4HfOwFGP4

Questo approccio non solo consente di reimmaginare la scena da qualsiasi angolazione catturata dall’array di telecamere (e non solo la singola vista rappresentata in una tipica acquisizione video), ma consente anche un compositing versatile e persino la capacità di rappresentare due aspetti dello stesso filmati che vengono eseguiti nei loro intervalli di tempo individuali (o anche in esecuzione all’indietro, se necessario).

La ricerca cinese consente agli utenti finali di copiare, incollare e ridimensionare gli elementi catturati, districandoli dalla linea temporale lineare del video sorgente originale. Fonte: https://www.youtube.com/watch?v=Wp4HfOwFGP4

Una delle maggiori sfide per NeRF è ridurre le considerevoli risorse necessarie per addestrare una scena, e questo è stato affrontato in una serie di articoli recenti. Ad esempio, il Max Planck Institute for Intelligent Systems ha recentemente introdotto KiloNeRF , che non solo accelera i tempi di rendering di un fattore 1000, ma consente anche a NeRF di operare in modo interattivo.

KiloNeRF esegue un ambiente interattivo a 50 fps su una GTX 1080ti. Fonte: https://github.com/creiser/kilonerf

Tuttavia, l’innovazione della velocità NeRF che ha davvero catturato l’immaginazione dei ricercatori e del pubblico nel 2021 è stata la collaborazione PlenOctrees , guidata da UC Berkeley, che offre il rendering in tempo reale dei campi di radianza neurale:

PlenOctree per il rendering in tempo reale dei campi di radianza neurale

L’effetto delle capacità interattive di PlenOctree è stato riprodotto in un’interfaccia live basata sul web .

Inoltre, Recursive-NeRF (da un documento del maggio 2021 dei ricercatori della Tsinghua University) offre un rendering ricorsivo di alta qualità su richiesta. Invece di obbligare l’utente a eseguire il rendering di intere scene, comprese le parti che potrebbero non essere viste, Recursive-NeRF fornisce qualcosa di simile alla compressione con perdita di JPEG e può generare sub-NeRF discreti per gestire immagini extra su richiesta, ottenendo un enorme risparmio di risorse computazionali .

Altri approcci includono FastNeRF , che afferma di ottenere un rendering neurale ad alta fedeltà a 200 fps.

È stato notato che molte delle tecniche di ottimizzazione per NeRF comportano la “cottura” della scena , impegnandosi su aspetti che si desidera visualizzare e scartando altri aspetti, il che limita l’esplorazione ma accelera notevolmente l’interattività.

Il rovescio della medaglia è che lo stress si sposta dalla GPU allo storage, perché le scene cotte occupano una quantità eccessiva di spazio su disco; in una certa misura, ciò può essere mitigato mediante il downsampling dei dati elaborati, sebbene ciò comporti anche un certo impegno, in termini di chiusura delle vie di esplorazione o interattività.

Per quanto riguarda il motion capture e il rigging, un nuovo approccio delle università di Zheijang e Cornell, rivelato a maggio , ha offerto un metodo per ricreare esseri umani animabili utilizzando campi di peso misto e strutture scheletriche interpretate dal video di input:

Quando NeRF avrà il suo momento “Jurassic Park”?

Nonostante il rapido progresso con la sintesi di immagini tramite campi di radianza neurale, è solo in questo periodo che verrà stabilita qualsiasi tipo di “legge della termodinamica” su come il NeRF può diventare dispiegabile. In termini di una linea temporale analoga alla storia della CGI, NeRF si aggira attualmente intorno al 1973, poco prima del primo utilizzo della CGI in Westworld .

Ciò non significa che NeRF dovrà necessariamente aspettare nove anni per il suo equivalente traguardo di Wrath Of Khan , o decenni per le simili scoperte che la CGI ha ottenuto sotto l’entusiastico patrocinio di James Cameron in The Abyss del 1989 o Terminator 2 del 1991 – e poi, la tecnologia è davvero momento di rottura rivoluzionario in Jurassic Park del 1993 .

La scena dell’immagine è cambiata molto dal lungo periodo di stagnazione per gli effetti visivi fotochimici, che ha dominato la produzione cinematografica e televisiva dalla nascita del cinema ai primi anni ’90. L’avvento della rivoluzione del PC e l’accelerazione della legge di Moore hanno portato alla rivoluzione della CGI, che altrimenti avrebbe potuto avere luogo già negli anni ’60.

Resta da vedere se esiste una barriera così implacabile da poter sostenere i progressi di NeRF per così tanto tempo – e se le successive innovazioni nella visione artificiale non potrebbero nel frattempo superare completamente NeRF come concorrente chiave per la corona della CGI, caratterizzando i campi di radianza neurale come la “macchina fax” di breve durata della sintesi delle immagini neurali.

Finora, NeRF non è stato utilizzato in nessun contesto al di fuori della ricerca accademica; ma è interessante notare che i principali attori come Google Research e molti dei più importanti laboratori di ricerca sulla visione artificiale sono in competizione per l’ultima svolta NeRF.

Molti dei maggiori ostacoli di NeRF hanno iniziato ad essere affrontati direttamente quest’anno; se la ricerca successiva offre una soluzione al “problema della riflessione” e i molti filoni della ricerca sull’ottimizzazione di NeRF si fondono in una soluzione decisiva per le considerevoli esigenze di elaborazione e/o archiviazione della tecnologia, NeRF ha davvero la possibilità di diventare “la nuova ‘ nei prossimi cinque anni.