Robert Playter, CEO di Boston Dynamics, ha evidenziato in un’intervista con Lex Fridman che per essere veramente utili in futuro, i robot devono poter gestire l’incertezza e affrontare situazioni impreviste. Questa capacità è fondamentale per un robot multiuso, ma rappresenta una sfida notevole.

Boston Dynamics, che ha iniziato lo sviluppo di robot generici all’inizio degli anni 2000 e ha introdotto il suo primo modello umanoide, Atlas, nel 2013, ha affrontato numerose difficoltà, inclusa la ricerca di investimenti e l’addestramento dei robot.

L’addestramento tramite simulazione è la tecnica più adottata per preparare i robot all’ambiente reale. In questi ambienti virtuali, si sviluppano, testano e perfezionano gli algoritmi che permettono ai robot di imitare le condizioni reali. “La simulazione è particolarmente efficace per compiti come camminare o fare salti mortali all’indietro, dove è cruciale mantenere l’equilibrio del robot,” ha affermato Mankaran Singh, fondatore di Flow Drive, azienda produttrice di veicoli autonomi.

Tuttavia, per compiti che possono essere appresi tramite imitazione, come piegare le camicie, non è necessario un ambiente simulato, come sottolinea Gokul NA, fondatore di CynLr Robotics. Quest’ultimo ha anche evidenziato che esistono ancora molte sfide legate alla percezione e all’intuizione che mancano nei robot e che dovrebbero essere sviluppate per renderli più autonomi.

Isaac Sim di NVIDIA, basato su Omniverse, è una piattaforma di simulazione che offre un ambiente virtuale per la progettazione, il test e l’addestramento dei robot AI. Tuttavia, Gokul ha sottolineato che, anche utilizzando strumenti avanzati come Omniverse, si incontrano limitazioni quando i robot vengono trasferiti nel mondo reale. “Quando si passa da un presupposto simulato alla realtà, i robot falliscono perché hanno imparato in modo errato o incompleto,” ha aggiunto.

Il metodo dell’apprendimento per imitazione, in cui un utente dimostra un’attività al robot, ha anch’esso i suoi limiti. Ad esempio, se un robot viene addestrato a riconoscere solo tazze bianche, non sarà in grado di identificarne di altri colori.

Gokul ritiene che lo sviluppo attuale dei bracci robotici sia troppo focalizzato su “macchine per la registrazione e la riproduzione” che mancano di percezione. “In molti casi commerciali non sono necessarie le gambe; le ruote sono sufficienti, ma ciò che serve veramente è maggiore abilità manuale,” ha detto, riferendosi agli umanoidi in sviluppo.

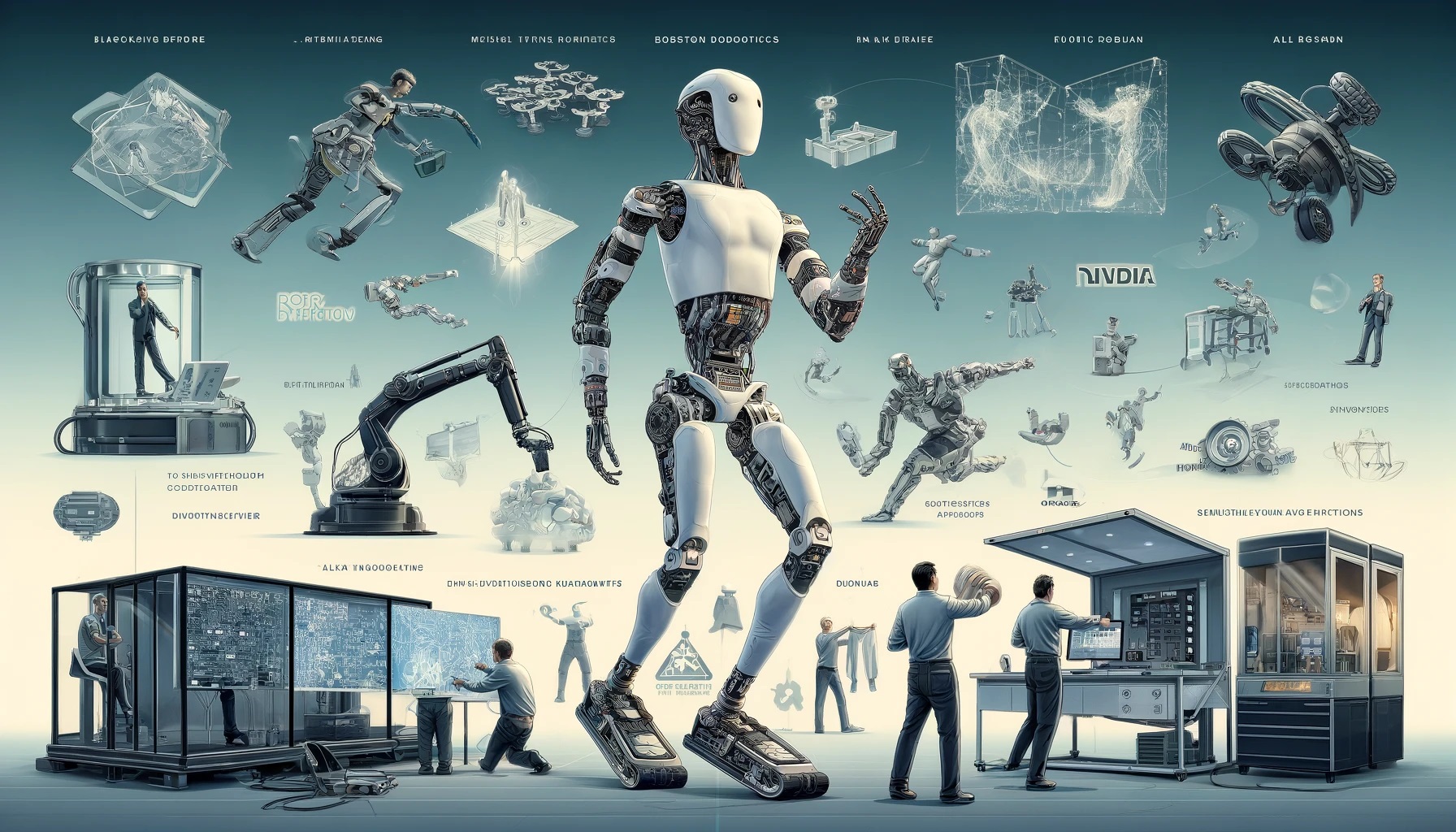

Con il 2024 definito l’anno della robotica, molte aziende, tra cui Figure AI, Tesla, UniTree, e Aptronix, si stanno concentrando sugli umanoidi, mentre Google DeepMind e altri stanno lavorando su robot basati su bracci per svolgere funzioni multiple.

NVIDIA, attraverso il suo modello di base generico per robot umanoidi GR00T e la piattaforma AI Omniverse, sta guidando un’intensa attività di investimento nel campo. Questo approccio ha l’obiettivo di comprendere il linguaggio naturale e imitare i movimenti umani, spiegato da Jensen Huang, CEO di NVIDIA, al GTC 2024.

Oltre a NVIDIA, altre aziende, come Physical Intelligence supportata da OpenAI, stanno avanzando nello sviluppo dell’intelligenza artificiale per applicazioni nel mondo fisico, dimostrando l’ampio impegno verso l’evoluzione della robotica.