COSA SPIEGABILE AI NON PUÒ SPIEGARE E COSA SI PUÒ FARE

L’efficacia di un modello di apprendimento automatico è spesso compromessa dalla sua incapacità di spiegare le sue decisioni agli utenti. Per affrontare questo problema, è emersa una nuova branca dell’IA spiegabile (XAI), ei ricercatori stanno attivamente perseguendo metodologie diverse per stabilire un’intelligenza artificiale di facile utilizzo.

Ma per quanto riguarda gli approcci XAI esistenti ? Sono buoni? Dove falliscono? Per rispondere a queste domande, un team di ricercatori della UC Berkeley e della Boston University hanno studiato le sfide e le possibili soluzioni. La loro esplorazione ha portato a una nuova tecnica che sarà discussa nell’ultima sezione di questo articolo.

Spiegare l’Inspiegabile

Per illustrare l’inesplicabilità, uno degli autori, Alvin Wan, in un blog , ha usato l’esempio delle mappe di salienza e degli alberi decisionali.

Le mappe di salienza sono un tipo di mappe di calore che mostrano la concentrazione di pixel in alcune aree di un’immagine. Queste informazioni vengono utilizzate per acquisire conoscenze sulla logica alla base di determinate previsioni. Le mappe di salienza sono uno dei metodi XAI ampiamente utilizzati. Anche se entrambe le mappe di salienza evidenziano l’oggetto corretto, ha scritto Wan, alcune previsioni sono errate e rispondere a questo potrebbe aiutarci a migliorare il modello.

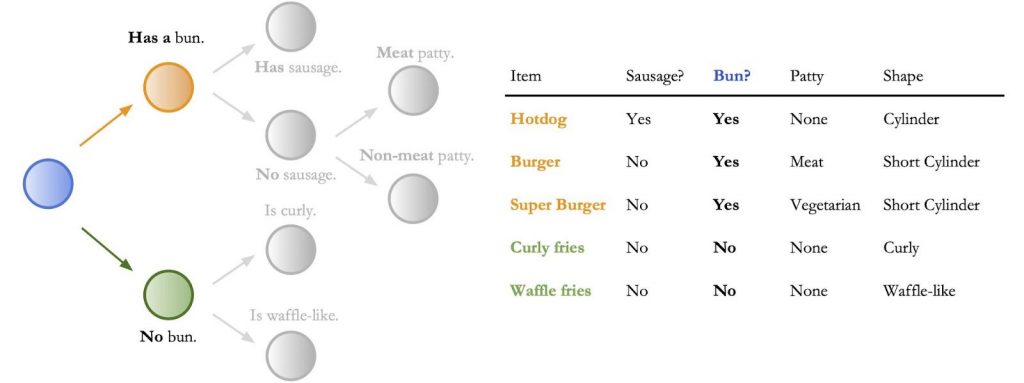

Considerando che, usare gli alberi delle decisioni per spiegare le previsioni dell’IA è più tradizionale delle mappe di salienza.

L’immagine sopra è una rappresentazione di come un algoritmo può operare attraverso i rami per classificare un hamburger. Tuttavia, Wan ha osservato che gli alberi decisionali sono in ritardo rispetto alle reti neurali con un’accuratezza fino al 40% sui set di dati di classificazione delle immagini. Con i dati tabulari a bassa dimensione, come mostrato sopra, le regole di decisione in un albero decisionale sono semplici da interpretare. Ad esempio, se il piatto contiene un panino, scegli il bambino giusto, come mostrato. Tuttavia, le regole decisionali non sono così semplici per input come le immagini ad alta dimensione.

Quindi, per preservare l’alta interpretabilità degli alberi delle decisioni e le prestazioni delle reti neurali, Wan e i suoi colleghi hanno introdotto un nuovo approccio: gli alberi decisionali sostenuti dai neuroni (NBDT).

Panoramica degli alberi decisionali sostenuti da neuroni

Non è la prima volta che gli alberi decisionali e l’apprendimento profondo vengono utilizzati in combinazione, ma i metodi esistenti, hanno scritto gli autori, hanno portato a modelli che hanno ottenuto risultati inferiori

accuratezze rispetto a quelle delle moderne reti neurali anche su piccoli set di dati (ad esempio MNIST), e richiedevano architetture significativamente diverse, costringendo i professionisti a fare un compromesso tra accuratezza e interpretabilità.

A differenza dei metodi precedenti, gli alberi decisionali sostenuti da neuroni dimostrano che l’interpretazione migliora con precisione.

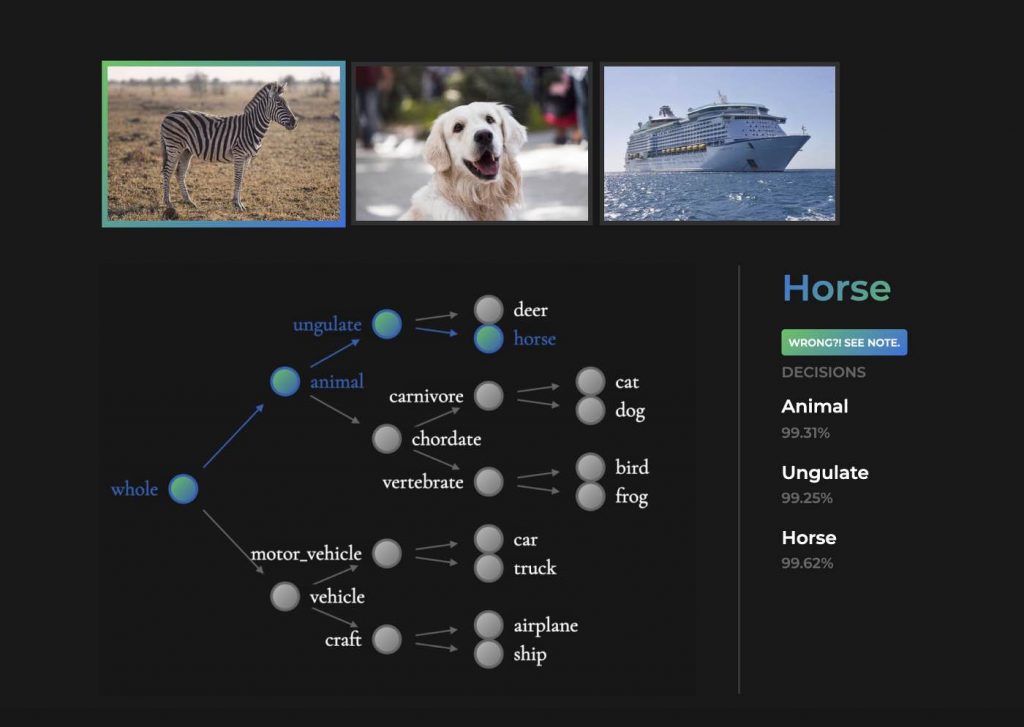

Quando un NBDT è stato utilizzato per eseguire inferenze sull’immagine di una zebra, il modello è stato in grado di fornire previsioni accurate anche a livello intermedio, ovvero mostra che una zebra è sia un animale che un ungulato (categoria zoccolata).

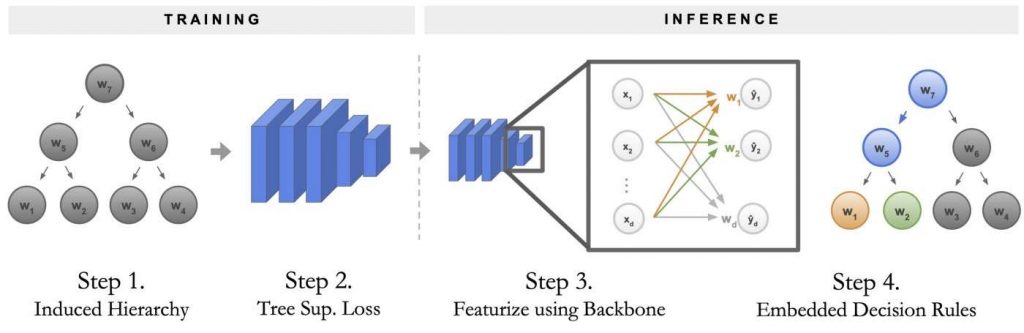

Il processo di addestramento e inferenza per un albero decisionale sostenuto da neuroni può essere suddiviso in quattro fasi:

Innanzitutto, viene costruita una gerarchia per l’albero decisionale chiamata Gerarchia indotta che determina quali insiemi di classi tra cui NBDT deve decidere.

Questa gerarchia produce una particolare funzione di perdita, chiamata Tree Supervision Loss, che viene utilizzata per addestrare la rete neurale originale, senza alcuna modifica.

Un campione viene passato attraverso la spina dorsale della rete neurale per deduzione.

L’inferenza viene completata eseguendo il livello finale completamente connesso come una sequenza di regole di decisione, che sono chiamate Regole di decisione integrate. Queste decisioni culminano nella previsione finale.

I risultati mostrano una riduzione del divario di precisione tra reti neurali e alberi decisionali all’1% su CIFAR10, CIFAR100, TinyImageNet e al 2% su ImageNet; avanzare lo stato dell’arte per i metodi interpretabili del ∼14% su ImageNet con un’accuratezza superiore all’1,70%.

Risultati chiave

L’intero lavoro può essere sintetizzato come segue:

Gli alberi decisionali sostenuti dai neuroni hanno contribuito a rimuovere il dilemma tra accuratezza e interpretabilità. È stato riscontrato che l’interpretabilità migliora con precisione

Qualsiasi rete neurale di classificazione può essere convertita in NBDT

Come effetto collaterale fortuito, la perdita di supervisione dell’albero aumenta anche l’accuratezza della rete neurale originale dello 0,5%